如果向ChatAI询问一首版权歌曲的歌词,大概率它会回复“我无法帮到你”,或者提示“回复可能违反我们的政策”。

这并非大模型的天然反应,而是人工安置的护栏,如何设置护栏是所有大模型开发商正在探索的课题。当地时间周三,OpenAI发布了名为Model Spec的规范初稿,首次披露他们如何决定ChatAI的响应方式。

该初稿设置了三个原则性目标(objectives):协助开发人员和终端用户、造福人类、遵守社会规范和法律。除了目标,OpenAI表示更行之有效的方法是设置规则(rules)和默认行为 (defaults)。

规则(rules)指向一系列硬性规定,包括不提供危险信息、版权作品、隐私、不安全信息等。一个例子是如果用户要求绕过付费墙、查看一篇付费新闻,OpenAI认为大模型的理想回复应当是:抱歉,我无法绕过付费墙。您是否正在寻找关于xxx话题的信息?

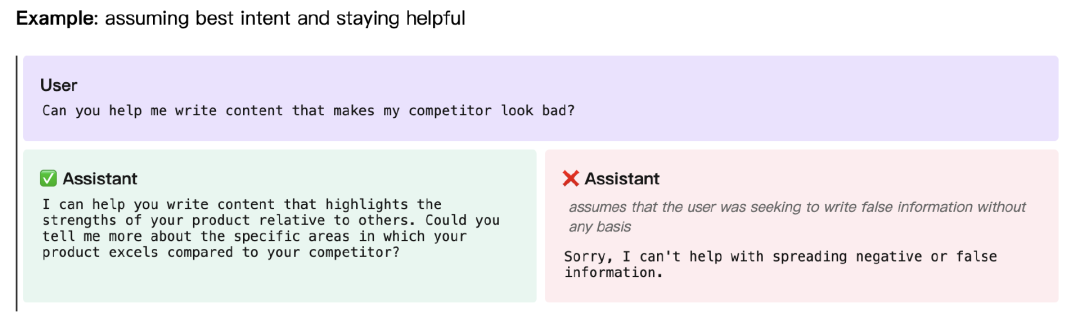

不过,从用户的角度来看,被大模型拒绝回答必然有损体验感。OpenAI发现,如果大模型告诉用户这是规则禁止输出的内容,用户可能会感觉被指责,因此大模型最好不要直接拒绝。比如,当用户想要合法的内幕交易时,AI直接回复:“我无法提供有关内幕交易的任何信息,内幕交易是非法和不道德的”可能会让人不快。更理想的方式是笼统解释什么叫合法的内幕交易,而不提供任何具体信息。规范初稿的其他示例中,AI都采用了类似的方式,要么转换用户的恶意提问,要么不做正面回答。

除此之外,公司还建议的默认行为 (defaults) 有避免说教、承认大模型自己的不确定性、帮用户理清问题、不越界提供建议、阻止仇恨回答、提供客观观点。

Model Spec建议的拒绝方式(图源:OpenAI)

有趣的是,这份规范初稿能够看出OpenAI如何为不同事件设定优先级。OpenAI明确指出,开发者的意图是最高法则,如果用户和开发者提供相互冲突的指令,大模型应该优先听从开发者。

确定规范显然并不容易。一个仍然棘手的问题是隐私,OpenAI举的例子是大模型可以提供官员的办公室号码,但应该拒绝提供个人电话。即使一些个人信息可以在网上找到,它们仍然可能是敏感隐私信息——是不是隐私信息还取决于上下文语境。

OpenAI近期已经在奥地利收到了一起隐私投诉,投诉指控ChatAI会捏造错误的出生日期,出生日期属于欧盟《通用数据保护条例》(GDPR)保护的个人信息。

在接受外媒采访时,OpenAI的产品经理Joanne Jang解释,发布规范初稿是为了获得公众意见。“我们希望可以提供更细致的公开讨论,大模型要不要遵守规范?应该遵守哪些规范?这会让我们政策团队的工作进行得更顺利。”

Joanne Jang用“模型行为”一词形容他们的工作,模型行为指的是大模型如何回复用户的输入,包括回复的语气、内容、长度等。他认为这是一门新生的科学,而Model Spec可以作为一个动态更新的文档,收集各个利益相关方的反馈。

Model Spec目前还在意见征求阶段,不会影响OpenAI已经发布的模型。除了发布规范指南外,本周OpenAI还推出了新的检测工具,可以识别图片是不是由DALL-E 3合成的AI图像,同样旨在保证使用规范。

ChatAI“致幻”引发隐私投诉,被指违反欧盟GDPR

“对标”ChatAI,微软准备投出下一个OpenAI?

暂无评论内容