如何复盘大模型技术爆发的这一年?除了直观的感受,你还需要一份系统的总结。

今天,斯坦福 HAI 研究所发布了第七个年度的 AI Index 报告,这是关于人工智能行业现状的最全面的报告之一。

报告指出,人工智能的发展正以惊人的速度向前推进,开发人员每月都在制造出越来越强大、越来越复杂的模型。然而,尽管发展速度加快,人工智能行业在解决人们对人工智能可解释性的担忧以及对其对人们生活影响的日益紧张方面却进展甚微。

在今年的报告中,斯坦福 HAI 研究所增加了有关负责任人工智能的扩展章节,有关科学和医学领域人工智能的新章节,以及对研发、技术性能、经济、教育、政策和治理、多样性和公众舆论的综述。

以下是报告的重点内容:

- 2023 年的进展速度比以往任何一年都要快得多,GPT-4、Gemini 和 Claude 3 等最先进的系统显示出令人印象深刻的多模态功能,能够生成流畅的数据多种语言的文本、处理音频和图像以及解释网络梗图。

- 2023 年新发布的支持生成式 AI 的大型语言模型数量比前一年翻了一番,其中三分之二是开源模型,例如 Meta 的 Llama 2,但性能最佳的是闭源模型,例如 Google 的 Gemini Ultra。

- 2023 年,工业界继续主导人工智能前沿研究。工业界产生了 51 个值得关注的机器学习模型,而学术界仅贡献了 15 个。2023 年,产学界合作产生了 21 个值得关注的模型,再创新高。

- 美国领先中国、欧盟和英国,成为顶级人工智能模型的主要来源地。2023 年,61 个著名的人工智能模型源自美国机构,远远超过欧盟的 21 个和中国的 15 个。

- Gemini Ultra 是第一个在大规模多任务语言理解关键基准测试中达到人类水平表现的 LLM。OpenAI 的 GPT-4 也不甘示弱,在 Holistic Evaluation of Language Models 基准上取得了 0.96 的平均胜率得分,该基准将 MMLU 与其他评估结合起来。

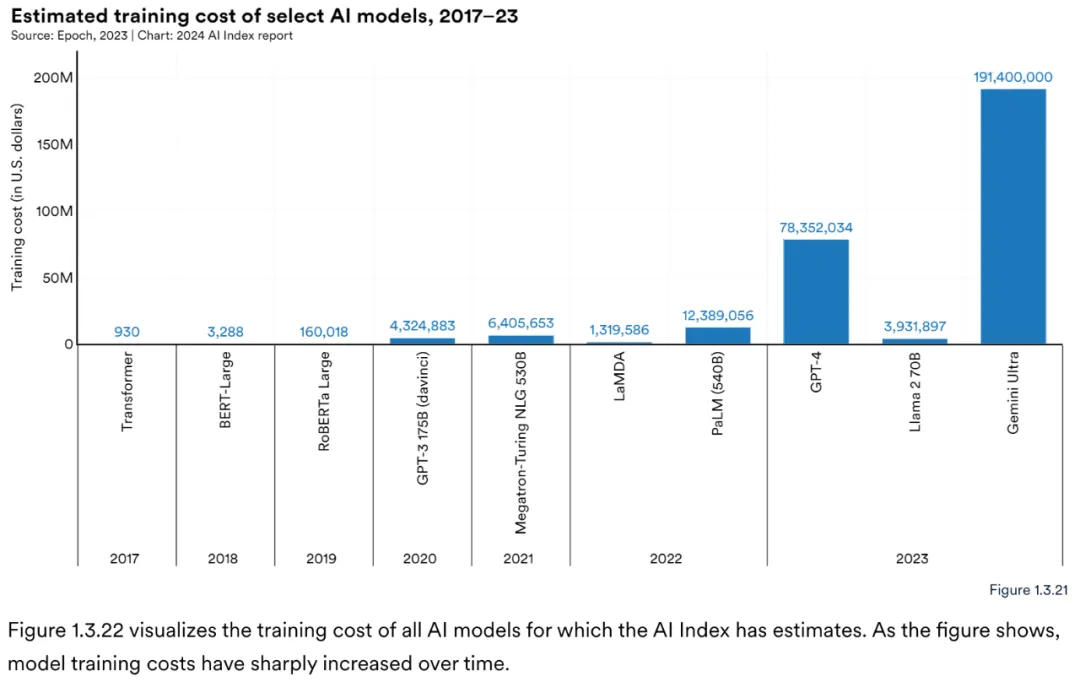

- 不过,人工智能性能的提高是有代价的,报告发现,前沿人工智能模型的开发成本正变得越来越高。据说 Gemini Ultra 消耗了价值 1.91 亿美元的计算资源,而 GPT-4 的开发成本估计为 7800 万美元。

企业对生成式 AI 投资猛增

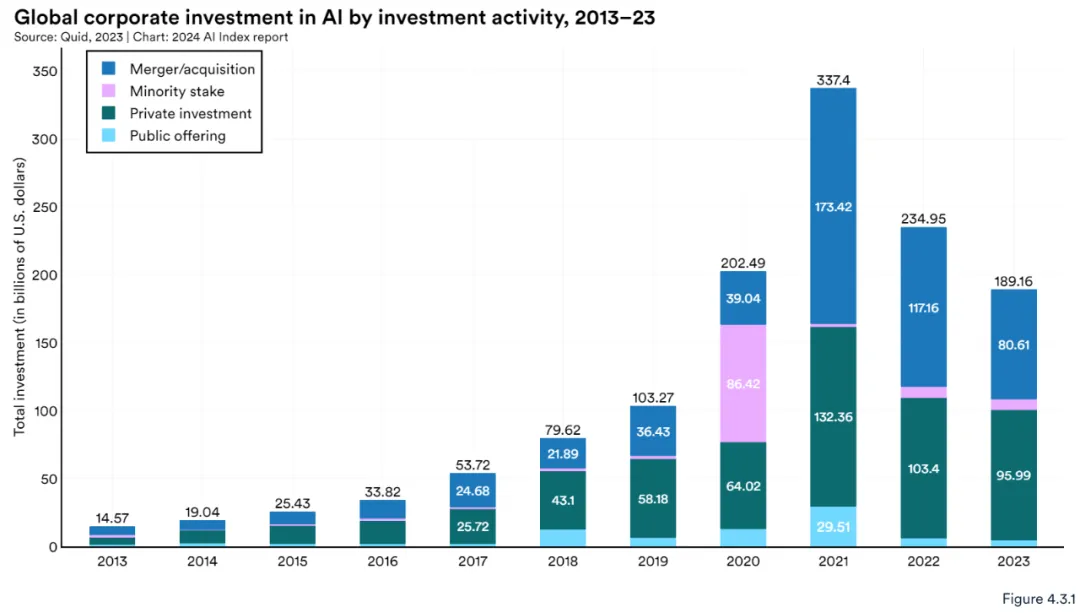

图 4.3.1 展示了 2013 年至 2023 年全球企业人工智能投资趋势,包括并购、少数股权、私募投资和公开发行。全球企业对人工智能的投资连续第二年下降。

2023 年,总投资下降至 1892 亿美元,较 2022 年下降约 20%。然而,在过去十年中,企业对人工智能相关投资增加了十三倍。

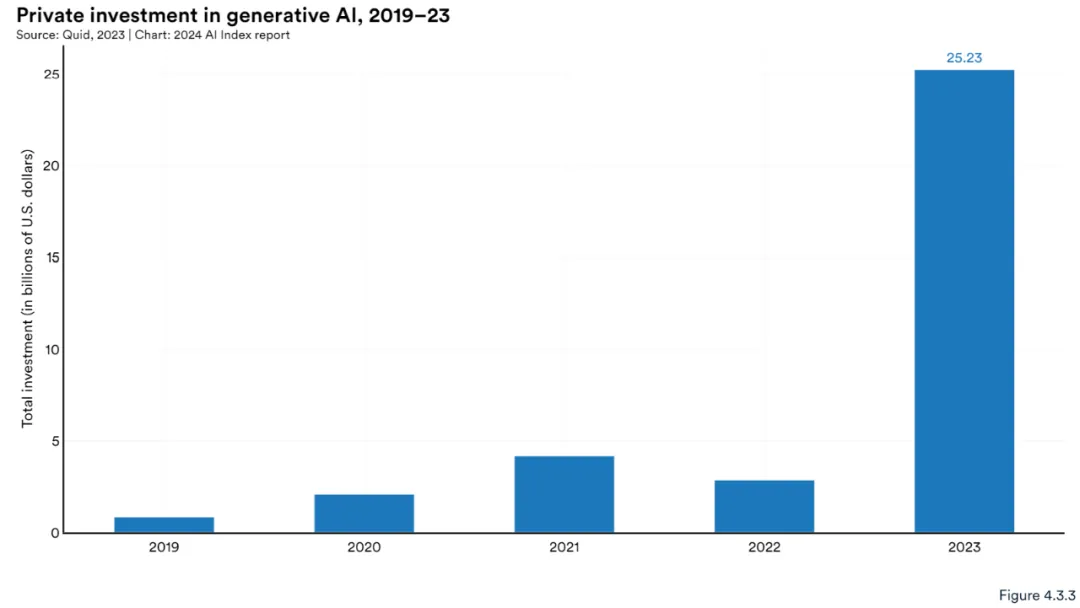

图 4.3.3 表明,AI 行业吸引了 252 亿美元的投资,几乎是 2022 年投资的九倍,是 2019 年投资额的约 30 倍。此外,生成式人工智能占 2023 年所有人工智能相关私人投资的四分之一以上。

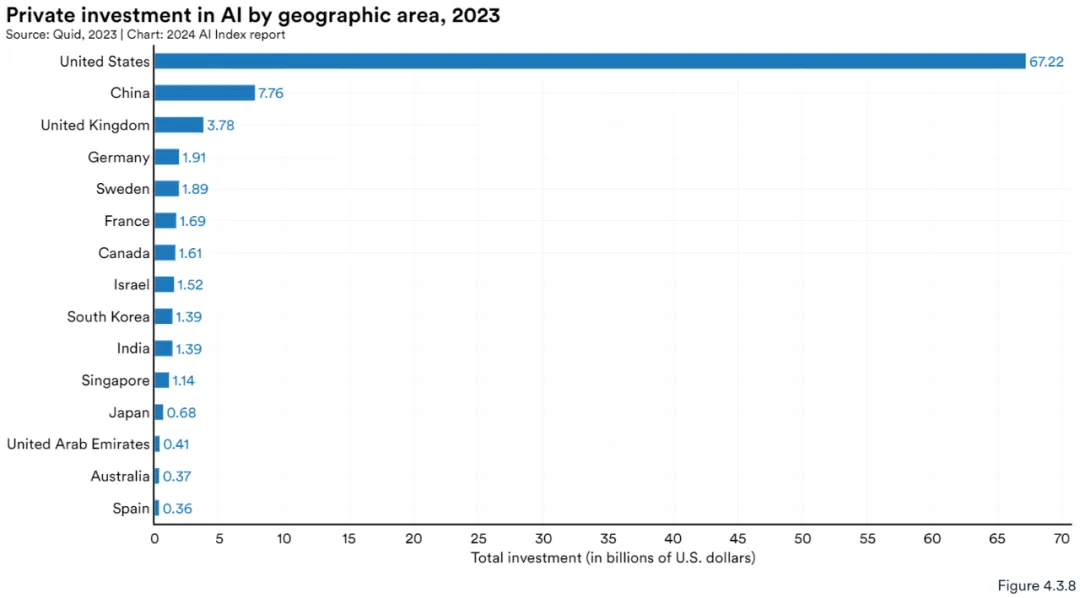

假如按区域进行比较,美国在人工智能私人投资总额方面再次领先世界。2023 年,美国投资额为 672 亿美元,大约是第二高国家中国投资额(78 亿美元)的 8.7 倍,是英国投资额(38 亿美元)的 17.8 倍(图 4.3.8)。

谷歌在基础模型竞赛中占据主导地位

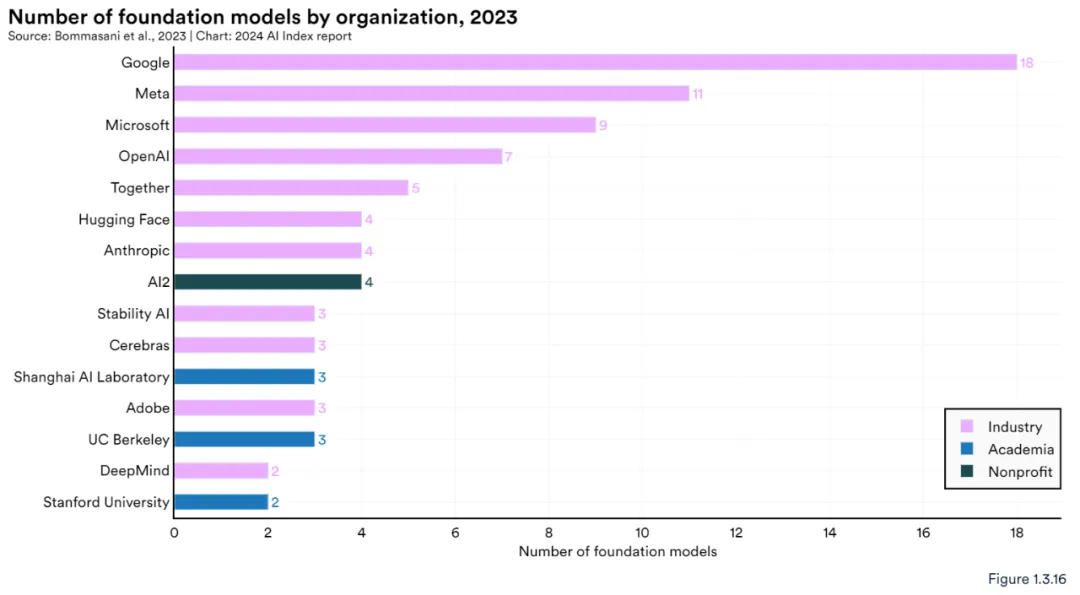

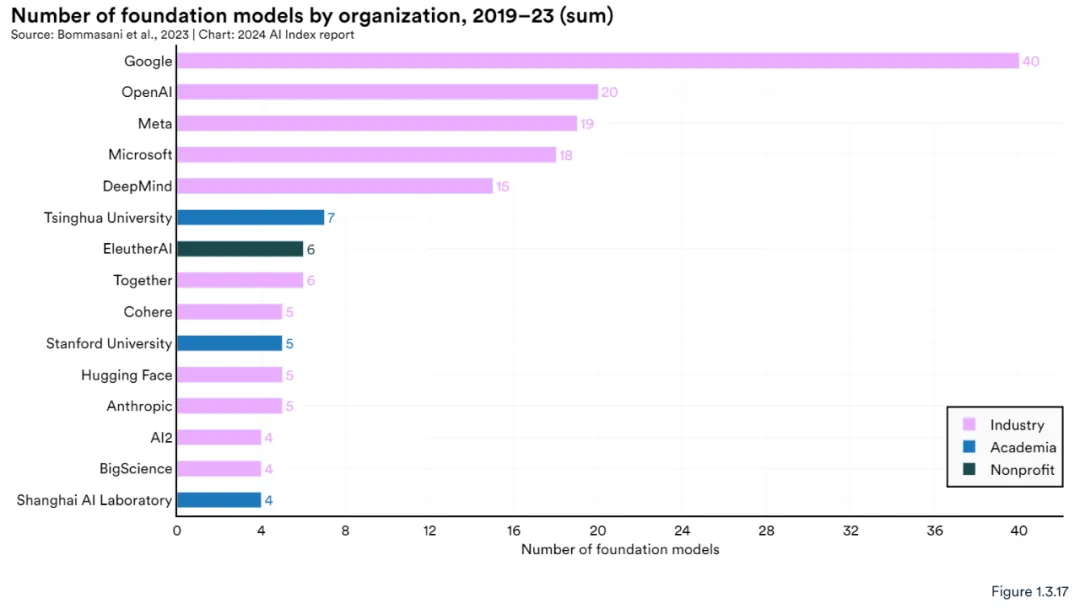

报告显示,谷歌在 2023 年发布的基础模型最多,图 1.3.16 总结了 2023 年各个机构发布的各种基础模型。Google 发布了最多的模型(18 个),其次是 Meta(11 个)和 Microsoft(9 个)。2023 年发布基础模型最多的学术机构是加州大学伯克利分校 (3 个)。

自 2019 年以来,Google 发布的基础模型数量最多,共有 40 个,其次是 OpenAI,有 20 个(图 1.3.17)。清华大学也脱颖而出,发布了七个基础模型,而斯坦福大学是美国领先的学术机构,发布了五个模型。

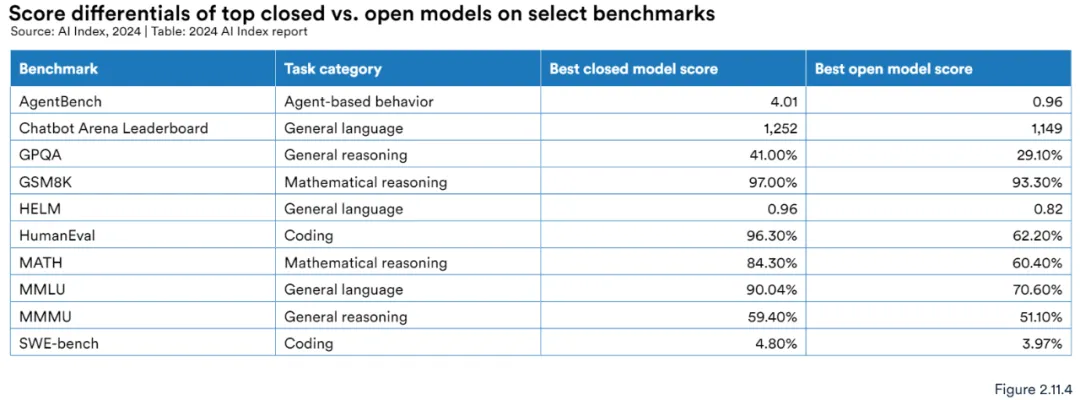

闭源模型优于开源模型

图 2.11.4 和 2.11.5 将闭源模型与开源模型在选定的基准上进行了对比。在所有选定的基准上,闭源模型的表现均优于开源模型。

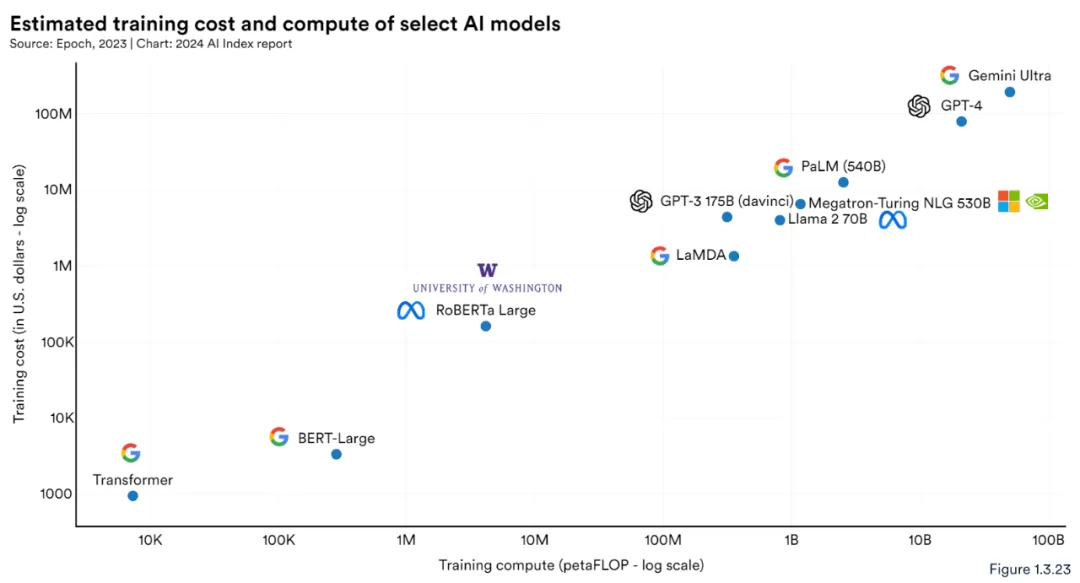

训练成本

关于基础模型,一个绕不开的话题是推理成本。尽管人工智能公司很少透露训练模型所涉及的费用,但人们普遍认为这些成本已达到数百万美元,并且还在不断上升。例如,OpenAI 首席执行官 Sam Altman 曾提到,GPT-4 的训练成本超过 1 亿美元。

图 1.3.21 根据云计算租赁价格直观地显示了与选定 AI 模型相关的训练成本。下图表明近年来模型训练成本大幅增加。例如,2017 年 Transformer 模型训练成本约为 900 美元。2019 年发布的 RoBERTa Large 训练成本约为 160,000 美元。2023 年,OpenAI 的 GPT-4 和 Google 的 Gemini Ultra 的训练成本预计分别约为 7800 万美元和 1.91 亿美元。

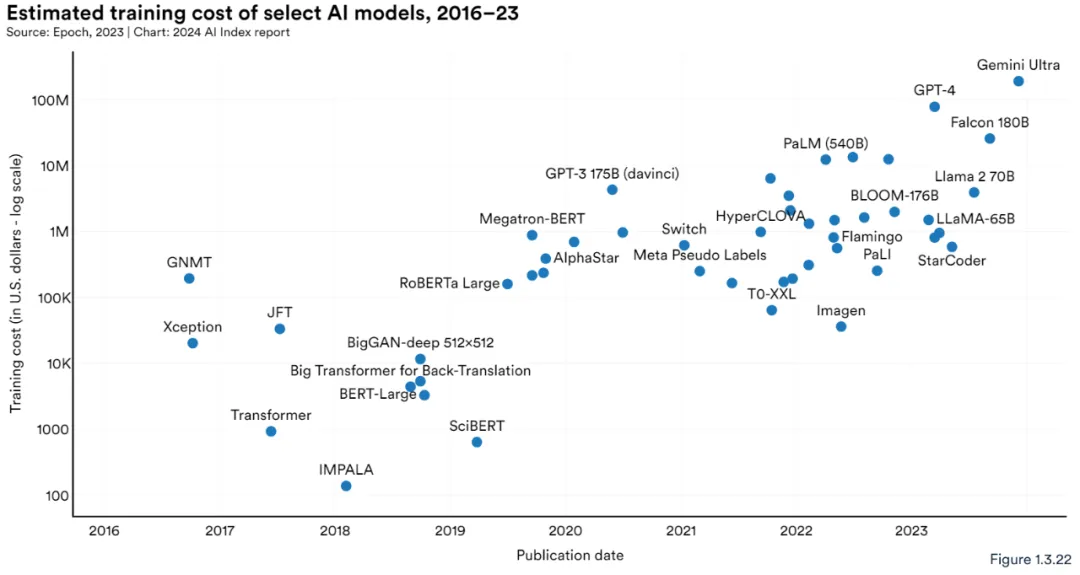

图 1.3.22 显示了 AI Index 估计的所有 AI 模型的训练成本。如图所示,随着时间的推移,模型训练成本急剧增加。

如图 1.3.23 所示,对计算训练需求更大的模型需要的训练成本更多。

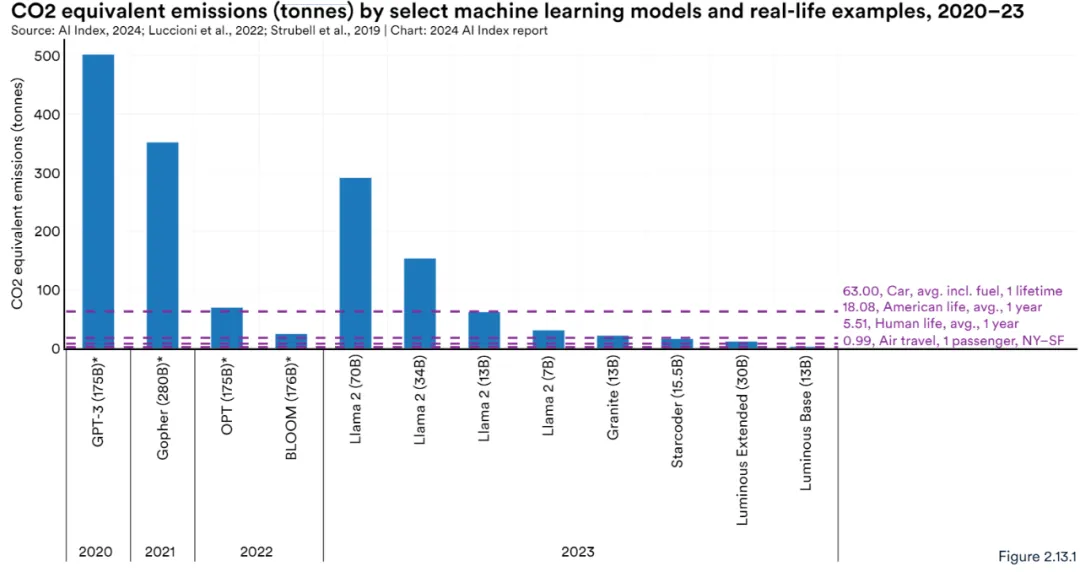

碳足迹

图 2.13.1 显示了选定 LLM 在训练期间释放的碳(以吨为单位)的比较。例如,Meta 发布的 Llama 2 70B 模型释放了约 291.2 吨碳,这比一位旅客从纽约到旧金山的往返航班所释放的碳排放量高出近 291 倍,大约是普通美国人一年碳排放量的 16 倍。然而,Llama 2 的排放量仍低于 OpenAI GPT-3 训练期间报告的 502 吨排放量。

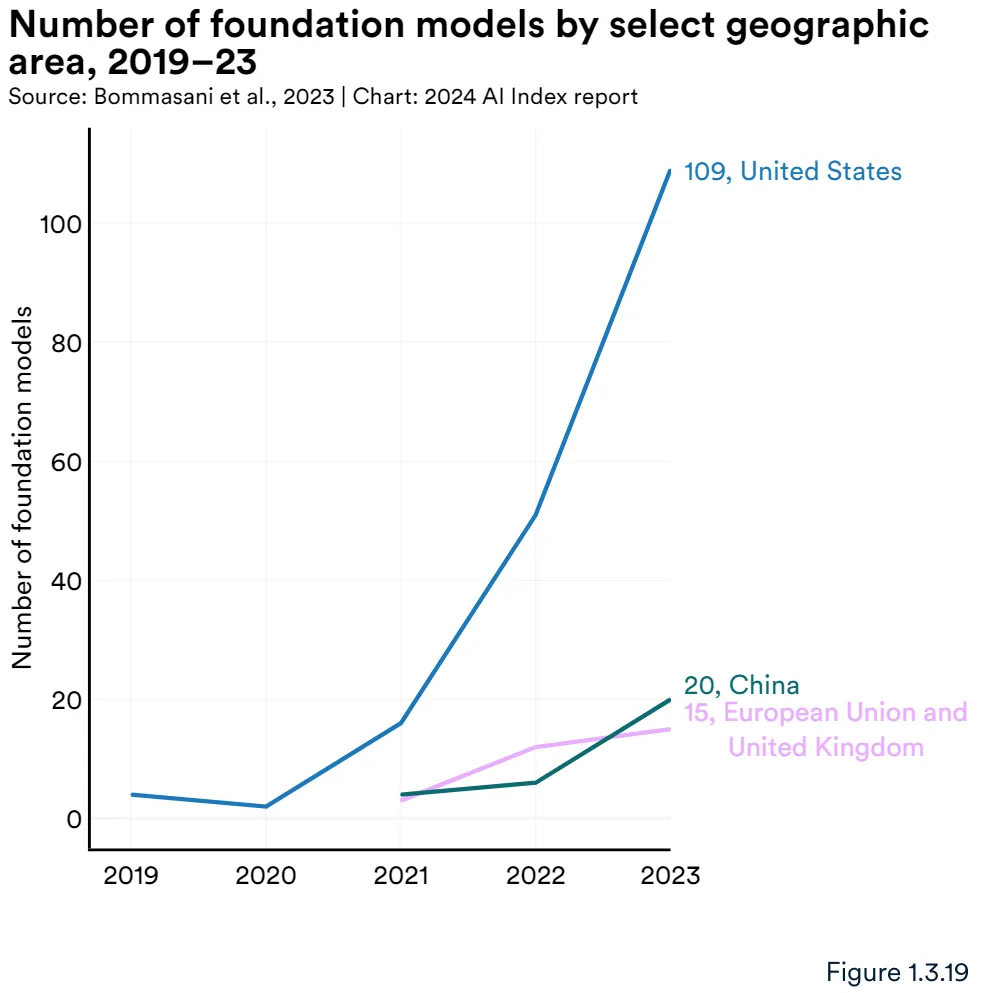

美国在基础模型方面处于领先位置

2023 年,全球大部分基础模型源自美国(109 个),其次是中国(20 个)和英国(图 1.3.18)。自 2019 年以来,美国在大多数基础模型的研发方面一直处于领先地位(图 1.3.19)。

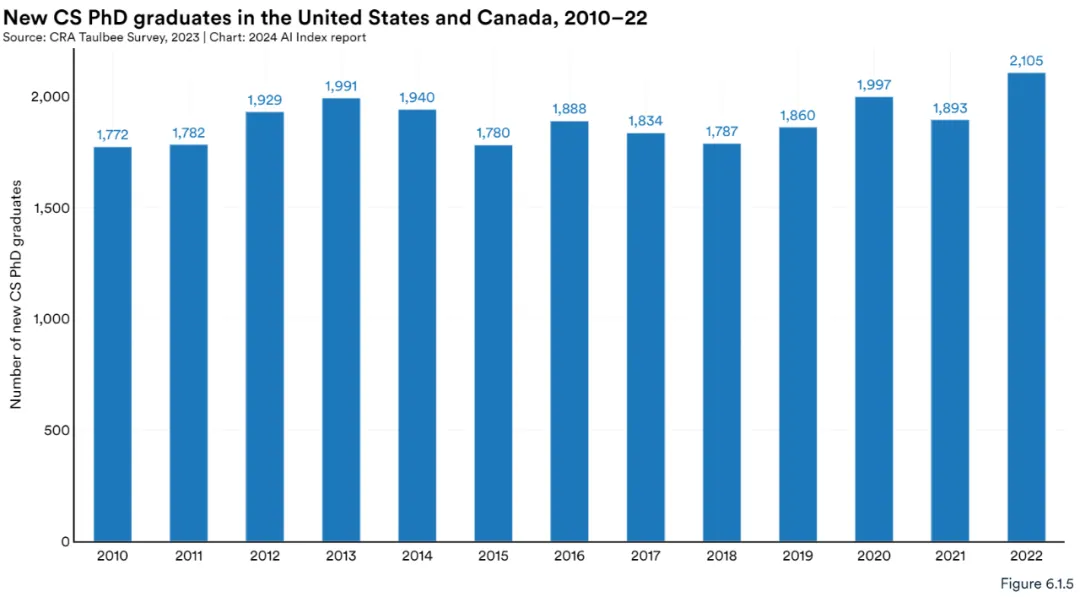

CS 博士毕业生

美国和加拿大计算机科学博士毕业生数量十年来首次显著增加。2022 年,计算机科学博士毕业生人数达到 2105 人,为 2010 年以来最高(图 6.1.5)。

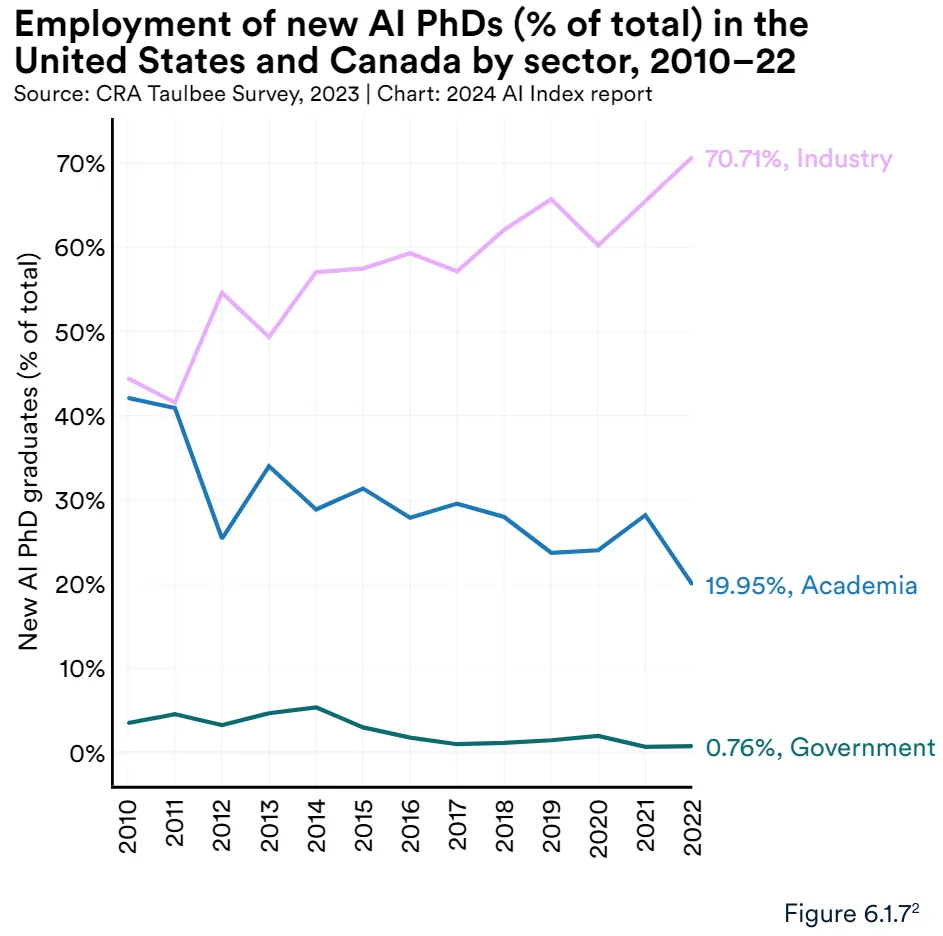

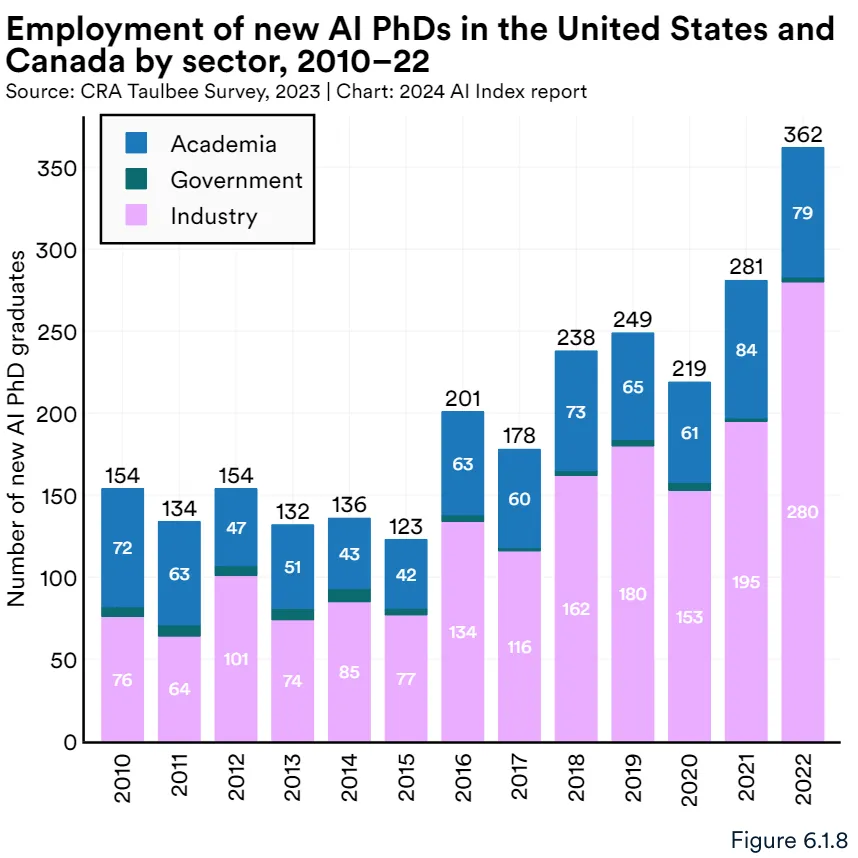

越来越多的 AI 博士毕业生在工业界寻求职业生涯(图 6.1.7 和图 6.1.8)。2011 年,工业界(40.9%)和学术界(41.6%)的就业比例大致相同。然而,到 2022 年,与进入学术界的人 (20.0%) 相比,毕业后进入工业界的比例 (70.7%) 明显更高。过去 5 年,进入政府职位的 AI 博士比例一直保持在相对较低的水平,稳定在 0.7% 左右。

考生类别增加

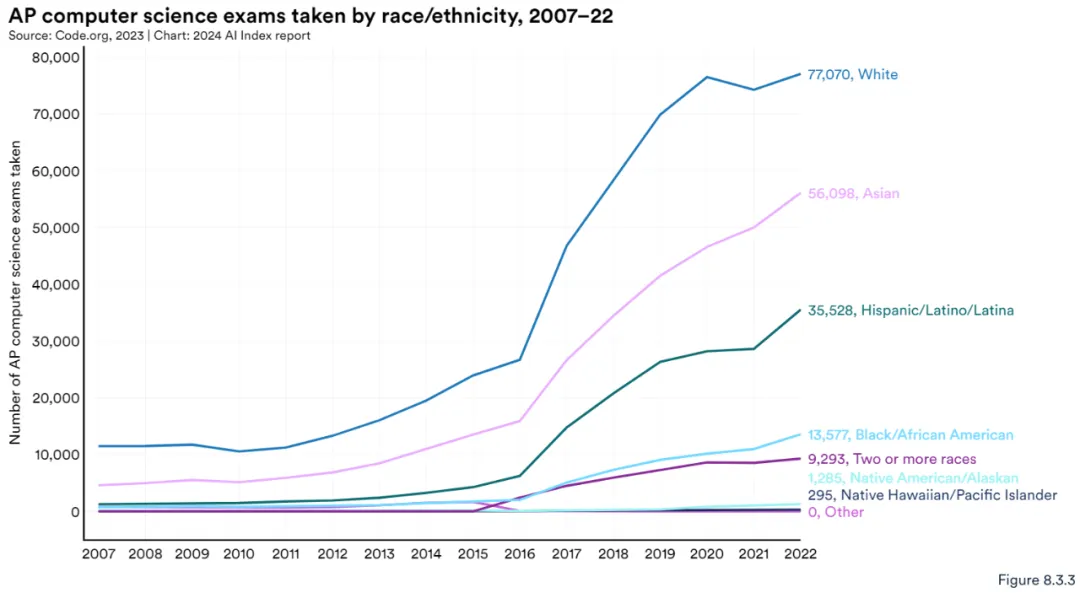

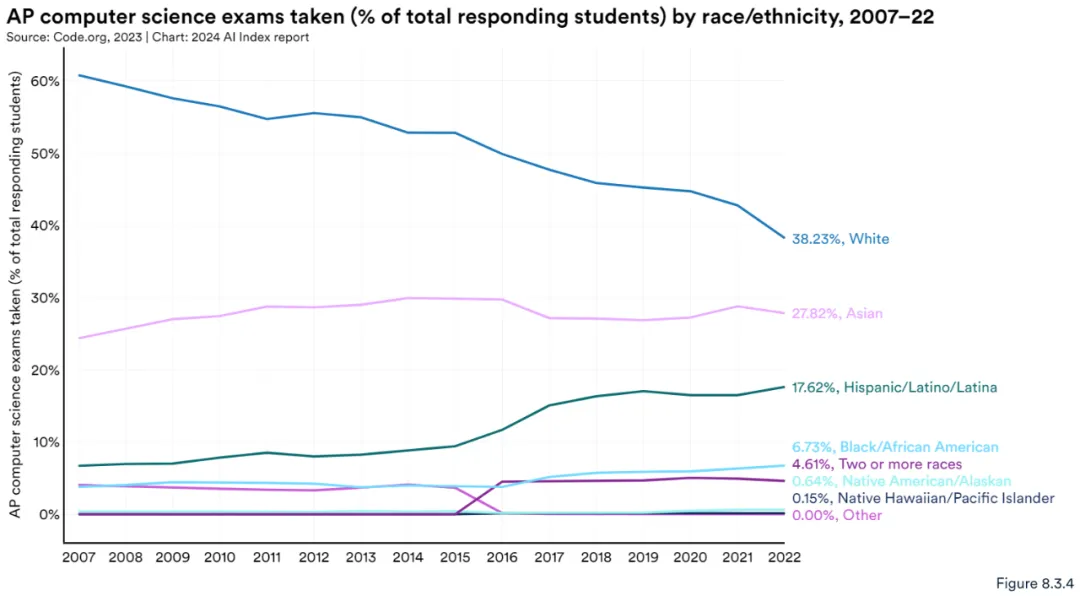

下图所示 AP CS 考生的种族多样性正在增加。虽然白人学生仍然是最大的群体,但随着时间的推移,亚裔、西班牙裔 / 拉美裔等学生参加 AP CS 考试的人数不断增加(图 8.3.3)。2022 年,白人学生在考生中所占比例最大(38.2%),其次是亚裔学生(27.8%)(图 8.3.3 和图 8.3.4)。

财报电话会议

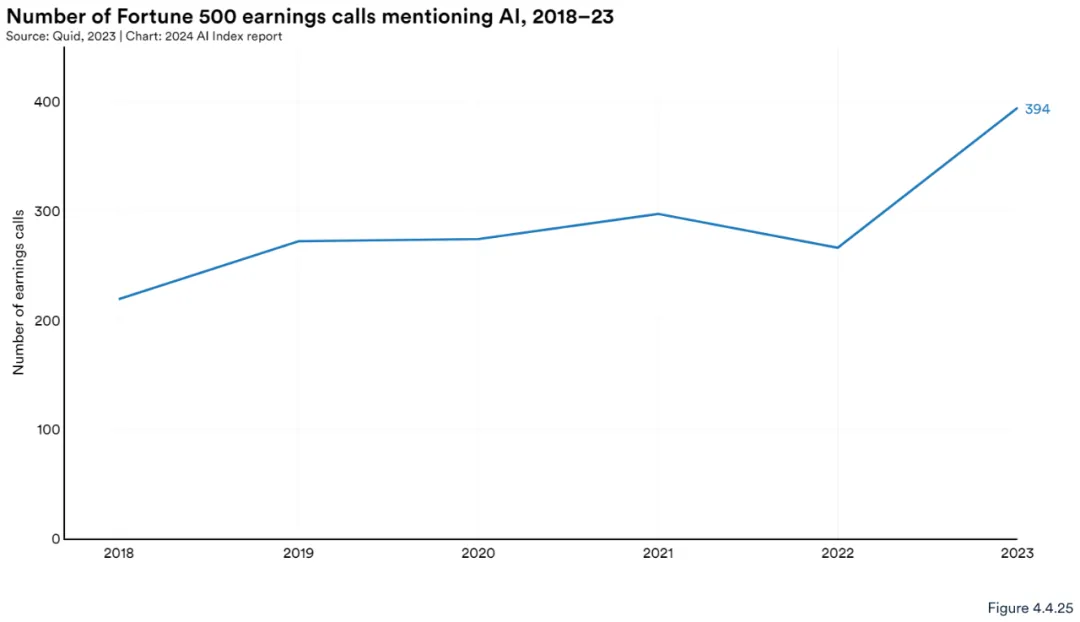

去年,财富 500 强公司财报电话会议中提及人工智能的次数显著增加。2023 年,有 394 场财报电话会议提到了人工智能(占所有财富 500 强公司的近 80%),高于 2022 年的 266 场(图 4.4.25)。自 2018 年以来,财富 500 强财报电话会议中提及人工智能的次数几乎增加了一倍。

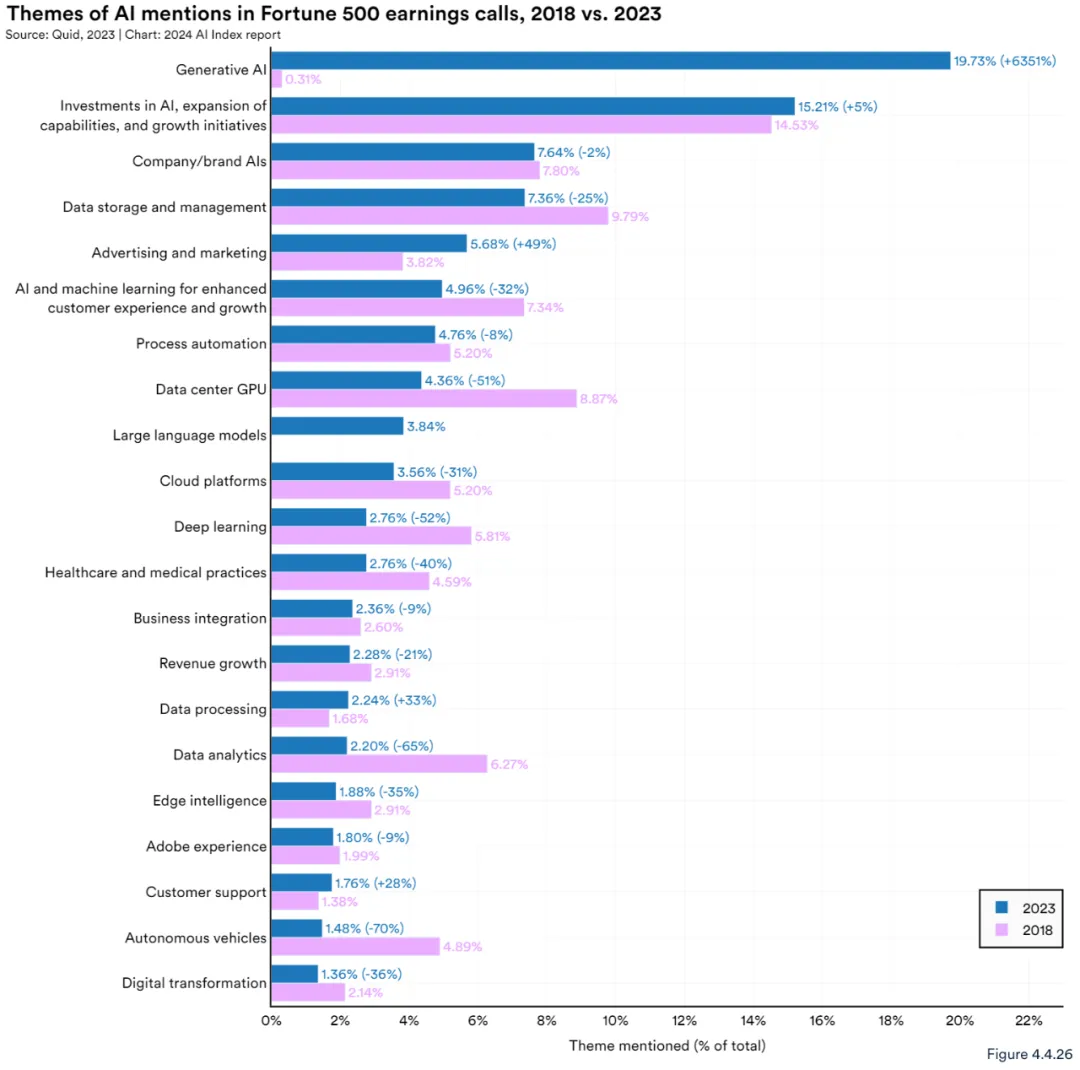

涉及的主题非常广泛,最常被提及的主题是生成式人工智能,占所有财报电话会议的 19.7%(图 4.4.26)。

成本下降,收入上升

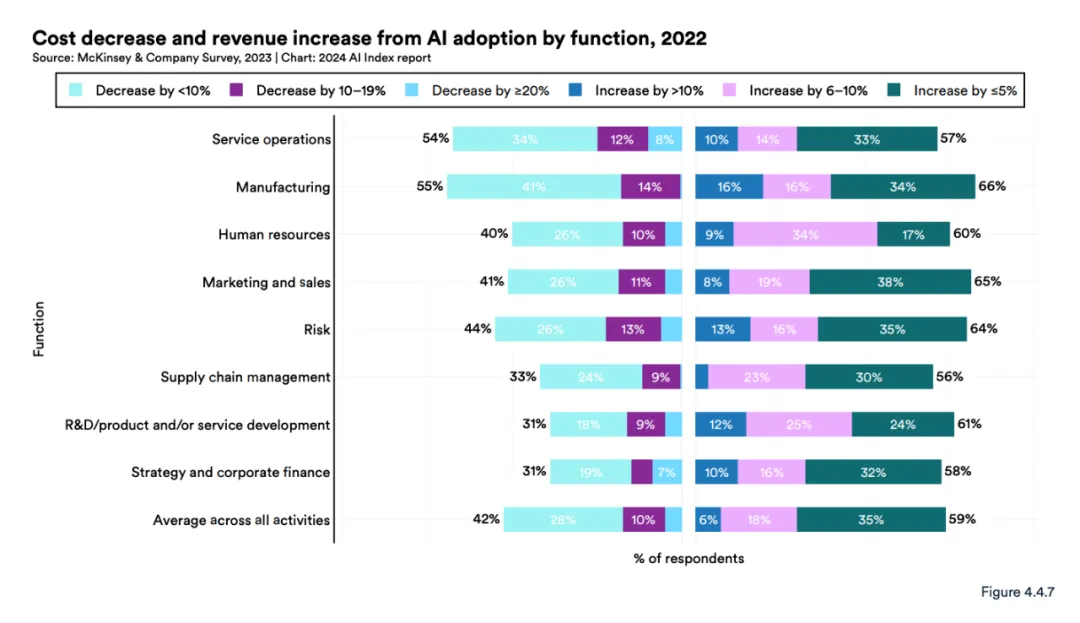

人工智能不仅仅是企业的流行语:麦肯锡的同一项调查显示,人工智能的整合使企业成本下降,收入增加。总体而言,42% 的受访者表示他们的成本降低了,59% 的受访者表示收入增加了。

2023 年,不同领域的多项研究表明,人工智能使工人能够更快地完成任务,并提高工作质量。其中一项研究考察了使用 Copilot 的编程人员,其他研究则考察了顾问、呼叫中心代理和法律专业学生。研究还表明,虽然每个工人都能从中受益,但人工智能对低技能工人的帮助要大于对高技能工人的帮助。

企业确实感知到了风险

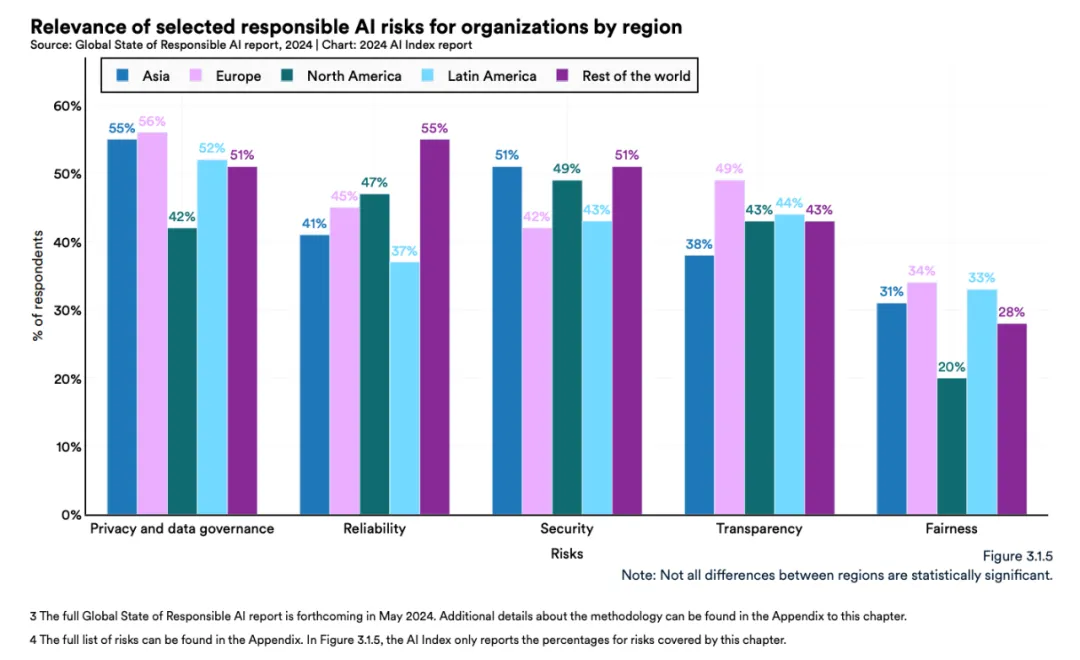

报告对收入至少在 5 亿美元以上的 1000 家公司进行了一次全球调查,以了解企业如何看待负责任的人工智能。

结果显示,隐私和数据管理被认为是全球最大的风险,而公平性(通常以算法偏见的形式讨论)仍未被大多数公司所重视。

一张图表显示,企业正在针对其感知到的风险采取行动:各地区的大多数企业都针对相关风险实施了至少一项负责任的人工智能措施。

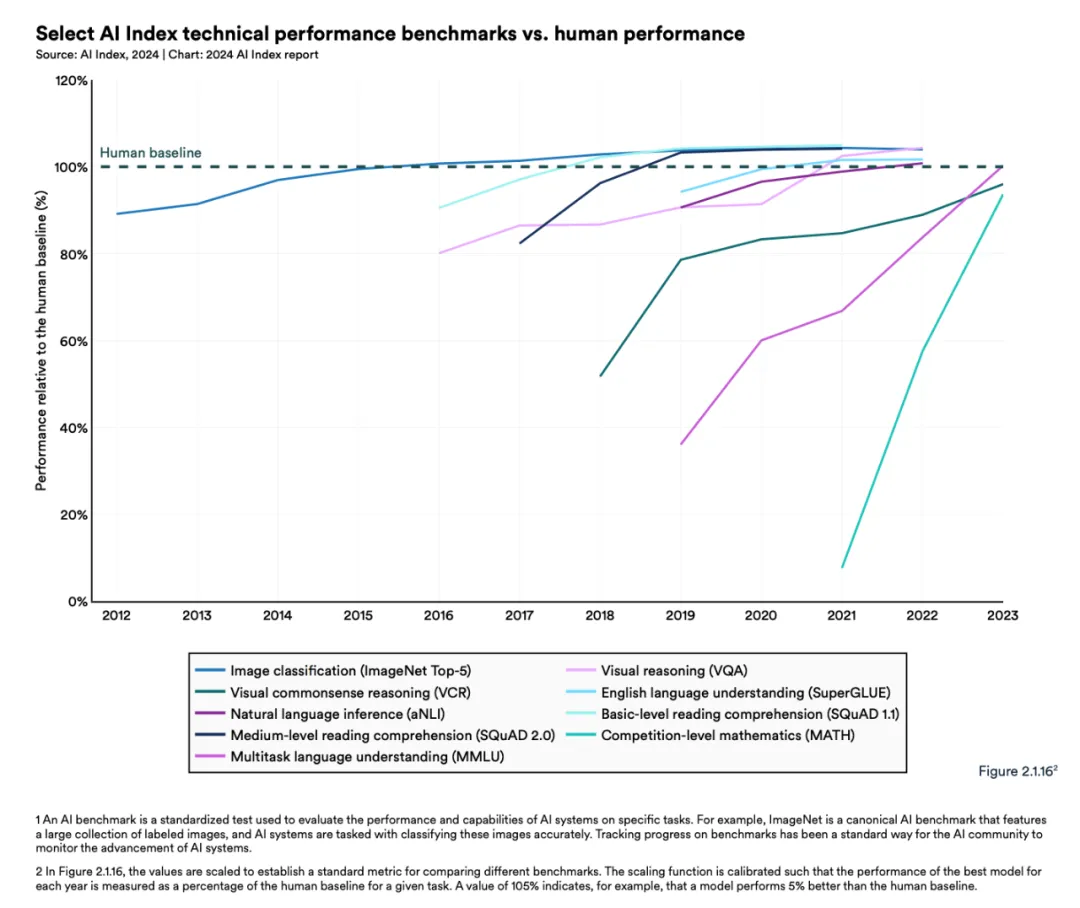

人工智能还不能在所有事情上击败人类……

近年来,人工智能系统在阅读理解和视觉推理等一系列任务上的表现都优于人类,如 2015 年的图像分类、2017 年的基础阅读理解、2020 年的视觉推理和 2021 年的自然语言推理。

但在一些复杂的认知任务中,人类的表现仍然优于人工智能系统,如视觉常识推理和高级数学问题解决(竞赛级数学问题),让我们明年再看看情况如何。

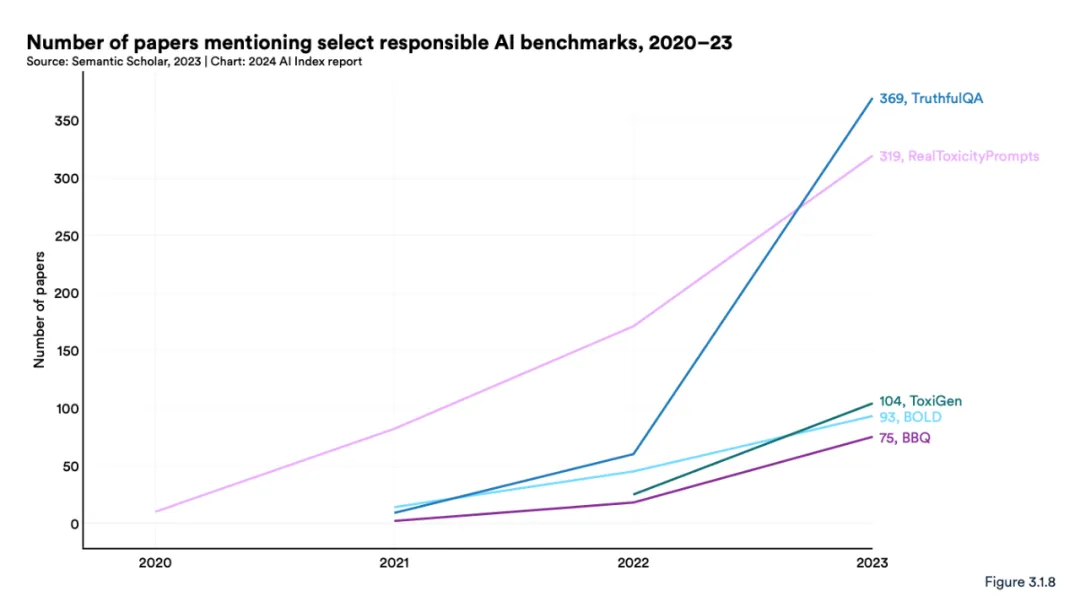

制定人工智能责任规范

当一家人工智能公司准备发布一个大模型时,标准做法是根据该领域的流行基准对其进行测试,从而让社区了解模型在技术性能方面是如何相互叠加的。然而,根据负责任的人工智能基准对模型进行测试的做法并不多见,这些基准主要评估有毒语言输出(RealToxicityPrompts 和 ToxiGen)、反应中的有害偏差(BOLD 和 BBQ)以及模型的真实程度(TruthfulQA)。这种情况正在开始改变,因为人们越来越意识到,根据这些基准检查自己的模型是一件负责任的事情。

然而,报告中的一张图表显示,一致性还很欠缺:OpenAI、Google 和 Anthropic 在内的领先开发人员主要根据不同的负责任的 AI 基准测试他们的模型。这种做法使得系统地比较顶级人工智能模型的风险和局限性的工作变得更加复杂。

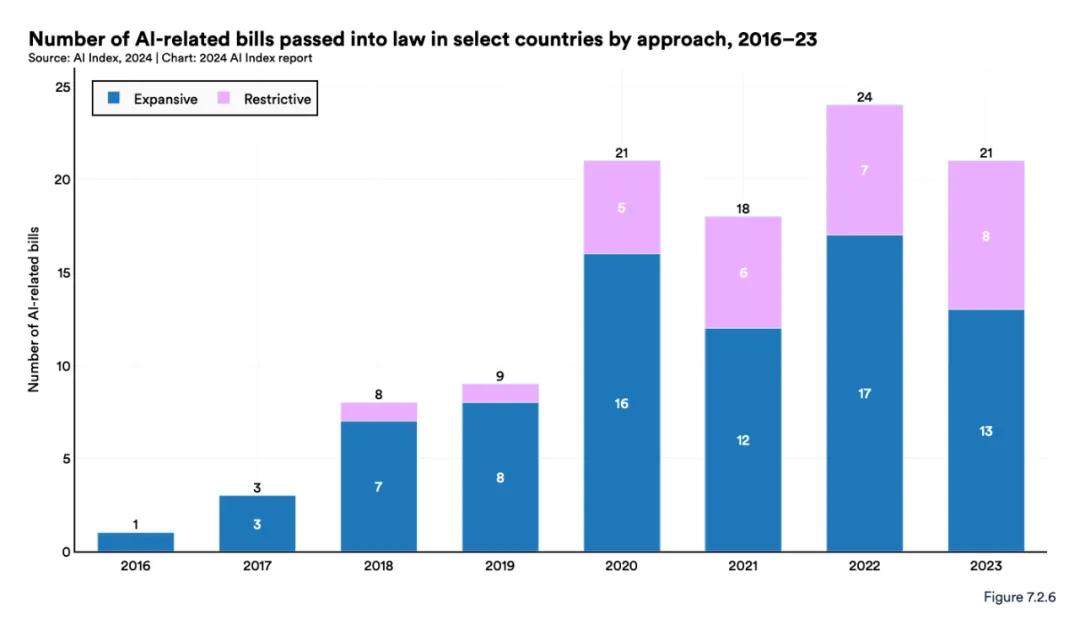

法律对人工智能的促进和限制

报告指出,在 2016 年至 2023 年期间,有 33 个国家至少通过了一项与人工智能有关的法律,其中大部分行动发生在美国和欧洲;在此期间,总共通过了 148 项与人工智能有关的法案。研究者还将法案分为旨在增强国家人工智能能力的扩张性法律和对人工智能应用和使用施加限制的限制性法律。

可以发现,虽然许多法案都在继续促进人工智能的发展,但限制性立法已成为全球趋势。

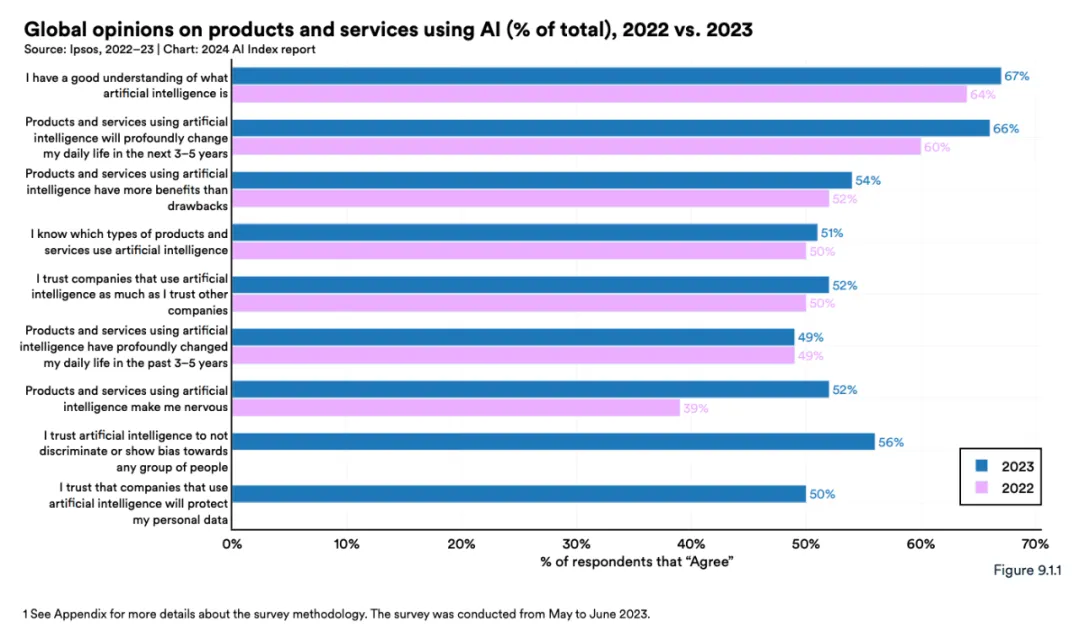

AI 正让人们变得紧张

报告的第九章是关于「公众观点」的,多伦多大学的一项国际调查显示,63% 的受访者知道 ChatGPT。在那些知道的人中,大约有一半的人每周至少使用 ChatGPT 一次。

但公众对人工智能的经济影响持悲观态度。在 lpsos 的一项调查中,只有 37% 的受访者认为人工智能将改善他们的工作。只有 34% 的人认为人工智能将促进经济,32% 的人认为它将促进就业市场。

这一指数的民意数据来自一项关于对人工智能态度的全球调查,31 个国家的 22816 名成年人(年龄在 16 岁至 74 岁之间)参与了调查。

超过半数的受访者表示,人工智能让他们感到紧张,而前一年这一比例为 39%。三分之二的人现在预计人工智能将在未来几年内深刻改变他们的日常生活。

该指数中的其他图表显示,不同人群的观点存在显著差异,年轻人更倾向于乐观地看待人工智能将如何改变他们的生活。

暂无评论内容