“

Nvidia的新款Blackwell B200 GPU和GB200“超级芯片”或将进一步巩固其在人工智能领域的领先地位。这些芯片性能强劲,能够在AI推理任务中提供高效能力,并在训练速度上取得了显著提升。Nvidia的新技术还包括改进的变压器引擎和下一代NVLink交换机,进一步提升了系统性能和效率。

Nvidia的H100人工智能芯片正在将其推向市值数万亿美元的巅峰,甚至有可能超过谷歌母公司Alphabet和电商巨头亚马逊,而与此同时,其竞争对手一直在不遗余力地追赶。然而,或许Nvidia即将通过其新推出的Blackwell B200 GPU和GB200“超级芯片”进一步扩大其领先优势。

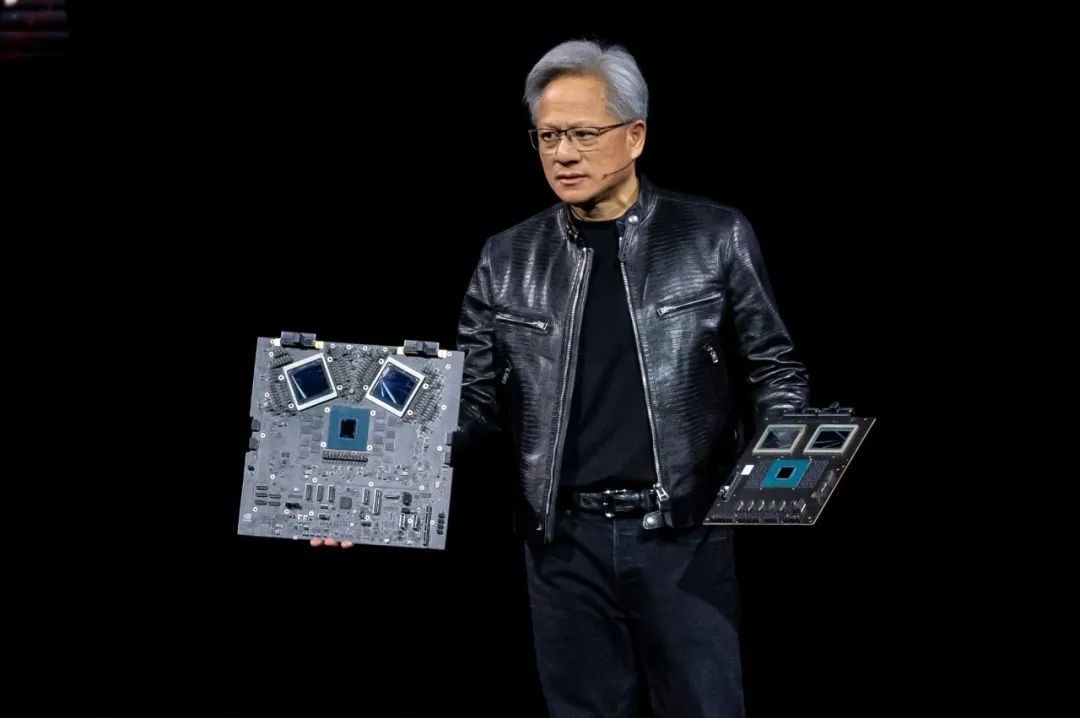

在Nvidia GTC 2024的主题演讲中,Nvidia首席执行官黄仁勋向数千名工程师发布了Blackwell,表示该产品将引领计算领域的变革。

黄先生表示:“三十年来,我们一直致力于加速计算,旨在实现深度学习和人工智能等变革性突破。生成式人工智能是我们时代的关键技术。Blackwell GPU是推动这场新工业革命的引擎。与全球最有活力的公司合作,我们将让AI对各行各业都带来改变。”

根据Nvidia提供的信息,基于Blackwell的计算机将使世界各地的组织能够以比其前身Hopper低25倍的成本和能耗在兆参数大型语言模型上构建和运行实时生成式AI。处理能力将扩展到具有高达10万亿参数的AI模型。

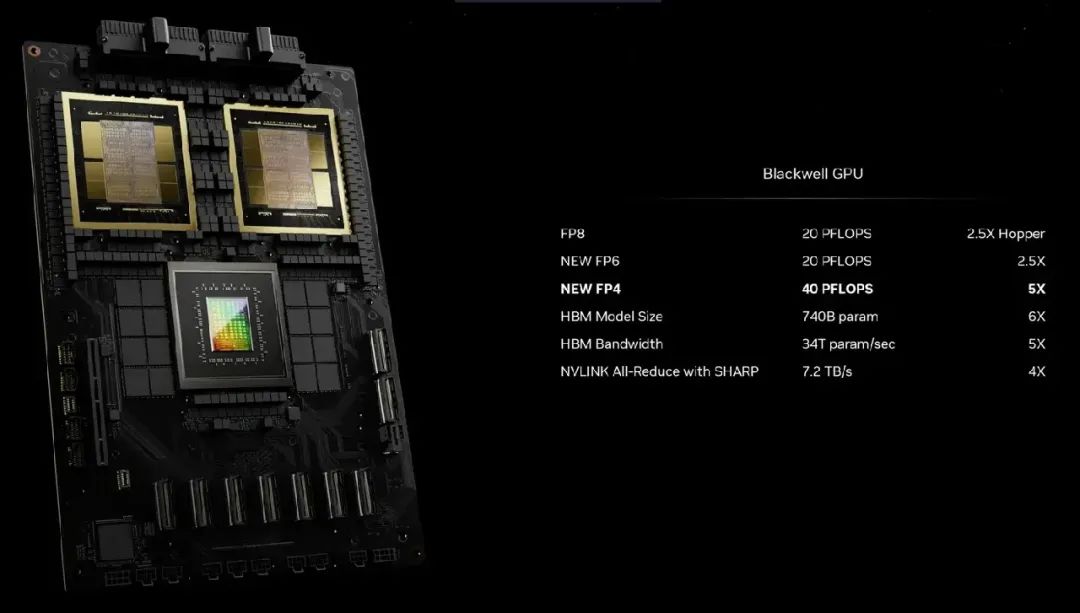

据称,Nvidia的新款B200 GPU拥有高达20P FP4的性能,搭载了来自2080亿个晶体管的先进技术。此外,结合两个这样的GPU与一个Grace CPU的GB200“超级芯片”在LLM推理工作负载下提供的性能将提高至30倍,同时可能具备更高的效率。Nvidia表示,相较于H100,它们已经将成本和能源消耗降低了多达25倍。

在以往的情况下,训练1.8万亿参数模型需要8000个Hopper GPU以及15兆瓦的功率,然而现在,Nvidia的CEO表示,仅需2000个Blackwell GPU即可在4兆瓦功率下完成任务。

在拥有1750亿个参数的GPT-3 LLM基准测试中,Nvidia声称GB200的性能为H100高出七倍,同时训练速度提高了四倍。

Nvidia告诉记者,其中一个关键改进是第二代变换器引擎,通过使用每个神经元的4位而不是8位(之前提到的FP4 20petaflops),使计算、带宽和模型大小翻倍。另一个关键区别在于连接大量GPU时的性能表现,这得益于一种下一代NVLink交换机,使得576个GPU之间的双向带宽达到每秒1.8TB。

这促使Nvidia构建了一整套全新的网络交换芯片,其中包含500亿个晶体管以及一些内置计算功能,据Nvidia表示,其计算能力可达每秒3.6 teraflops FP8。

Nvidia表示,此前仅有16个GPU的集群将60%的时间用于相互通信,而只有40%用于实际计算。

当然,Nvidia希望大量公司购买这些GPU,并将它们整合在更大的设计中,例如GB200 NVL72,该设计将36个CPU和72个GPU装入单个液冷机柜中,总计提供了720P AI训练性能或1,440P(即1.4exaflops)的推理性能。机柜内部有近两英里的电缆,涉及5000条单独的电缆。

每个机柜托盘包含两个GB200芯片或两个NVLink交换机,每个机柜有18个前者和9个后者。总的来说,Nvidia表示这种机柜可以支持一个27万亿参数模型,而据传闻,GPT-4的参数约为1.7万亿。

据称,亚马逊、谷歌、微软和甲骨文等公司已经计划在其云服务中提供NVL72机柜,尽管具体购买数量尚不清楚。

当然,Nvidia也愿意为公司提供其他解决方案,比如DGX GB200的DGX Superpod,它将八个系统合并为一个,总计有288个CPU、576个GPU、240TB的内存和11.5 exaflopsFP4计算。

Nvidia表示,其系统可以扩展到数以万计的GB200超级芯片,使用新的Quantum-X800 InfiniBand(可达144个连接)或Spectrum-X800以太网(可达64个连接)进行800Gbps网络互连。

暂无评论内容