一、NVIDIA A100 计算能力

A100在不同精度和计算模式下的峰值计算能力:

- FP64(双精度浮点运算):9.7 TFLOPS

- FP32(单精度浮点运算):19.5 TFLOPS

- TF32(Tensor Float 32,用于深度学习):156 TFLOPS

- FP16(半精度浮点运算):312 TFLOPS

- INT8(8位整数运算):624 TOPS (Tera Operations Per Second)

二、A100使用效率

因为训练过程中常常需要数据通信,占用不少时间,导致使用效率通常低于50%,技术报告中常见为40%左右。

三、使用20B Tokens,训练1B参数的模型的系统配置,训练时间

1.显存占用

1B参数,1(2Bytes 模型参数+2Bytes 梯度+4Bytes优化器一阶状态+4Bytes优化器二阶状态+4Bytes高精度参数)=1*16 = 16GB。

训练过程中,每批数据不同,需要占用的显存不同。batch_size<10时,可以和参数占用显存相同。

合计需要:16GB+16GB= 32GB

单张A100卡可以容纳模型。

2.训练时间计算

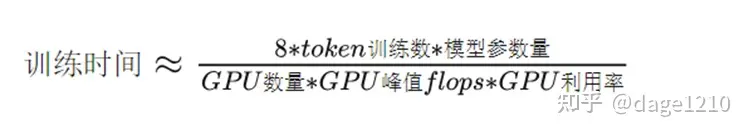

单张A100卡,则可以用公式初步计算训练时间:

图:粗略估计,可以是6-8倍

训练时间 = 8*20*1000,000,000*1*1000,000,000/1/312/1000,000,000,000/0.4/3600=356小时。

即,系数使用8,使用单张A100,20B Tokens,训练1B参数模型,大约需要356小时,或者15天。

四、使用40B Tokens,训练2B参数的模型的系统配置,训练时间

同上计算,单张卡可以容纳模型。使用单张卡预计需要4*15=60天。如果用4张卡,预计依然可以用15天左右完成。

五、使用300Btokens,训练175B参数模型,训练时间

单张卡无法加载175B模型,仅仅计算训练时间和配置。

1. 训练时间

训练时间=8*300*1000000000*175*1000000000/1/312/1000000000000/0.4/3600=934829小时

2.如果想30天训练完成,则需要配置:

934829/30/24=1298张 GPU卡。

3.更换参数

如果选择6作为系数,显卡使用率为46%, 同样计算,则需要609671小时;或者使用846张卡一个月完成训练。

© 版权声明

THE END

暂无评论内容