尽管扩散模型在文本到图像生成方面表现出非凡的能力,它们在生成高度美学的图像时仍可能遇到困难。具体来说,在更精细的维度上,如颜色、光照、构图等,生成的图像与现实世界中的美学图像之间仍然存在差距。因此,字节提出了交叉注意力值混合控制(VMix)适配器,这是一种即插即用的美学适配器,旨在提升生成图像的质量,同时保持对视觉概念的普遍适用性。

VMix通过以下方式实现:通过初始化美学嵌入,将输入的文本提示分解为内容描述和美学描述; 通过值混合交叉注意力将美学条件整合到去噪过程中,并通过零初始化线性层连接网络。核心是通过设计一个优越的条件控制方法来增强现有扩散模型的美学表现,同时保持图像与文本的一致性。VMix足够灵活,可以应用于社区模型以获得更好的视觉效果而无需重新训练。并且与其它社区模块(例如LoRA、ControlNet和IPAdapter)兼容,用于图像生成。

01 技术原理

—

VMix是一种新颖的即插即用适配器,旨在系统地弥合生成图像与现实世界对应物在各个美学维度上的美学质量差距,比如自然光线、协调的颜色和合理的构图。

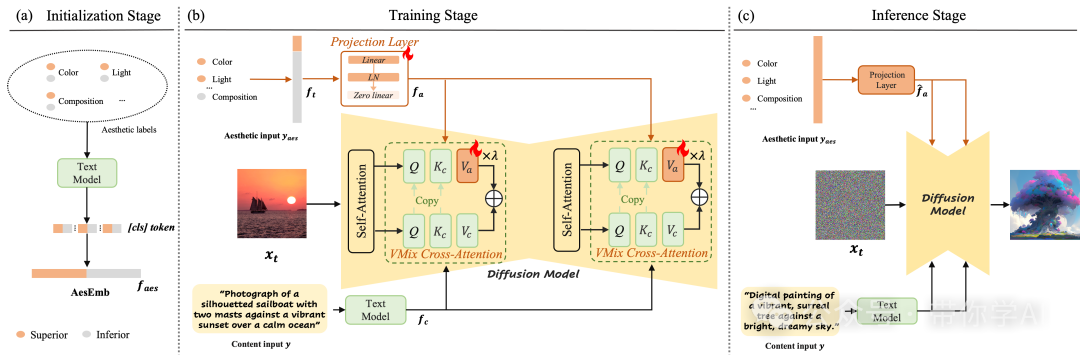

(a) 初始化阶段:预定义的美学标签通过 CLIP 转换为 [CLS] token,从而生成美学嵌入(AesEmb),这一过程只需在训练开始时执行一次。

(b) 训练阶段:首先通过投影层将输入的美学描述 映射为与内容文本嵌入 具有相同 token 维度的嵌入 。然后,文本嵌入 通过值混合的交叉注意力(value-mixed cross-attention)集成到去噪网络中。

(c) 推理阶段:VMix 从 AesEmb 中提取所有正向美学嵌入,形成美学输入,与内容输入一起输入模型进行去噪处理。

VMix 通过调整美学嵌入实现了细粒度的美学控制。使用单一维度的美学标签时,可以观察到图像质量在特定维度上得到提升。而在使用全正向美学标签时,生成图像的整体视觉效果优于基线方法。

02 演示效果与对比

—

使模型与人类期望对齐的关键因素之一是通过合适的条件控制方法使用解耦且细粒度的美学标签进行训练。受此启发,提出了一种有效的条件控制方法VMix ,大幅提升了模型的生成质量,提升美学表现。

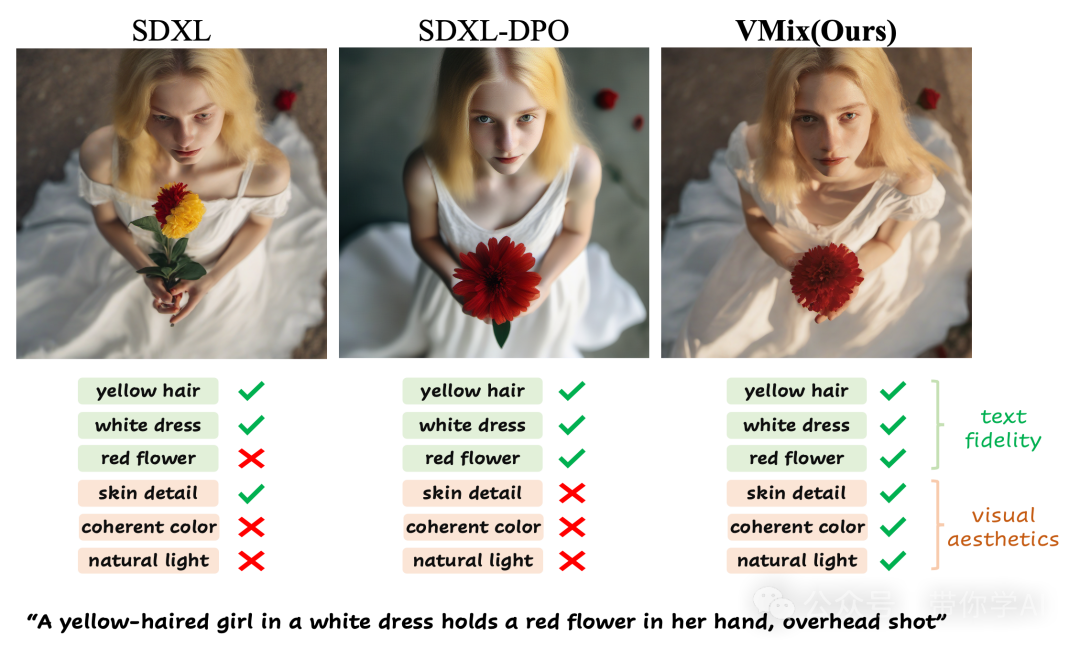

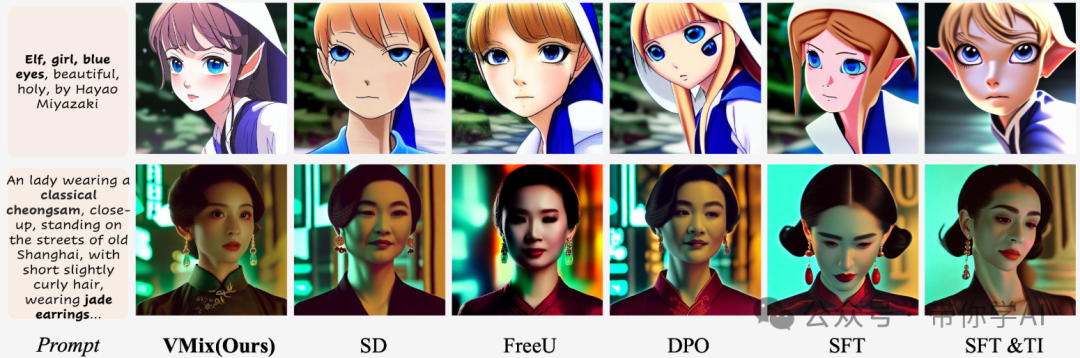

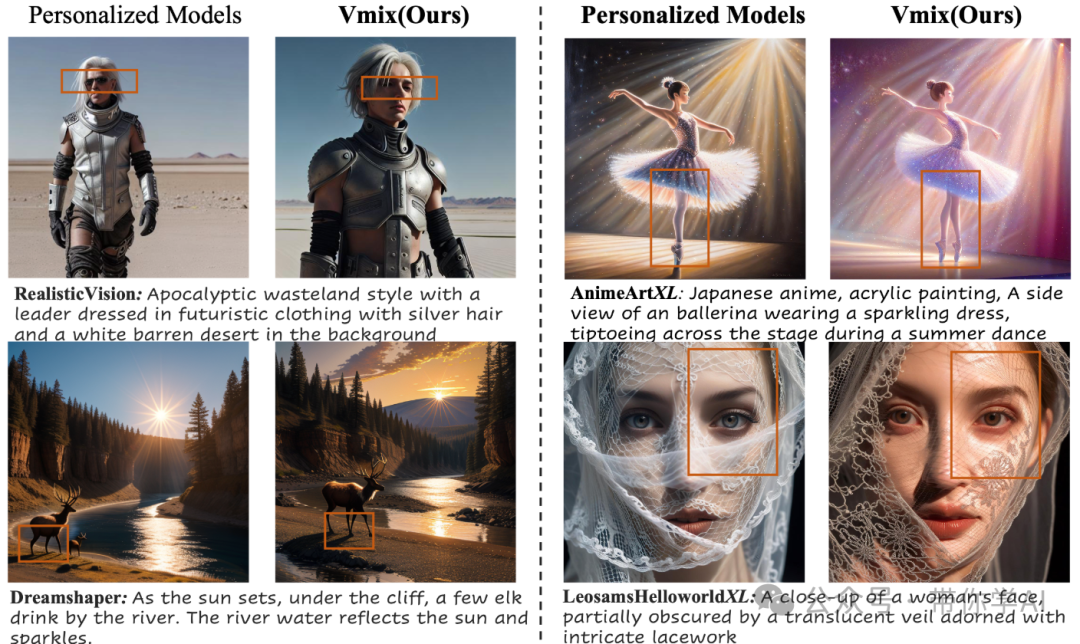

与各种最先进方法的定性比较,所有结果均基于稳定扩散。

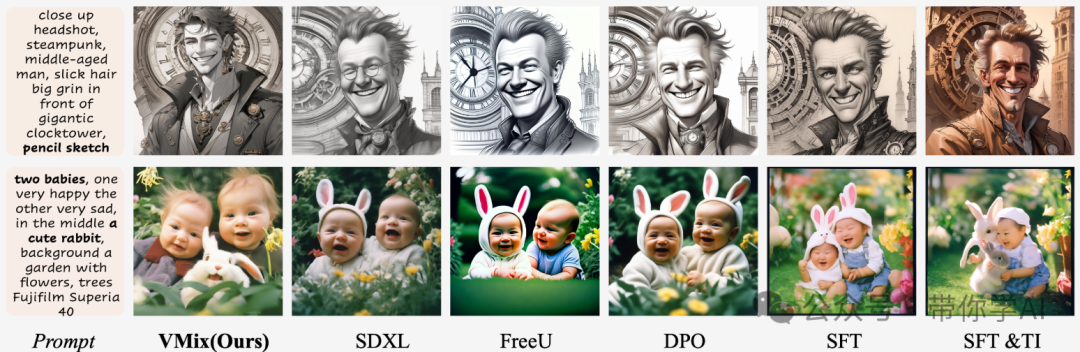

与各种最先进方法的定性比较,所有方法的结果均基于SDXL。

个性化文本到图像模型:使用或不使用 VMix 的个性化模型生成的图像。

暂无评论内容