在AI领域的浩瀚星空中,每一次技术的革新都如同璀璨星辰的闪耀,引领着智能的浪潮向前奔涌。近日,英伟达团队再次抛出了一枚震撼业界的重磅炸弹——归一化Transformer(nGPT),这一全新神经网络架构不仅将LLM(大型语言模型)的训练速度提升至前所未有的高度,更在保持原有精度的同时,为通向AGI(通用人工智能)的终极目标注入了一针强心剂。

重塑Transformer,加速AI未来Transformer架构,作为现代大模型的基础,早已在深度学习领域占据了举足轻重的地位。然而,其计算密集型的特性使得大模型的训练需要耗费大量的资源和时间,成为了制约AI发展的瓶颈之一。为了打破这一束缚,英伟达团队历经潜心研发,终于推出了nGPT这一革命性的架构。

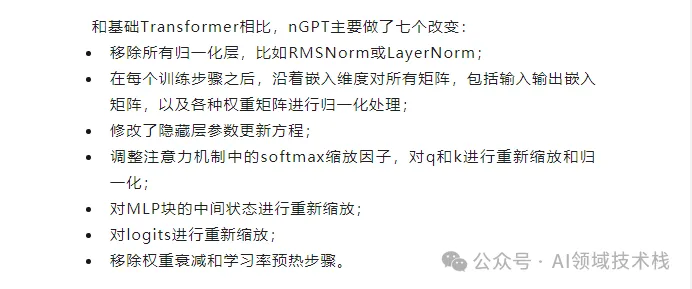

nGPT的核心在于归一化技术,它通过将所有的向量(嵌入、MLP、注意力矩阵、隐藏状态)归一化为单位范数,使得输入后的token在超球面表面上移动,每一层都通过“位移”来贡献最终的输出预测。这种创新的设计不仅简化了计算过程,更在超球面上实现了更高效、更稳定的表示学习。

实验数据表明,nGPT在达到相同精度所需的训练步骤上实现了显著的减少。在1k上下文长度下,训练速度提高了4倍;在4k上下文长度下,训练速度飙升了10倍;而在8k上下文长度下,更是惊人的达到了20倍的加速。这一结果无疑为AI训练效率的提升开辟了全新的道路。

超球面上的归一化探索归一化技术对于Transformer性能改善的重要性早已得到业界的广泛认可。从LayerNorm到RMSNorm,再到权重衰减等方法的不断尝试,科学家们一直在探索如何进一步提升Transformer的稳定性和效率。然而,nGPT的出现,却让我们看到了归一化技术的全新可能。

在nGPT中,归一化不仅仅是一种技术手段,更是一种全新的视角和思维方式。它将网络参数优化转化为在超球面上的可变度量优化问题,通过特征学习率等可学习参数来精确控制每一步的优化过程。这种设计不仅使得训练过程更加高效,更在保持精度的同时,大大提升了模型的泛化能力和鲁棒性。

从GPT到nGPT的蜕变标准的decoder-only Transformer通过预测输入序列的后序tokens来实现训练目标。然而,在相似性估计的准确性上却存在一定的局限性。nGPT针对这一问题进行了创新性的改进。它通过对输入和输出嵌入向量进行归一化处理,提高了相似性估计的准确性;同时,通过引入因果掩码等机制,确保了模型在预测过程中的信息不泄露,从而进一步提升了训练效率。

在参数更新方面,nGPT也展现出了独特的优势。它通过将参数更新过程描述为在超球面上寻找两点之间的最短路径问题,引入了球面线性插值等数学方法,使得参数更新过程更加简洁、高效。这种设计不仅降低了计算量,更在保持精度的同时,提升了模型的收敛速度。

实验验证:加速效果显著为了验证nGPT的性能优势,研究人员在OpenWebText数据集上进行了大量的实验。实验结果表明,在迭代次数和使用token数量方面,nGPT实现了显著的加速。在10亿参数且样本长度为4k token的情况下,nGPT经过2万次迭代后达到了与GPT在20万次迭代后相同的验证损失水平。这一结果充分证明了nGPT在训练效率上的卓越表现。

此外,研究人员还进一步分析了nGPT在不同上下文长度、参数规模等条件下的性能表现。实验数据表明,在1k、4k和8k token上下文中,训练0.5B和1B的nGPT模型分别约快4倍、10倍和20倍。这一结果不仅验证了nGPT的加速效果,更展示了其在处理长文本任务上的巨大潜力。

结语:AI的未来已来nGPT的推出标志着AI训练效率的新纪元已经到来。它不仅将LLM的训练速度提升至了前所未有的高度,更在保持精度的同时实现了显著的加速效果。这一革命性的进步不仅为AI研究注入了新的活力,更为推动AGI等前沿领域的发展奠定了坚实的基础。

在未来,我们有理由相信,随着nGPT等先进技术的不断迭代和完善,AI将在更多领域展现出其强大的应用价值和无限潜力。让我们共同期待AI的美好未来吧!

暂无评论内容