最近,二维虚拟试穿技术进展很快,但三维的虚拟试穿还没跟上节奏。虽然文本指导的三维场景编辑有一些突破,但要把二维的虚拟试穿放到这些系统里做出真实的三维效果依然很难。这是因为两大原因:一是文字没法提供足够详细的服装信息,二是二维图像从不同角度生成的效果通常不一致,导致看起来有点“乱”和变形。为了解决这些问题,南洋理工和上海AI实验室开发了一个基于图像提示的三维虚拟试穿方法,叫做GS-VTON。这个方法使用了一种叫做“三维高斯泼溅”的技术,能够把预训练的二维虚拟试穿模型知识带到三维中来,还能让不同角度的效果更加统一。GS-VTON可以有效地实现细粒度的虚拟试穿,在反映目标服装特征的同时保持原始身份。

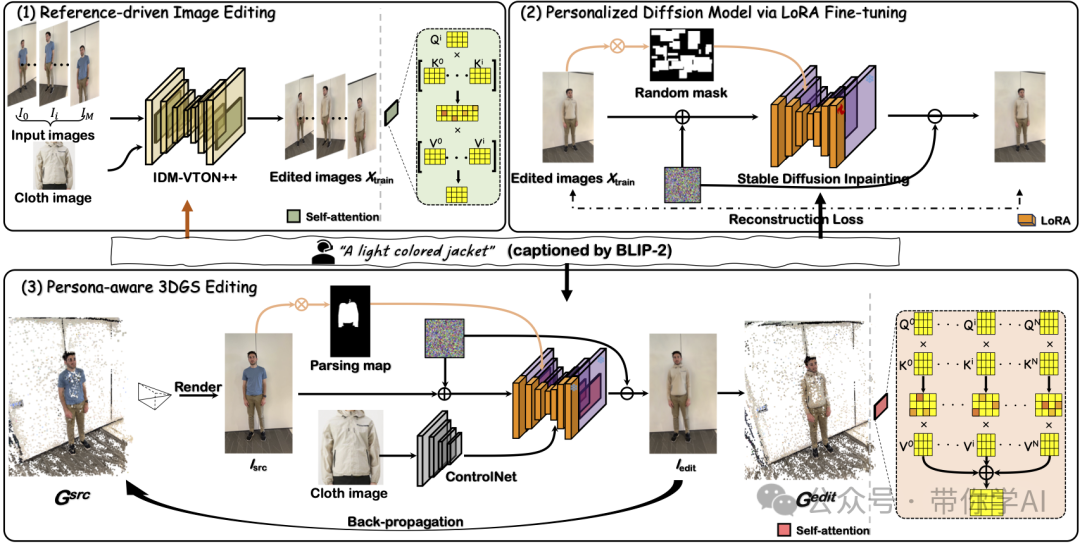

01 技术原理—GS-VTON把预训练好的二维扩散模型的知识应用到三维世界里,实现了三维虚拟试穿。具体来说:

- GS-VTON设计了一种参考图片驱动的编辑方法,可以让多个角度的编辑保持一致。

- 通过一种叫LoRA的技术,开发了一个个性化的图像修复模型,基于之前已经编辑好的图片来进行修改。

- GS-VTON系统的核心是一个能够识别人物特征的三维编辑框架,它利用个性化的扩散模型,通过两个注意力机制来工作:一个负责编辑,另一个负责确保从不同角度看都一致,这样就能让三维虚拟试穿在不同视角下保持统一。

现有的三维场景编辑方法通常依赖预训练的扩散模型来控制编辑过程并更新训练数据集,但在修改人体服装时常常遇到困难。主要原因是这些扩散模型无法准确感知和局部编辑服装。虽然扩散模型在二维虚拟试穿上已有进展,但直接应用于三维场景时,通常会导致不一致性和几何失真。

这是因为扩散模型的随机性,使其难以准确预测衣物在不同视角下的外观,导致各视角之间出现差异。为了解决这个问题,GS-VTON提出将从训练数据集中提取的空间一致性特征注入到扩散模型中。

02 对比与实际效果—

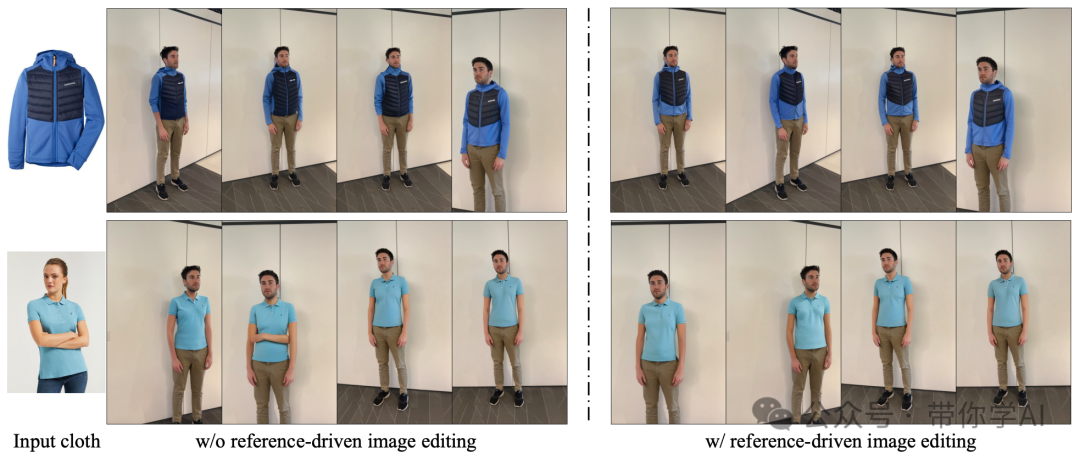

与基线方法的对比。首先进行定性评估,将GS-VTON方法与基线方法进行比较。具体来说,基线方法通过以下步骤实现三维虚拟试穿:(1) 使用 IDMVTON 单独生成编辑后的训练图像集 Xtrain;(2) 微调 LoRA 模块;(3) 使用微调后的模型编辑三维场景。

结果表明,基线方法在三维虚拟试穿的三个主要方面存在挑战:(1) 无法生成与输入服装图像高度相似的输出;(2) 难以在不同帧之间保持一致性;(3) 容易产生伪影和异常点。相比之下,GS-VTON方法能够有效生成与服装图像高度一致且稳定的结果。

暂无评论内容