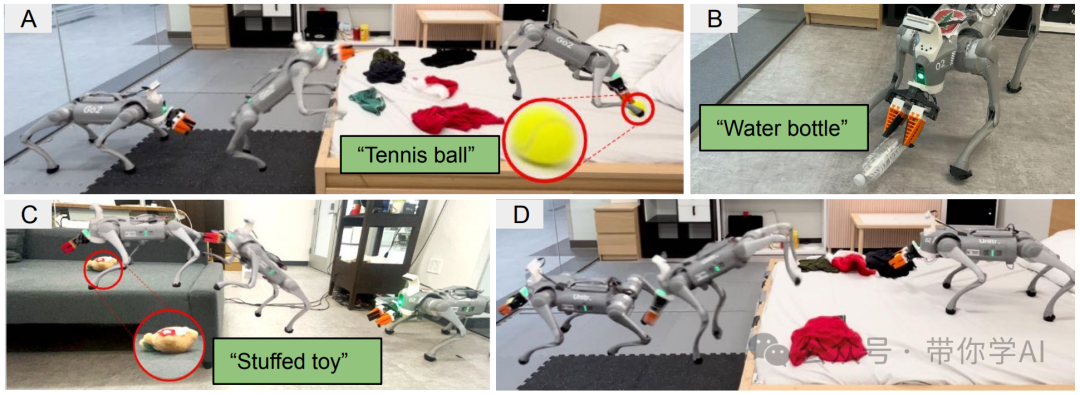

太震撼了!超远距离沉浸式主动视觉反馈开源操作系统Open-TeleVision该篇文章介绍的机械手作者团队近日发布了一个硬件和代码开源的腿式机器人Helpful DoggyBot。通过整合先进的计算机视觉技术和自然语言处理,这些机器人能够理解人类的指令,并在复杂的环境中寻找和抓取物体。借助视觉-语言模型(VLMs)和低级全身控制策略的协调指令,DoggyBot机器人能够执行以下任务:(A) 爬上床去取一个网球;(B) 低下身子捡起一个水瓶; (C) 爬上沙发拿起一个毛绒玩具; (D) 在取回网球后,从床上下来。通过这些能力,DoggyBot展现了在复杂环境中有效进行物品取回的灵活性和适应性。(链接在文章底部)  01 技术原理—

01 技术原理—

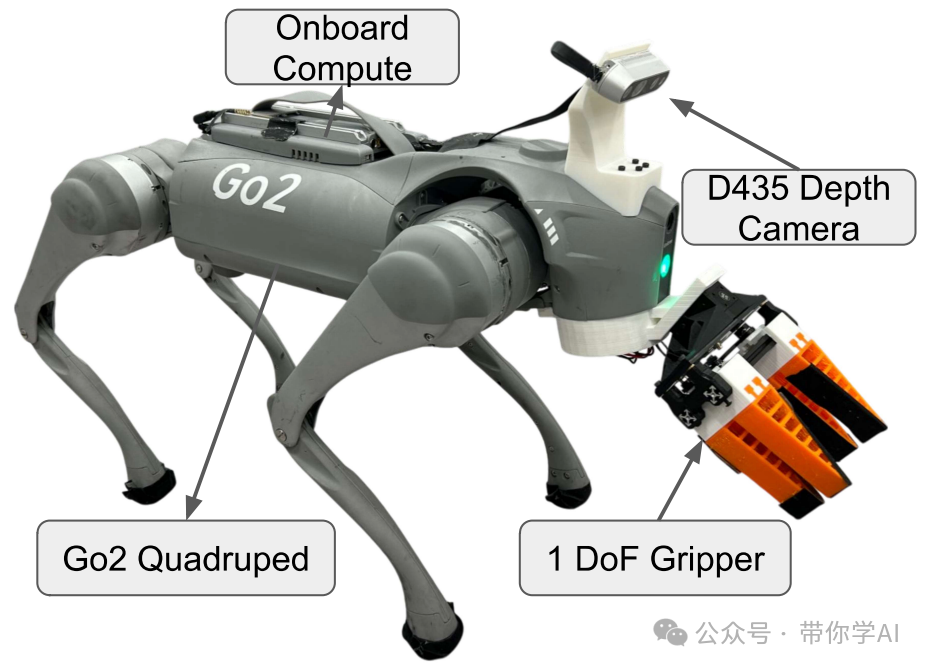

基于学习的方法在四足机器人运动中取得了显著的成果。然而,几个挑战阻碍了四足机器人学习在室内环境中与人和物体互动:缺乏操作的末端执行器、仅使用模拟数据的有限语义理解,以及室内环境中的低可通行性和可达性。虽然DoggyBot的方法展示了进展,但也存在一些局限性,包括抓手的灵活性受限、依赖天花板安装摄像头进行导航,以及感知系统可能受到遮挡。  DoggyBot提出了一个在室内环境中进行四足机器人移动操作的系统。该系统使用前置抓手进行物体操控,利用在模拟中训练的低级控制器来实现灵活的技能,比如攀爬和全身倾斜。此外,还结合了预训练的视觉-语言模型(VLMs),通过第三人称鱼眼视角和自视角RGB摄像头来进行语义理解和指令生成。

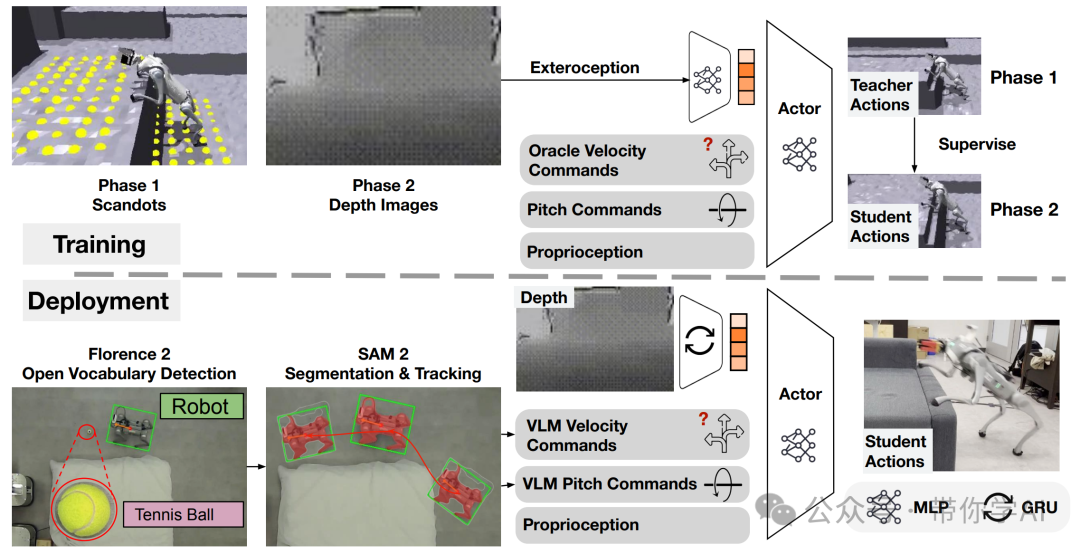

DoggyBot提出了一个在室内环境中进行四足机器人移动操作的系统。该系统使用前置抓手进行物体操控,利用在模拟中训练的低级控制器来实现灵活的技能,比如攀爬和全身倾斜。此外,还结合了预训练的视觉-语言模型(VLMs),通过第三人称鱼眼视角和自视角RGB摄像头来进行语义理解和指令生成。  DoggyBot采用了一个两阶段框架来训练基于深度的策略,作为低级全身控制器。在部署过程中,利用视觉-语言模型(VLMs)进行开放词汇检测、分割和跟踪,从而为控制器提供速度和俯仰命令。 这种设计使得DoggyBot系统能够灵活应对各种环境,并准确执行复杂的任务。02 实际效果—

DoggyBot采用了一个两阶段框架来训练基于深度的策略,作为低级全身控制器。在部署过程中,利用视觉-语言模型(VLMs)进行开放词汇检测、分割和跟踪,从而为控制器提供速度和俯仰命令。 这种设计使得DoggyBot系统能够灵活应对各种环境,并准确执行复杂的任务。02 实际效果—

床 + 玩具: 机器人需要在床上取回一个毛绒玩具。任务要求机器人爬上一个高 40 厘米的皇后尺寸床,捡起床上的毛绒玩具,然后再爬下床。毛绒玩具被均匀随机放置在床上一个 1 米 x 1 米的区域内。机器人最初随机放置在卧室中

沙发 + 瓶子: 机器人需要在沙发上取回一个空的塑料水瓶。任务要求机器人爬上一个高 44 厘米的沙发,捡起沙发上的瓶子,然后再爬下沙发。水瓶被均匀随机放置在沙发上一个 0.2 米 x 1 米的区域内。机器人最初随机放置在房间中。

通过这些任务,机器人展示了在不同高度和环境中的物体获取能力。

暂无评论内容