谷歌 DeepMind 首席科学家 Denny Zhou ,最近在 社交媒体上语出惊人:LLM 的推理能力没有极限!只要给它足够的时间“思考”,它就能解决任何问题!🤯 此话一出,立刻在 AI 圈炸开了锅,连 Meta AI 的大佬 Yuandong Tian(田渊栋) 都下场“开怼”

究竟发生了什么?

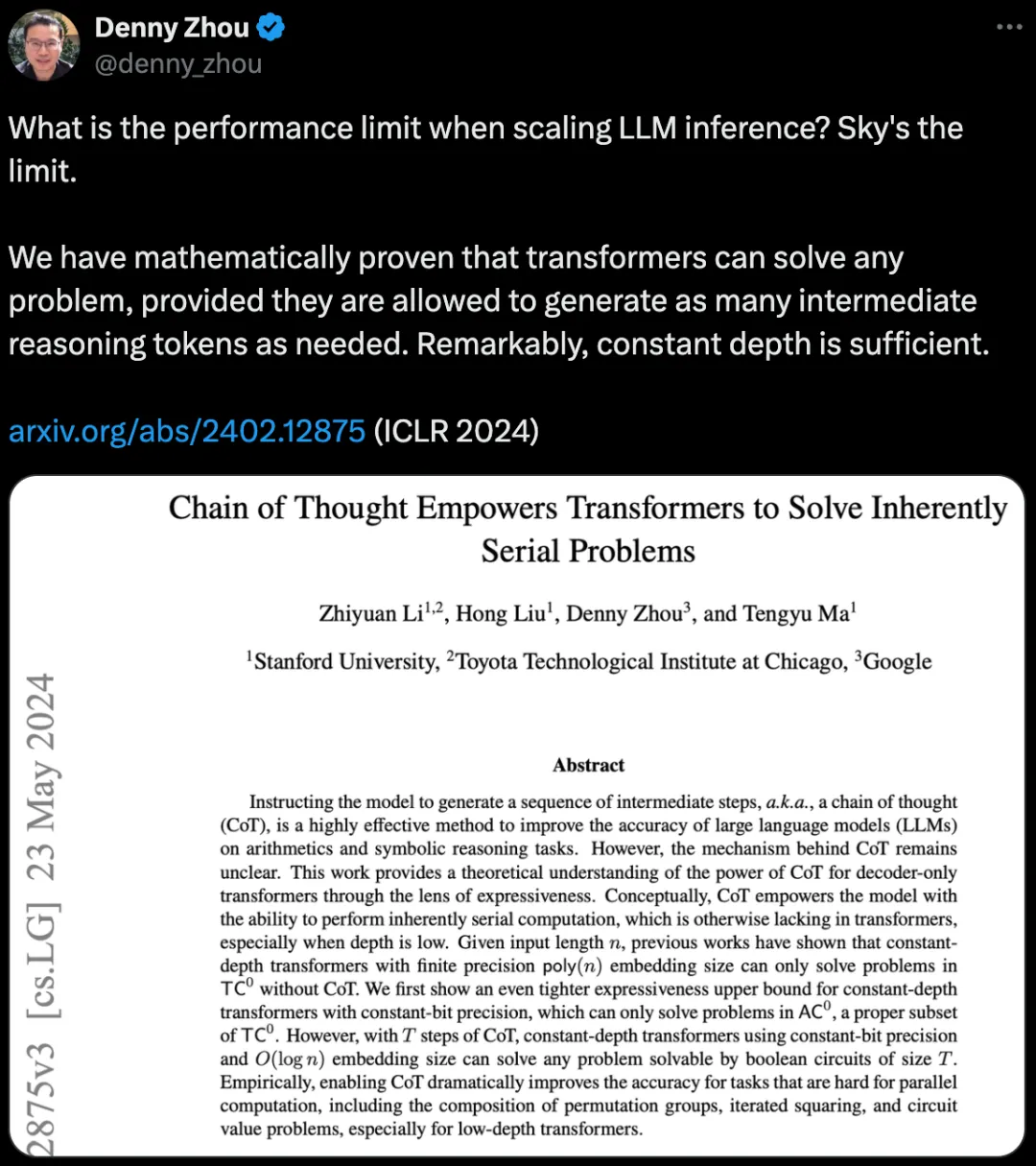

原来,Denny Zhou 是 Chain of Thought Empowers Transformers to Solve Inherently Serial Problems 这篇论文的主要作者之一。这篇论文发表在 ICLR 2024 上,核心思想是利用 CoT (Chain of Thought,思维链) 技术让 LLM 模拟人类的思考过程,通过生成一系列中间推理步骤,来解决那些需要逻辑推理的复杂问题。

论文详情可以看我之前写的这篇文章

Denny Zhou 的发言是在OpenAI推出o1模型后,其实就是对这篇论文核心观点的“广告”:

“扩展 LLM 推理能力的性能极限是什么?天空才是极限。我们已经用数学方法证明了 Transformer 可以解决任何问题,只要允许它们根据需要生成任意数量的中间推理 token。值得注意的是,恒定深度就足够了。”

简单来说,就是 “只要 CoT 够长,Transformer 就能解决任何问题!”

Meta AI 的 Yuandong Tian 大神看到这条 “广告” 后,坐不住了,直接“开怼”:

“虽然 CoT 非常有用,但我不敢苟同盲目地扩大规模就能满足我们所有需求的观点。这篇论文提出了一个通用逼近定理,它通过显式地构建 Transformer 权重来适应任务族。虽然深度可以是常数,但 CoT 的长度可以超长,而且我们不知道这样的权重配置是否可以通过梯度下降来学习。这就像‘既然我们知道 2 层 MLP 可以拟合任何数据,我们就相信它并将其应用到所有地方’。人类的推理链非常简洁,即使对于从未见过的问题也能抓住关键因素。这种表示是如何在运行中学习(或构建?)的,这是一个令人着迷的问题。”

田渊栋一针见血地指出了 Denny Zhou 论文和观点中的 “漏洞”:

理论和实践的差距: 你论文里说 CoT 长度可以无限长,但现实中,模型训练是有成本的,谁有那么多资源去训练一个超长 CoT 的模型?

CoT 长度过长,模型训练难度大: CoT 越长,模型越难学习,这就像 2 层 MLP 虽然理论上可以拟合任何数据,但实际上需要指数级的 neurons 才能做到,根本不现实!

人类的推理链简洁高效,AI 难以模仿: 你光顾着增加 CoT 的长度,却忽略了 AI 推理的效率问题!人类的推理链非常简洁,能够抓住问题的关键因素,即使面对新问题也能快速找到解决方案。AI 要想像人类一样进行推理,还有很长的路要走!

眼看 Yuandong Tian 来势汹汹,同为论文作者的 Stanford 大学 Tengyu Ma(马腾宇) 教授赶紧出来“救火” :

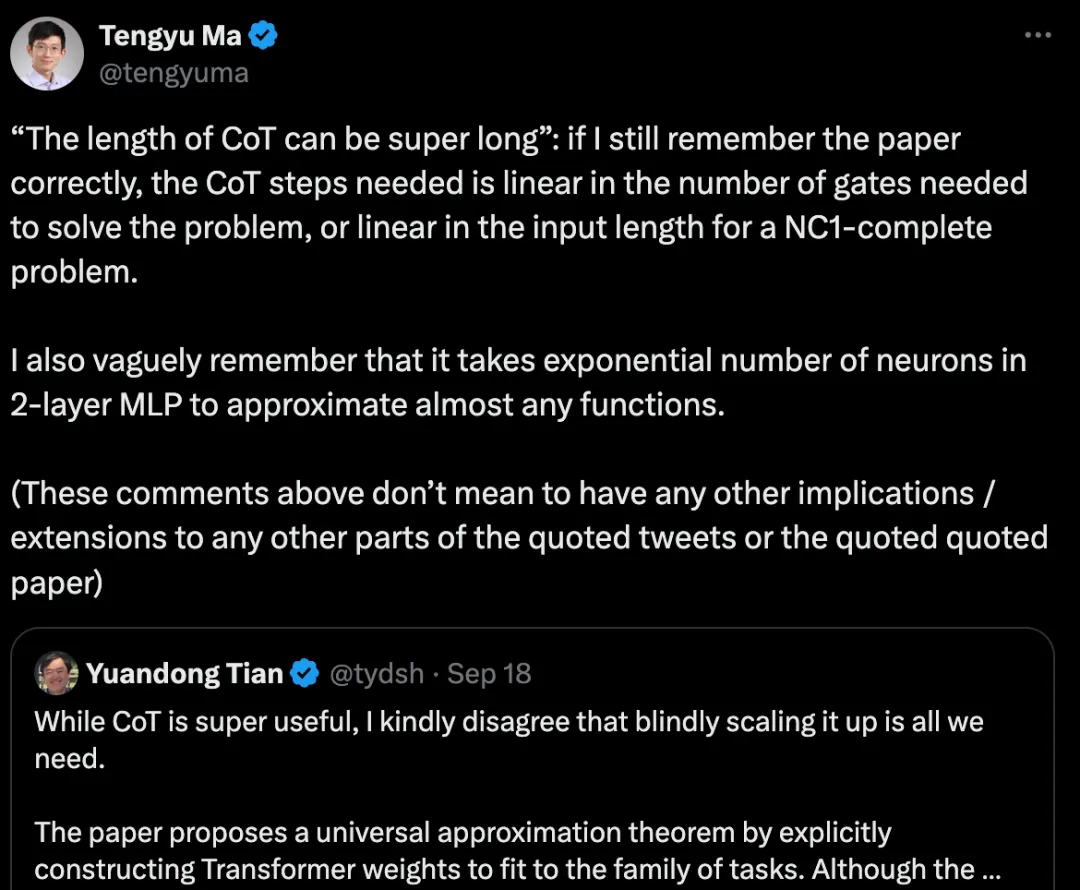

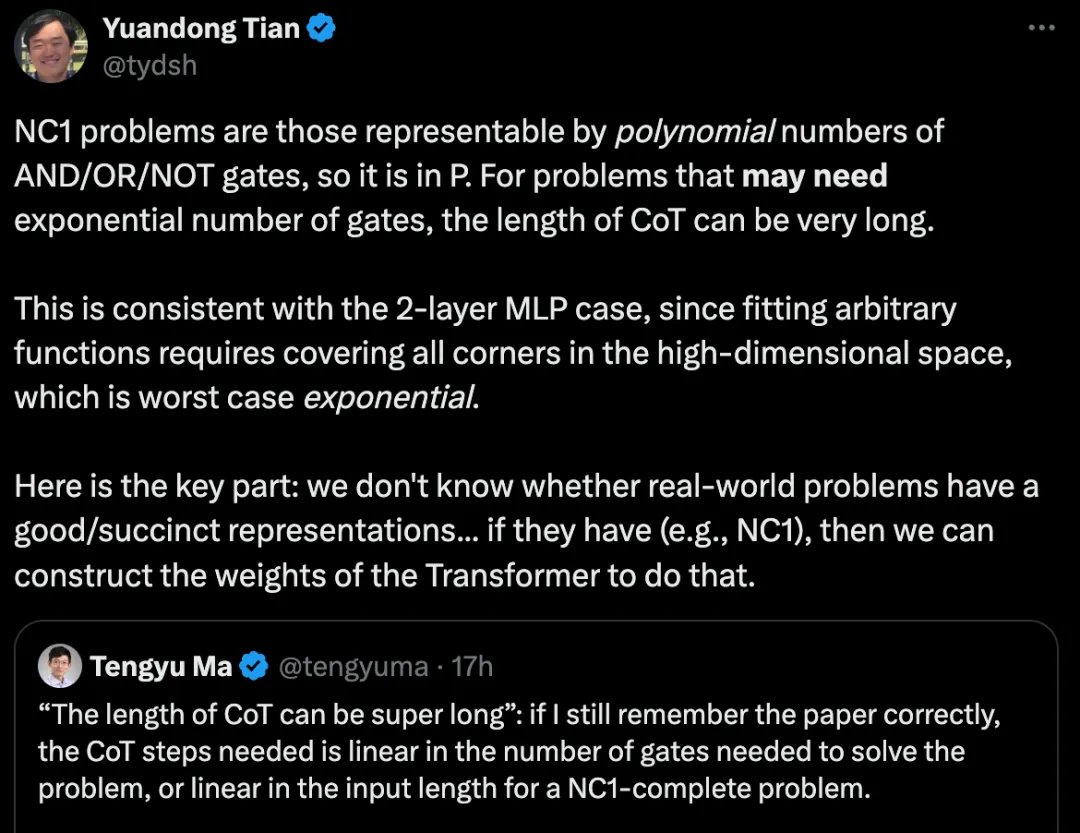

“‘CoT 的长度可以超长’:如果我还没记错的话,所需的 CoT 步骤与解决问题所需的门的数量呈线性关系,或者对于 NC1 完全问题来说,与输入长度呈线性关系。我还隐约记得,用 2 层 MLP 逼近几乎所有函数都需要指数级的 neurons。(以上评论并不意味着对引用的推文或引用的引用的论文的任何其他部分有任何其他暗示/扩展)”

马腾宇教授试图用更严谨的理论解释来“打圆场”:

CoT 长度的解释: 我们的论文并不是说 CoT 长度可以无限长,而是说对于某些类型的问题,例如 NC1 问题,所需的 CoT 步骤是可控的

与神经网络类比: 2 层 MLP 逼近任意函数需要指数级 neurons 的例子,只是为了说明理论上的能力和实际应用之间可能存在很大差距,并不是说 CoT 就不可行。

田渊栋显然不买账,继续追问:

“NC1 问题是那些可以用多项式数量的 AND/OR/NOT 门表示的问题,所以它属于 P 类。对于可能需要指数级数量的门的问题,CoT 的长度可能非常长。这与 2 层 MLP 的情况一致,因为拟合任意函数需要覆盖高维空间中的所有角落,这在最坏情况下是指数级的。关键是:我们不知道现实世界的问题是否有好的/简洁的表示…… 如果有(例如,NC1),那么我们可以构建 Transformer 的权重来做到这一点。”

田渊栋的意思是,现实世界的问题往往比 NC1 问题更复杂,所需的 CoT 长度可能会超出想象。 除非我们能找到一种简洁高效的表示方法来描述现实世界的问题,否则 CoT 技术很难在实际应用中发挥作用。

随后,Yuandong Tian 与其他几位专家就 CoT 技术的未来发展进行了一番讨论,主要观点如下:

Tijmen Blankevoort 认为,应该限制 CoT 的长度, 迫使 AI 进行更强的抽象,就像人类一样,因为人类的“愚蠢”反而让我们更擅长抽象思维

Yuandong Tian 则透露了他们正在研究的 Searchformer 模型, 该模型的目标是在保持最佳最终结果的同时,找到更短的 CoT,并认为 OpenAI 的 o1 模型可能也采用了类似的方法

Zeming Lin 希望建立一个类似于乔姆斯基层次结构的机器学习模型分类体系, 以便更好地理解不同模型的计算能力

Dickson Pau 则不认同田渊栋的看法,大家勇于尝试, 不要因为理论上的限制就放弃探索

这一切都发生在OpenAI o1推出后,按照Sam Altman的说法o1目前还只是预览版,o1在几个月之类就会得到非常大的进化,CoT 究竟行不行,我们很快就会看到结果,o1究竟是不是AGI的关键一步,我们拭目以待!

暂无评论内容