近日,HuggingFace在AI驱动的视频分析和理解方面取得了重大进展——发布了公开数据集FineVideo。FineVideo是一个专注于多模态学习大型多功能数据集,涵盖了超过43,000个精心挑选的YouTube视频,并且所有视频遵循知识共享署名(CC-BY)许可。对于致力于推动视频理解、情绪分析以及多媒体叙事模型发展的研究人员、开发者以及AI爱好者而言,FineVideo无疑是一个宝贵的资源。

1. 设计初衷

FineVideo被设计用于应对如场景分割、物体识别和音频与视觉情感关联等复杂的视频任务。这个数据集不仅涵盖了视频的技术特性,如分辨率和帧率,还包含了上下文信息,如角色互动、场景演变和视听同步。这种高质量的视频数据,将成为从预训练大模型到针对特定视频处理任务进行微调的各种应用场景的理想选择。

2. 数据集组成

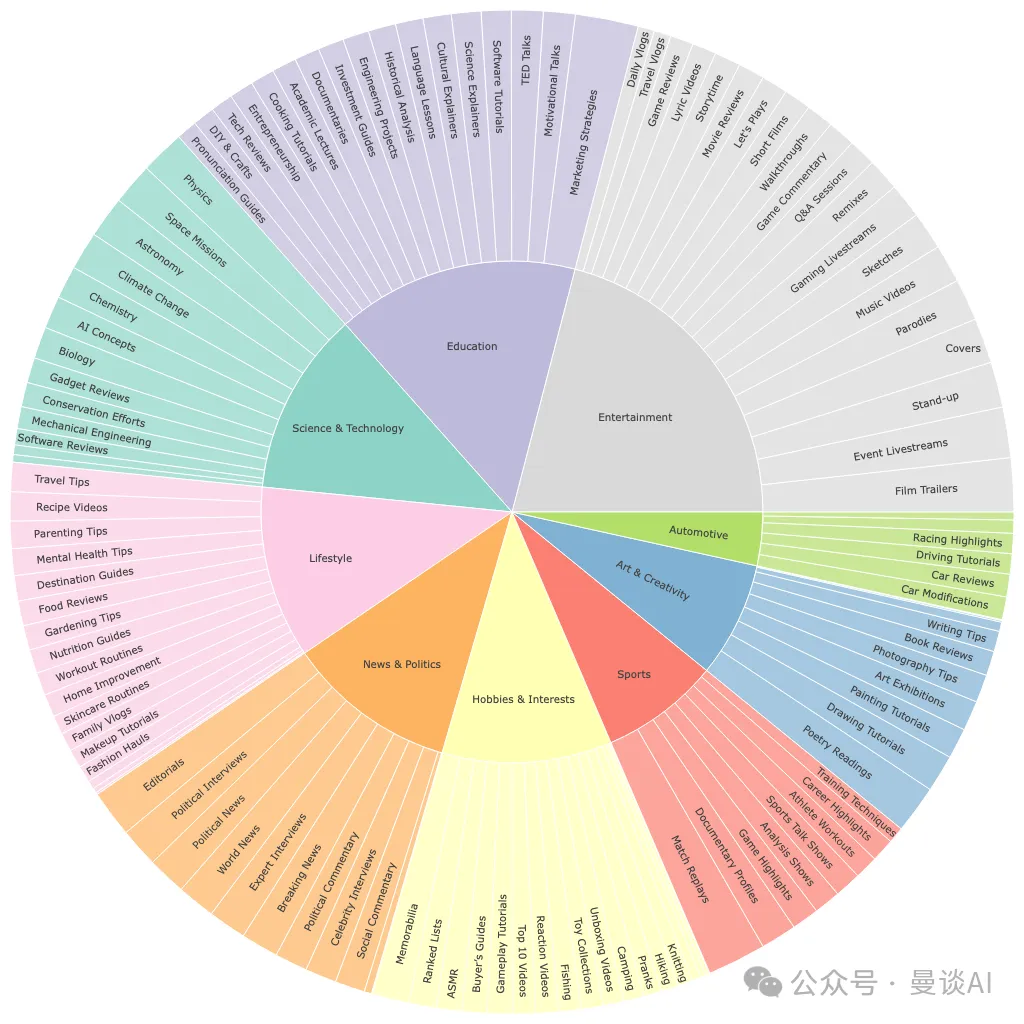

FineVideo是一个非常全面的视频数据集,它收录了超过43,751个视频,总时长达约3,425小时。视频平均长度为4.7分钟,覆盖了122个不同的类别,为多个研究领域提供了丰富多样的内容。每个视频都配备了详尽的元数据,包括标题信息、语音到文本的转录以及精确到时间码的注释,这些注释详细描述了视频中的关键活动、物体的出现以及情绪的波动。

与传统的视频数据集相比,FineVideo特别强调情感叙事和叙事流程。它通过强调场景和活动之间的上下文联系,使得数据集能够支持更深层次的多模态学习。FineVideo的设计帮助研究人员开发出能够更细致地理解视频内容的AI模型,这些模型不仅仅局限于基础的物体检测或语音识别,而是能够捕捉并解读视频的深层含义。

3. 用例和场景

FineVideo的应用前景非常广泛,研究人员和开发者能够运用这一数据集来执行视频摘要、情绪预测和叙事分析等任务。具体来说,FineVideo所提供的详尽元数据可以帮助构建理解视频故事线发展的AI模型,它能够捕捉到视频中的关键时刻,例如情感高潮或情节的转折点。这种能力在媒体编辑等领域尤其宝贵,编辑们可以借此理解镜头中的情感走向,从而创作出更加引人入胜的视觉故事。

此外,FineVideo也能够被应用于基于视频的问答系统。以描述重型设备操作员培训课程的视频为例,它可能会涉及到与视频中特定活动相关的问题,如“正在操作的是什么设备?”或“培训过程中操作员的情绪变化如何?”FineVideo中包含的丰富元数据,有助于开发出能够以高度上下文感知精确度回答这些问题的AI模型。这种能力不仅能够提升信息检索的效率,还能够增强用户与视频内容互动的深度。

4. 如何访问

FineVideo托管在Hugging Face平台上,使广大开发者可以轻松访问。研究人员可以使用FineVideo Space探索数据集,这是一个允许直接浏览视频及其相关元数据的交互式环境。数据集可供下载,总计约600 GB的数据(见文末链接)。

5. 未来的方向

HuggingFace计划在未来对FineVideo进行扩展,包括增加更多带注释的视频以及进一步完善数据集的元数据。此外,团队还打算公开用于构建FineVideo的数据管道代码,这不仅增强了透明度,也鼓励了社区参与驱动数据集的持续改进。随着视频内容在在线平台的主导地位日益增强,Hugging Face的FineVideo正逐渐成为开发更复杂、更具上下文感知能力的AI模型的关键基础资源。

总体而言,Hugging Face向公众开放FineVideo这一数据集,不仅为多模态学习的知识体系做出了重要贡献,还推动了在AI开发中对视频数据的负责任地使用,值得我们学习。

暂无评论内容