本期内容是「全球大模型季报」的第四集,拾象科技 CEO 李广密和商业作者张小珺围绕 AGI 发展路径展开了猜想,self-play RL 是新的 scaling law。

这期讨论录制于 2 周前,随着昨天凌晨 OpenAI o1 模型的发布,我们的猜想得到验证,LLM 正式进入 self-play RL 范式时代。

OpenAI 不是唯一重视 RL 和 Self-Play 的公司,在 o1 之前,Anthropic Claude 3.5 Sonnet 就被视为一个标志性里程碑,Claude 3.5 Sonnet 代码能力显著提升的背后其实是 RL 在起作用;Google 也已经围绕 LLM 做 reward model 展开了多个项目的研究;前 OpenAI 的核心人物 Ilya 创立的新项目 SSI 也和 RL 相关。o1 的发布势必会加速新范式共识的形成,将 RL 从头部 AI Labs 的尝试向全行业扩散。

o1 只是 AGI 下半场的开始,接下来 Anthropic Claude 3.5 系列新模型的发布也同样值得期待,Claude 3.5 和 o1 的表现会是 RL 进程是否顺利的风向标。

作为关注 AI 最前沿的团队,我们围绕 self-play RL 也已经发布了多篇研究。本次讨论是我们给行业关于 self-play RL 的一篇高质量科普。关于 RL 和合成数据会如何帮助模型升级?基于 LLM 的 RL 和 self play 和以前的 RL 有什么不同?模型的 Reasoning 能力提升后会带来什么新机会?等等关键问题都可以找到最全面的答案。

E5 LLM 新范式:OpenAI o1,self-play RL 和 AGI 下半场

01 Self-play RL 开启 AI 下半场02 RL 是新的 scaling law 03 代码、视频生成、机器人04 What’s Next?

01.

Self-play RL 开启 AGI 下半场

张小珺:最近这两个月你思考最多的问题是什么?

Guangmi Li:语言模型预训练的范式已经到瓶颈了,模型 scaling 的边际效益开始递减。接下来的路线怎么走、这一轮技术革命是否就此卡住?这些问题会很关键。

张小珺:目前对这个问题有得出什么结论吗?

Guangmi Li:有 50%的概率,传统意义上的 scaling law 已经失效了。另外 50% 的概率,沿着老的路线,大家继续搭建 10 万卡大集群,能够继续走向 AGI 。现在各种证据还不够多,还不能妄下结论,也不能下判断证明预训练这条路径已经到头了。但大家目前观察到,纯靠加参数、数据、算力的路径已经不容易了,model size 向上 scale 也有一些问题。

从参数上看,现在最好的模型是 600-700B 总参数的 MOE 模型,这也是单台 H100 server 可以放得下的参数量。今天,我们还没有看到向上再 scale 3-5 倍、达到 2-3T 总参数的模型。换言之,即使可以做出 2-3T 总参数的模型,短期收益上效果也没有那么好。如何向上做 scaling 的规律目前大家也没有探索清楚。

从数据上看,很多公司现在都可以达到 15-20T 高质量文本数据量,每个月也可以再增加约 2T 的新数据。但很难倍数级增加数据至 50-100T ,还是需要新的方法突破数据瓶颈。

算力角度,英伟达的 H100 现在可以做到 3.2 万张卡、充分互联的单一集群,全球有 3-5 家公司都可以做到这一规模了。但在 B 系列 GPU 被规模化采用前,算力基本上不会有倍数级别提升。

这几个基础条件不一定可以支持在 GPT-4o ,或是 Claude-3.5 这一基础上进一步做大幅提升。如果继续延续这一路径,结果可能会比 GPT-4o 好一些,但不一定能像 GPT-3 走向 GPT-4 那样有显著跨越的提升。

张小珺:不能支持模型在 GPT-4o 的基础上大幅跃升的原因是什么?

Guangmi Li:存在几种情况:

第一,今天的模型 scale up 幅度依然不够,未来 B 系列卡的出现可能可以解决这一问题,现在处在一个真空的死亡地带,说明 H100 这一代卡可能没有那么好。

第二,也需要考虑执行问题。训练更大的模型比较复杂,就像是发射一个重型火箭,或者类似于芯片流片的过程,涉及到的因素是很综合的。比如,MOE 规模很大了之后,很难进一步调整。MOE 模型需要怎么摆放?训练 2-3 万亿参数的 MOE 本身就很难,现在业界主流基本在 600-700B 左右。

其次数据问题也很重要。团队如何才能获得那么多高质量、真正可以提升模型能力的文本数据?能不能真正用好合成数据?这都是重要的问题。

合成数据至今并没有根本性突破。大家都还是在用模型去改写、扩充,把低质量数据变为高质量数据。而数据重复其实并不能对模型有大幅度提升。获得更多高质量的逻辑推理数据的能力是更重要的。

前面两个问题都是短期问题,随着时间慢慢可以解决。第三种情况才是最担心的一种情况:纯靠语言的经典 scaling law 做 pre-train 的这个物理规律是不是就遇到瓶颈了?或者在更大参数,比如 2-3T 参数以上, scaling law 是否会失效?那我们就需要新的方法,才可以带来更大的突破。第三种情况在 B100 GPU 推出前,发生的概率非常大。

张小珺:今年 Q1 的时候,你观察到 GPU 数据中心和物理硬件是瓶颈,现在似乎瓶颈变得更多维度了,不只是物理硬件这一个原因了?

Guangmi Li: GPU 数据中心与物理硬件依然是瓶颈,但这个瓶颈无法短期突破。H100 这一代 GPU ,充分互联可以做到 3.2 万卡。H100 这一代卡用起来不算很好,每美元购买量还是很贵。因此,还是需要等 B 系列推出后,参数才能 scale up 。在此之前,我们还是需要在有限的集群下做新的 scaling law 范式的探索。

还有另外 50% 的概率会留给 Elon Musk 的 xAI 。Elon Musk 认为:算力决定生死。xAI 就下注在 10 万卡集群上,这也是第一性原理。也存在很大概率,Elon Musk 搭建了 10 万卡集群后、训练出更好的模型。但算力增加到 10 万张卡,短期挑战很大。目前, 3 万卡的集群,每 2 小时会出错一次,而 10 万卡集群基本上 20-30 分钟就会出错一次,综合利用率会下降非常多。这个现象对数据中心的运维挑战是很大的,运维团队需要快速定位损坏的卡、快速插拔更换后上线。

模型 scale 到 2-3T 后, MOE 就更复杂了。有一个原因是因为对 MOE 的实验还不够充分,其中的 bug 也很多。还会有一个说法是,和 MOE 相比,做 dense model 更容易。但 dense mode 也有一个缺点:训练过程中 GPU 利用率不够高。

包括刚刚提到的数据问题,合成数据并没有突破。因此,这是一个综合问题,并非单一因素。算力的问题存在, MOE 复杂架构的问题也存在,数据的问题也存在。大家还不知道如何利用视频数据,未来可能会有新的架构出现。

张小珺:如果 scaling law 在模型变大的过程之中失效了,那你们有看到什么新方法、新的路线来替代 scaling law 吗?

Guangmi Li:有 2-3 条潜在的路线,每个公司也都有自己下注的路线。

第一种路线是多模态,尤其是视觉。很多人会认为多模态的确定性很高,只靠语言无法走向 AGI ,需要语言结合视觉这种多种模态。但其实用大量视觉数据做大规模训练这个方向上,今天还没有任何证据可以证明可以从视觉模态训练内涌现出智能或逻辑能力。Tesla 的 FSD 很难定义算多模态还是单一模态。

其实 AI 最重要的还是通用泛化性,就像 AlphaGo 下棋:下围棋可以成为世界第一,但 AlphaGo 无法做其它任务。特斯拉 FSD ,或者今天所谓的通用机器人公司,目前在某一个特定设置上采集数据并训练模型,换到另一个新设备上是起不到作用的,这是不具备泛化能力的。多模态模型的技术路线还是没有像语言一样那么统一。也许未来会诞生一个全新的架构,但这又涉及到基础科学的突破了。我们无法确定几年后才可以看到这种基础科学的突破。

视频生成目前走的是 DiT 路线,这是因为年初 Sora 给整个行业指明了这一路线。短期来看, DiT 向上的收益是可观的。可以确定的是,多模态可以带来交互能力的提升。交互能力提升后, reasoning 逻辑推理能力也会提升。

第二种路线是 10 万卡集群的路线,就像刚刚讨论的,短期不成功可能还是归因于算力不够,还处在中间的死亡地带。这种情况下,总有人要试试更大的集群。如果,更大的集群搭建成功后训练出了能力更强的模型,那就会让没有尝试这一路线的人傻眼。但客观来讲,十万卡集群充分互联的难度比预期会更难。甚至可能十万卡集群是全人类目前遇到过最难的项目,比 SpaceX 发射重型火箭更复杂。

多模态和 10 万卡集群这两条路线都是确定会发生的路线,只是时间问题。但这两条路线并不够本质,换言之,这并不能被称为范式级别。能够称之为范式级别的路线只有一个,强化学习(reinforcement learning,RL)。

目前整个业界,无论硅谷,还是中文媒体,其实提及强化学习这一路线都还很少,换言之大家今天还不知道如何做。今天的强化学习是 self-play 强化学习,这条路线是最合理、天花板最高的。Anthropic 的 Claude-Sonnet ,从 3 迭代至 3.5 后,我们能看到它的代码和数学能力提升很大,就是强化学习带来的。

用 self-play 的方法提升模型的逻辑推理能力是接下来最重要的范式,也是一个最核心的变化。

多模态、 10 万卡集群、强化学习这三条路线并不矛盾,可以并行。但公司如果资源有限,就需要下注在最相信的一条路径上。假如我是一个 AI 公司的 CEO ,我肯定会用 200%的资源押注于强化学习这一路线。这是目前最有机会走向 AGI 的路线。

张小珺: 9 月份 Anthropic 和 OpenAI 应该都会有新的模型发布,你对于这两个模型有什么值得期待的吗?

Guangmi Li:Claude-3.5-Opus 的进步幅度会很大,因为 Sonnet 版本从 3 到 3.5 进步幅度就很大。

目前还不知道 OpenAI 会发布什么进展,但草莓已经造势很久了,我感觉也应该还是在强化学习这条路线下。代码和数学能力肯定是大幅度提升的,而提升幅度不会亚于 Claude-3-Sonnet 到 Claude-3.5-Sonnet 的幅度。OpenAI 会不会发布新的模型还不好说。

02.

RL 是新的 scaling law

张小珺:能不能展开解释下什么是强化学习?

Guangmi Li:2018 年的时候 Lex Fridman 邀请 Ilya Sutskever 去 MIT 客座讲了一节课, Ilya 选的主题就是强化学习与 self-play ,他当时就认为,这是通往 AGI 路上最关键的方法之一。Ilya 用一句话概括了强化学习,非常准确:让 AI 用随机的路径尝试新的任务,如果效果超预期,那就更新神经网络的权重,使得 AI 记住多使用这个成功的事件,再开始下一次的尝试。

我们在实现强化学习的过程中,有两个元素是最重要的,一直在反复交互。

第一个是环境 (environment),也就是 AI 探索完成任务的环境。比如下棋时的环境就是 19*19 的棋盘。主人训练家里的狗,环境就是狗主人的家和小区。环境是会发生变化的,发生变化时, AI 会从环境变化中收到 reward value ,从而判断过去的几步探索是否有明显收益。比如,判断距离下棋胜利是否更接近,这是一个奖励机制。奖励机制是强化学习之中最重要的要素。

第二个是 agent, 智能体。我们今天聊的很多的 AI Agent 的概念其实是来源于强化学习的定义。agent 对环境观测和感知后,会输出动作。Agent 最重要的目标是得到奖励。

有几个基础概念可以科普:回到刚刚聊到的主人训练狗的比喻上,我们训练的狗,是一个 agent(智能体),负责学习与决策。环境即为狗主人的家和小区。狗有动作,比如坐下、握手这些行为。狗也有状态,比如它所处的位置。此外,人对狗有奖励机制,可以给狗一些吃的零食,或者责骂它,这些是正面信号和负面信号。

LLM 即可以看作一个智能体。ChatGPT 就是一个文本或对话场景的智能体。它可以输出不同的文本、各种 action 、甚至各种模态,也具有奖励。只不过今天文本的奖励噪音比较多,我们不好定义奖励模型,这是目前还不清楚的问题。即便有上亿人在使用 ChatGPT ,但其实用户给 ChatGPT 的反馈是没那么有效的。因为目前点“赞”和点“踩”这个功能制造的噪音也会比较多。

张小珺:有什么具体的例子可以来具体解释强化学习?

Guangmi Li:有一个比较好的例子:两支队伍同时去一个深山探矿寻宝,其中一个人有藏宝图,我们这边没有藏宝图,但我们投入了 5000 个特种兵和专业的探测设备。有人会说我为了寻宝在资源浪费。但只要确认这里有宝藏,我可以几乎百分之百探测出它,甚至比看藏宝图的人速度更快。因为我可以利用这些人和设备把各个地方、各种路线都探索一遍。但过程中加入有 2-3 名队员鉴宝能力不足,就会遗漏掉宝藏,或捡回来很多垃圾,这就是奖励模型出错了。

还有一个更形象的身边例子,比如我们要训练一个马拉松运动员。假设运动员是 GPT ,已经通过语言、录像学到了博士水平,懂得各种知识和道理。现在我们给 Ta 设置一个新目标是取得马拉松的最佳成绩, GPT 就会探索各种方法,甚至找漏洞,从而取得达成最佳成绩的方法,比如如何科学饮食、最佳的跑姿、如何肌肉发力等。每次比赛结果相当于是给予了正面信号或负面信号。假设前一天运动消耗过大,会影响第二天的比赛,这就是一个负面信号。甚至有时候会为了达到最佳成绩去探索捷径。极端情况下,如果比赛没有禁止兴奋剂或者特定的某个兴奋剂,那模型就会把使用兴奋剂当成一种捷径。当然这就破坏了比赛规则,所以就需要制定新的比赛规则,也就是 AI safety 、alignment 的价值。包括狗的主人训练狗,这些例子的逻辑是一样的。

可以延伸讨论的是,这个过程意味着什么?如果基础模型变强,那每个人都可以拥有一个 5000 人特种兵团队、或是一个世界冠军,他们在各个领域去做探索。而人类就是一个教练员,指导 AI 如何做。人和 AI 在各个领域一起拿到金牌是一个会发生的蛮有意思的事。

这个过程中奖励模型就很重要了。目前业界奖励模型最核心的领域还是在代码和数学两个领域,因为这两个领域环境和目标都足够简单清楚、也容易设定。但其他领域的目标和环境不好设定。

这就会涉及到一个更关键的问题:代码和数学在未来两年可以确定性变强,但是否能够泛化到其他领域,目前还没有被证明。

AlphaGo 下棋很厉害,但其他领域并不行。计算机视觉在人脸识别领域很厉害,但其他领域也不行。AI 最重要的是通用和泛化性。如果, AI 不能泛化到其他领域,那这一轮技术天花板会受限。但即便不能泛化,我们借助大语言模型在各个垂直领域做强化学习,也可以在很多场景中找到最优解,那下限也会替换传统机器学习那一套。

张小珺:当我们讲强化学习的时候,它应该和什么概念作对比?强化学习和 LLM 的区别是什么?

Guangmi Li:这是交替的。历史上神经网络和强化学习一直是交替发展的。每一个神经网络变强后,大家都会提到强化学习。

LLM 是利用现有数据,而强化学习更多强调长距离探索。用户给模型一个粗颗粒度的目标,它就可以自己探索达到这一目标的路径。强化学习的核心是在探索和利用之间做权衡,LLM 在利用现有知识上已经做到很极致了,但探索新知识方面并没有做很多。强化学习的引入是为了让大语言模型能够探索如何进一步提升逻辑推理。

回看 AI 最经典的三大范式:监督学习、非监督学习、强化学习。其中,只有强化学习的假设是让 AI 进行自主探索和连续决策。这一方法是最接近人类学习的方法。

张小珺:我们现在讨论的是 self-play 强化学习,它与传统的强化学习区别是什么?之前也有 RLHF 这个概念,它和强化学习的区别是哪些?

Guangmi Li:传统强化学习与今天的 self-play 强化学习相比,最大的变量和区别是强化学习的主体 agent 计算量增加了 3-4 个数量级。

最早的 AlphaZero 是一个千万参数的神经网络,和今天的语言模型相差 3-4 个数量级。RLHF 的目的不是获取机器智能,而是人机对齐,使得 AI 能够更像人,但不能超越人成为超级智能。有一个简单的例子:RLHF 像人类一样,更喜欢好理解的东西,而不是喜欢逻辑更严密的内容。而 self-play 强化学习的目标是如何提升逻辑能力。

张小珺:大语言模型、强化学习、 AGI 这三者的关系是怎样的?

Guangmi Li:之前有一个很有意思的描述:语言是走向 AGI 的拐杖。虽然现在 在 Twitter 上很多人在批评这一表述,但其实很有道理,这个表述我体会了很久。

为什么语言是拐杖?因为语言被人类积累了几千年,是对人类历史几千年的压缩总结,又经历了三十年数字化,变成了互联网的 token 。大语言模型的诞生也是一个技术发展的必然,这是机器能够学到的最高密度知识。此外,语言的另一个好处是通用性强,同一个事物可以用不同的语言描述,同一个语言也可以有不同的理解方式,语言的弹性和容错性很高。

语言是今天唯一走通泛化性的。传统的 AlphaGo 没有被泛化,只能用来下围棋。CV 视觉也没有走通泛化性,只能做人脸识别。有一个猜想是人们可以借助语言的通用和泛化性,让 AI 能力泛化,走到更多领域。通用人工智能的核心还是通用和泛化性,语言和预训练有可能成为拐杖,像是中间态的甜品和前菜,而后面的强化学习才是主菜。

我们可以把语言和预训练比喻成携带了人类几千年进化基因的基因组,而强化学习是人类成长的一生。从出生那天起人们就不断接受正面信号和负面信号,就像职业运动员的职业生涯也是一个目标和环境定义很明确的特定任务,就是拿成绩、奖牌。无论黑猫白猫,能实现通用和泛化,这才是实现 AGI ,或者超级智能的关键。

张小珺:所以今天看光靠大语言模型可能走不到 AGI 。是不是可以假设 AI 是一个偏科语文的大学生,他到了要就业的阶段,需要新的范式引入。LLM 和强化学习应该怎么相互补充?

Guangmi Li:这是一个接力关系,语言模型是做强化学习的必要条件,重要的点在于我们要有很聪明的模型,采用能力做 self-play 、探索。

就像一个人如果没有一定的能力,做自我探索的能力也不强。这个标准可能是至少迈过 GPT-4 ,或者 Claude-3.5 这一水平。如果模型能力不足,做 self-play 的效果会很差。如果想做好强化学习,还是需要经过预训练这个必经之路。但是,强化学习又是一个预训练确定的未来。研究 AI 的人都会意识到:预训练最终一定会走向强化学习,不是今天,就是明年。刚刚提到预训练让模型学完了互联网上的所有数据,通过 self-play 自主探索,选出更高质量的一些数据去学习,这是一个长期能够 scalable 的路径。

一个更深层次的讨论是 self-play 这个方法的本质是用 AI 无限的算力来补足数据不足的短板。数据不够,算力来凑,这也符合当下 AI 的一个优势。一个好的 self-play 能够合成大量的高质量数据,甚至比人类历史上见过的棋局、游戏的数量更多。用这个数据量,也有可能达到超级智能。比如, AlphaGo 下棋、 Dota 游戏中, AI 都探索出了与人类不一样的玩法,也战胜了很多金牌选手。有一个循环:self-play 合成的数据用于预训练,激发更大预训练的计算需求,这也就相当于,整个大语言模型的预训练变成了强化学习系统中的一环。强化学习变成了更核心的系统,这样的循环才有可能更好地走下去。

张小珺:RL 的范式变化是硅谷现在通用人工智能领域当下发生的最大变化。这个变化是什么时候发生的?

Guangmi Li: Anthropic 的 Claude-3.5 是一个标志性的产品。今年 6 月 ,Anthropic 发布了 Claude-3.5-Sonnet 。我们能够看到,代码和数学能力显著提升。Anthropic 很早就开始重视强化学习。我感觉, Anthropic 主要下注在两个方向上:第一是下一代模型,第二是强化学习。Anthropic 既不做 Sora,也不做搜索,主线就是强化学习。

强化学习在研究层面已经持续很久了。OpenAI 最早就使用强化学习这一方式打 Dota 游戏。核心变量其实是语言模型的能力发展到了一定程度,用大模型用 self-play 强化学习开始变得有效了,之前这个方向的效果并不好。我感觉语言模型预训练遇到瓶颈是这 2 个月的新判断,外界可能不一定意识到语言的预训练到达瓶颈了。

张小珺:在你看来强化学习的上限是什么?

Guangmi Li:强化学习的上限是代码和数学能力无法泛化到其他领域,而其他领域无法被制定出好的奖励模型。但如果人们把代码能力变得很强,人们未来用自然语言后端实时编程,也会大幅度加速人类整体数字化的进程。

张小珺:如果有了新的范式,那 GPT-6 ,或 GPT-7 ,还会存在吗?

Guangmi Li:如果只靠传统路径的加参数、 scaling ,那短期的预期其实不高的,因为范式在变化。但我还是相信接下来每一代模型都会变得很强。

我不确定未来还是否会沿用 GPT-5 、 GPT-6 、 GPT-7 这种代号,也不确定模型的参数是否还会倍数级增大。有可能参数并不会增加很多,维持在 GPT-4o ,或 Claude 3.5 的参数级别,但未来也能持续变聪明,达到大家对下一代模型的预期。

其次,明年我们可能可以看到很小的模型,却比 GPT-4o 聪明很多。单位参数下,智能水平提升是很快的。因此可以期待,实现 AGI 并不需要巨量参数的模型。

张小珺:听起来在硅谷实现 AGI 的方法与范式彻底改变了,但大多数人可能到今天还没有意识到?

Guangmi Li:是的,不过新范式下也会有很多卡点。

比如刚刚提到的,奖励模型是否可以泛化到更多领域?代码和数学能力提升的确定性是非常高的,因为,下棋、游戏、数学、编程这些场景都有明确的胜负,可以比较好的做 self-play 。尤其编程方面会非常乐观。

有些领域比如物理、医药,即使通过 self-play 产生了结果,还需要临床进一步验证,涉及到物理世界周期就会很长。

法律、金融领域同理,这两个领域没有太多标准答案,但如果做到偏好或偏坏,比如 A 和 B 分别写了一个投资 memo ,有裁判能够对比哪个更好,这也有可能是一个奖励模型。投资领域,比如一级市场,构建奖励模型就过于前瞻了,反馈时间会很长。二级市场的噪音又很多。文字创意领域又包含着各种剧情的反转、跳变,这也是 AI 很难捕捉的点。

所以还有很多问题要解决,是否能有绝对通用泛化的奖励模型应用到各行各业,还是只能在垂直领域一个一个构建,这目前不好说。

其次,大家期待另类架构也很多,从更基础、更底层的架构出发,不是 Transfomer ,而是未来可以应用到全模态,尤其是视觉,这也是需要天才科学家去突破的重点。大家对于天才科学家的价值应该预期更高。

比如,Character.ai 的 Noam 本人,价值就超过了 20 亿美金。Google 收购 Character 主要也是为了Noam 。这笔帐算的很清楚,如果 Noam 对整个 Google 可以提升 1%,就对应了 200 亿美金。Google Gemini 也能占到 Google 市值的 10%, Noam 让 Gemini 提升 1% 的确定性很高,那也就对应了 20 亿美金的增益价值。在传统估值体系下,这种方式是不被认可的,这个收购价格等于 Google 一天的利润。

张小珺:你怎么看 Character.ai 的出售?它给今年的 AGI 市场带来了什么信号?

Guangmi Li:上半场已经结束了,而下半场正式开始了。进入下半场的选手并不多,Noam 加入 Google 也意味着行业正式进入下半场了,新范式 self-play 强化学习成为主角。

张小珺:语言模型的关键要素是算力、数据、算法,self-play 强化学习的关键要素是什么?

Guangmi Li:强化学习不是一个模型,而是一整套的系统,其中包含了很多因素,第一,强化学习包括了智能体,其中的 agent 就是模型。第二,包括了环境,环境可能是狗主人的家,也可能是编程环境,也可能是垂直领域。第三,包括了动作,是狗坐下,还是一些其他模态的输出。第四,包括了奖励模型,这也很重要。

如果要列举最重要的两个因素,那会是环境和智能体。智能体的目标是得到更多奖励。强化学习在语言模型中的思路,本质上是 inference time 换 training time 。这是为了解决模型向上 scale up 时,暂时的边际收益递减现状。这势必也会对 scaling law 带来很多新变化。或者我们可以认为,传统的 scaling law 无效了,而新的 scaling law 要开始了。

张小珺:新范式下还需要那么多 GPU 吗?英伟达会受到哪些影响?

Guangmi Li:这个不确定。在强化学习的新范式下, scaling law 会被重新定义,因为训练时的计算量不止和参数量上升有关,也多了一个新的变量:self-play 探索时 inference 的计算量。

强化学习的思路本质是用 inference time 换 training time 以解决边际收益递减问题。我们之前算过一笔账,对于 GPT-4 或 Claude-3.5 这种水平的模型,如果要合成 1T 高质量推理数据,需要 6 亿美金。如果合成 10T 高质量推理数据,需要 60 亿美金,这个量级很高。但是,与预训练不同的是, inference 对单张卡的性能,以及集群规模的性能要求相对低一些。不一定非要用最顶尖的卡,或 3-10 万卡的集群。分布式的集群也可以用来做强化学习的 inference 。

新范式下, scaling law 依然存在,计算成本还是会大幅提升以提升模型能力,但提升并不一定代表模型参数量的快速增加。

长期是否还需要那么多 GPU ,取决于强化学习的效率。目前来看,算力资源是浪费的,因为 99% 的步骤最终都是无效的,但依旧需要去跑这些错的步骤。因为如果一开始没有藏宝图,那 AI 需要解决的是很多没有碰到的新问题。这样看,确实会存在大量资源浪费问题,除非未来会更高效。

另外, inference 并不需要完全依赖英伟达的 GPU 了。AMD 或者其它的 ASIC 芯片,有可能也适用于 inference。当然,英伟达的 GPU 还是性价比最高的。相比于其他公司,英伟达的领先地位还是逐渐在拉大。因此,它也能覆盖到新的范式变化。

股价层面,二级市场是容易线性外推的。也许,明年或后年英伟达会成为全球利润最高的公司,超过苹果,达到千亿美金级别的利润。线性外推的订单从短期看是没问题的,但 AI 的叙事变化很剧烈,因此,长期变化目前很难下判断。

张小珺: AGI 范式发生转移这件事目前是共识还是非共识?

Guangmi Li:目前范式转移只有在最核心的研究员中有一些共识,可能几百个人,还没有完全扩散。或者说,很多人都知道强化学习很重要,但并不知道怎么做。这方面人才很稀缺,也并不来源于传统强化学习路径的人才,很多 AI 公司的管理层还没有意识到这一转变,最近也只有少量的一些论文发布。

张小珺: Yann LeCun 最近反而在批评强化学习,认为这是一种资源浪费行为。

Guangmi Li:爱迪生发明灯泡也浪费了大量的实验资源,但只需要成功一次,即可以大量复制。LeCun 现在喜欢说一些引起争议的话,有争议才能有流量,效果才可以被放大,背后是 AI 领域不同流派的辩论,每个流派都有各自的道理,都要给自己的流派站台。

张小珺:基于讨论的内容,你对 AGI 的现状是更乐观还是更悲观?

Guangmi Li:开始几个月发现语言模型的预训练遇到瓶颈不顺利后,感觉还是悲观的。之前我会以为直到 2025-2026 年 AGI 才会遇到瓶颈,但没想过会这么快遇到瓶颈。但我想了 2 个月以后,会感觉更乐观了。

Self-play 强化学习如果真正有效,实现 AGI 和超级智能的路线就更清晰了。强化学习实现后的天花板会更高,距离实现 AGI 也更明朗了。我自己是用 Claude-3.5 也会有类似的切身体会。

张小珺:有什么最有效的指标能够衡量强化学习的进步?

Guangmi Li:第一是取决于 AI 可以写出有效、可靠代码的行数。去年 AI 只能写出 20 行代码。但今天 AI 可以写出几百行代码了,也许明年就可以写出几千行了。Claude-3.5-Sonnet 是一个显著的提升。最近 Cursor 也很火,而它火的很大原因是因为接入了 Claude-3.5 。

以前 AI 无法完成的事情,今天可以完成了,这就是显著提升的指标。代码的行数是一个能有效体现强化学习进步的量化指标。

第二是公开且权威的数学题测试集。GPT 目前可以在测试集中达到 70-80 分。未来,在没有人工干预的情况下, AI 是否能够达到 100 分 ,解答所有问题?不追求速度,让 AI self-play ,自己去解题。如果答案全对,这就是一个很大的强化学习突破。

张小珺:强化学习目前全球来看谁最领先?

Guangmi Li:强化学习还是 Anthropic 和 OpenAI 比较领先。去年 Dario 在访谈中就公开提到过强化学习,包括 OpenAI 在造势的草莓、 Q* ,背后也是强化学习。

Deepmind 的强项在于传统强化学习,而新范式的 self-play 强化学习还不确定。Deepmind 有人才优势,但管理层不确定是否重视。除了这几家外,其它的模型公司还没有开始重视,或不知道怎么做。比如 Llama 应该就完全没有做。

张小珺:接下来我们有什么值得期待的大事情或节点?

Guangmi Li:接下来的 1-2 个月, Claude-3.5-Opus 和 Haiku 两个新模型发布值得期待。OpenAI 也会发新的模型,因为草莓也造势很久了,不知道效果如何。

张小珺:其他模型公司有可能利用强化学习弯道超车吗?

Guangmi Li:是有可能的。但语言模型与强化学习是一个乘积关系,是 A 乘以 B 的关系。如果 A 的数值不高,乘积的数值还是不会高。

如果 model size 短期无法提升,对 OpenAI 这种头部公司会影响较大,而对后面跟进的公司是利好的。如果是我,我会下注 200% 的资源跟进,也会思考如何发挥人力的优势。比如,消耗更多人力成本去标数据、设计真正有效的奖励模型。但是,如果没有很强的底座模型,是无法做 self-play 的,效果很差。或者说,用很强的模型能看到的东西,很差的模型是看不到的。

张小珺:范式变化有可能会给市场带来什么样的结构性改变?

Guangmi Li:下半场正式开始,以后就是强化学习的天下了。目前看,奖励模型可以泛化到整个文本推理领域的概率较小。不同领域对奖励模型的定义是不一样的,而这反而给许多创业公司建立垂直领域奖励模型的机会。更具体,需要看 OpenAI 与 Anthropic 是否对外开放奖励模型 fine-tune 接口,这很关键。

其实,每个领域都值得建立垂直奖励模型。这样在每个垂直领域都会有很多收益。而创业公司,需要找到细分领域的 reward signal 。我觉得机会是很多的,第一类,给垂直领域建立奖励模型,比如金融、法律。第二类,通用奖励模型,利用一个 agent 建立通用场景,比如浏览器,目前也有很多公司在做。当然,也会出现一个大的变化,可能未来并不再需要超大规模的单一互联集群了。其中,不确定是否还需要如此大量的 GPU 。短期来看是需要的,但是,长期来看不确定。我个人最兴奋的,是编程能力的民主化,这是一条很重要的赛道。

张小珺:假设模型能力就停留在 GPT-4o 的水平会怎么样?

Guangmi Li:我觉得也有一半的概率可以实现 AGI 。如果强化学习可以泛化,我觉得是没问题的。如果不能,下限也可以替换掉传统的机器学习,以及编程能力会变强。如果编程能力变强,其它很多领域也会加速。

张小珺:你觉得草莓会让我们吃惊吗?或是超出我们预期?

Guangmi Li:能力还是会变强很多,尤其是编程和数学。在局部领域。未来 1-2 年,编程是确定性更高的,可以看到局部的 AGI ,或是局部超过人。AI 很有可能可以帮助一个不会写代码的人,生成一个很复杂的程序。人的预期是很高的,我不确定模型的迭代是否能够满足大众的预期。编程还是专业领域的,大众群体有时候是感知不到这个领域的提升的。更长期的期待,是看强化学习的天花板可以延伸到哪些领域,能不能在更多领域泛化通用。

03.

代码、视频生成、机器人

张小珺:大模型热潮之后,要再怎么划分 AI 赛道?

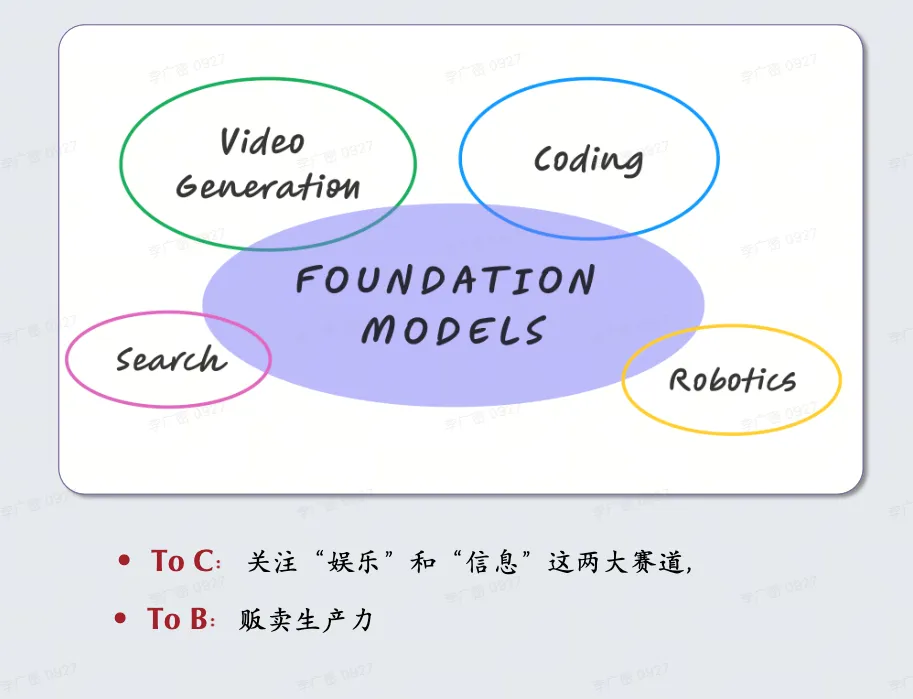

Guangmi Li:如果是新的 AI 赛道,需要靠 AI 的模型为基础。我们自己画过几个圈,最大的一个圈是大语言模型,也是此次技术革命的核心。围绕大语言模型,向外可以延伸出 3-4 个圈:搜索、编程、视频理解和生成、机器人。我感觉是一个大圈套着四个小圈的关系。

• 代码方向:

为什么代码会成为一个单独的赛道?它是否足够大?其实,代码领域过去一年就已经在硅谷很热了。出现了 4-5 家独角兽公司。比如 Devin 、 Augment 、 Magic, 以及巴黎的 Poolside 。这几家公司最新已经 20-30 亿美金估值了,但很多家公司的产品还无法使用。包括 Cursor ,一个最近特别出圈的编程工具。

Cursor 火的核心逻辑,还是它背后的 Claude-3.5-Sonnet 的代码能力变强了。就像刚刚提到的,有效代码从几十行增加至几百行。Claude-3.5-Sonnet 是这个行业类似于 iPhone 的摄像头的底座,而 Cursor 是基于摄像头上的拍照工具。今天的 Cursor 定位,依旧是供专业群体使用的工具,还很早期。

我最期待的是能够出现一个给大众级消费的 Coding 编程工具,因为大众级工具的背后会真正出现技术民主化的趋势。比如 Adobe Photoshop 在创意和内容上很强,全球 2-3 千万的设计师需要靠 Photoshop 进行日常工作。但如果看大众群体,抖音、剪映、 Canva 这些消费级工具,活跃用户都是上亿级别,比 Photoshop 几千万的用户要大一个量级。

iPhone 是有摄像头的,但抖音是独立于苹果的,是一个独立的超级应用。未来可能用户使用自然语言描述需求,比如“让超市每周一 8 点送水果和本周食材到家门口”。今天是没有程序可以满足这一类需求的。以前的程序只能满足头部需求,而满足不了长尾的需求。未来,自然语言编程、 Agent 通过多步、长距离推理,可以满足类似需求。

AI 编程公司如果只做专业开发者群体是有限的,上限天花板就是 Github ,100 亿美元估值。最有想象力的故事还是大众消费及市场。

未来可能会出现一种任务引擎( Task Engine ),而今天的 Google 是搜索引擎( Search Engine )。任务引擎可能会是新一代的 Google 。Google 提供的是信息,任务引擎是完成任务,而完成任务是这一轮技术革命下最核心的主题。当然,具体任务会由谁完成,这个不好说。可能是 ChatGPT 完成了,也有可能是主流搜索公司完成了,也有可能落到 AI 编程公司内。甚至,今天面向专业群体的编程工具是否可以下沉到消费者群体,目前也不确定。

张小珺:之前我们播客提到的 Perplexity 是可以匹配现在模型能力的最好应用。所以在强化学习的新范式下,现在能匹配模型能力的最好应用是不是编程?

Guangmi Li:是的,有可能 Cursor 会是今年的 Perplexity,达到模型能力匹配产品最合适的一个阶段。我们刚刚提到代码生成能力从几十行到几百行, Cursor 的能力变得更强了。

对比 Perplexity 和 Cursor, Perplexity 所在的搜索和广告的市场是足够大的,占领总份额的 1% 都是很大的生意。但 Cursor 所在的代码领域,付费群体是不够大的。搜索和编程都有巨头,编程工具最大的目前是微软的 VScode ,垄断性很强。广告的生意足够大,这是相对的不同。

此外, Perplexity 和 Cursor 目前的门槛都是偏高的,如何下沉到更大的大众消费级市场,这更像是大公司的机会。

张小珺:你怎么看视频领域?

Guangmi Li:编程和视频是我现在最兴奋的两个赛道,觉得应该下注在这两条赛道里面。

首先,在 OpenAI 的 Sora 推出后,过去半年视频生成的进步效果非常大。半年前生成的视频中人物走路动作速度是很慢的,而今天是很丝滑的。Sora 给行业带来的推动效应是很大的,指明了 DiT 这一路线。

视频层面大家远远低估了创意和内容的赛道。手机有了摄像头后,人人都可以拍视频,也就诞生了抖音。许多抖音视频播放量可以达到数亿,比传统大导演还要有影响力。如果视频生成能力很强,那人人都有可能变成电影级别的导演。每个人都有自己的想法、创意,只是先前没有专业能力呈现出想法和创意,今天用很低成本就可以实现。以前的电影需要千万,甚至上亿美金的拍摄成本,但未来有可能很多爆款电影仅用几万美金成本即可完成编剧、生成、营销的工作。

简单来说,未来 AI 是否能产生更多的李白、杜甫、毕加索、梵高?因为 AI 生成的内容质量更高。人与 AI 共创,可以有更多天才的想法被实现出来,这很让人兴奋。电影只是一个例子。目前, AI 的可控性还有限。

目前,视频生成的整体格局很不稳定,并不像语言模型竞争格局清晰。视频生成领域的风险是很大的,因为技术架构没有统一,目前有种“各领风骚 100 天”的形式,每家都有自己的下注点。

比如有的团队面向的广告群体,有的团队去做电影动画,需要的数据是不一样的。

视频生成可能会像是内容行业,最后是分散的格局,而不像语言模型一样赢家通吃。视频赛道很诱人,但是风险也并存。如果向上展望,视频生成可能出现新的 TikTok 级别的机会,但窗口是比较长的。今天竞争已经开始了,但决胜窗口需要持续 3-4 年。所以我们过程中就需要紧密追踪,甚至今天就需要下场压注一些领域。

未来技术架构也会有很大变化,可能出现全新的架构。

张小珺:视频不止在生成,理解也很关键?

Guangmi Li:是的, Meta 和 Rayban 合作的眼镜就很有意思,现在的销量已经达到上百万台了。但假如全球有一亿人每天戴着这类眼镜,就可以从人们日常习惯内总结出更多人类、商业的习惯。AI 即为新的牛顿,能够总结出人类没有发现的新规律。而且眼镜采集的是非常关键的数据,因为机器人同样需要这种第一视角的数据。

张小珺:怎么看语言和视频模态的关系?

Guangmi Li:语言是最难的,因为它是人类几千年进步的抽象。语言模态的竞争是最激烈的,今年结束前,座次、排名基本就稳定了,很难出现翻盘的情况了。但视频的格局竞争座次很模糊,变化也会很大。

可能语言底座叠加其它模态是相对容易的,而其他模态想反向做好语言模型是比较难的。视频可能会独立,或像内容产业一样多家共存。

张小珺:视频生成你最看好哪家公司?

Guangmi Li:因为格局不稳定,所以目前比较难说。下注于任何一家初创公司,风险都是很大的。现阶段只能选到相对的最优。最早 Runway 很火爆,后面 Pika 也很出圈。最近 Luma、Kling 也很火。

与此同时,我们目前也不知道 OpenAI 的 Sora 2.0 的进展如何, OpenAI 肯定在资源、人才方面都更强。

视频生成肯定也在字节、 Meta 两家公司的核心辐射之下。今天不好说哪一家最好,这是一个在未来 3-4 年关键角逐的赛道。

张小珺:你怎么看机器人领域?

Guangmi Li:硅谷这一波通用机器人的炒作还是 OpenAI 带动起来的。大家想赌一个具身领域的 OpenAI ,但这个赌注不是一个投资和商业的问题,而是一个基础科学是否能突破的问题,目前看起来还很早期。

硅谷的通用机器人公司,本质都还是一个实验室,而不是一个商业公司。但这个实验室到底是 2-3 年就能有突破,还是需要 10 年时间突破,目前是不好判断的。今天肯定还是靠着 10 年这个时间维度来计算的。其中最关键的点在于,哪家公司可以像 OpenAI 一样融到 20-30 亿美金,能够有足够的资源多试错几次。如果没有基础科学突破,那这里面优秀的人才还是会被大厂兼并。

对于大公司来讲,与语言模型相比机器人的重要性并没有那么重要。语言模型在每一家科技巨头的主线下,但不是每个巨头都需要做机器人。今天做机器人的巨头主要是谷歌、特斯拉,以及亚马逊。谷歌和特斯拉的内部机器人团队还是比外部要更强,每年会有几亿美金投入。因此,这两家公司并不会像微软,支持一家具身 OpenAI 。

另一个基础科学问题是,我们还没有在通用机器人领域真正看到通用、泛化的能力。目前,大家还是在针对特定场景进行模仿学习。而设备 A 采集的数据,目前并不能套用于设备 B 上。目前数据采集成本很高,每小时从几十美金到几百美金不等,甚至每个场景都需要几百个小时的采集工作。此外,目前也并没有确实很好的产品定义和场景,也没有真正用户愿意买回家,并且能带来用处的机器人。今天,用户还没办法做到让机器人把衣服先放进洗衣机,之后放进烘干机,或是把餐具放到洗碗机里,再倒上洗碗液。最后需要基础技术突破的。如果没有泛化能力,通用是很难达到的。

机器人领域中,我认为中国的宇树科技是不错的。宇树是机器人的富士康,背后还是因为中国的供应链优势强。

张小珺:美国的通用机器人领域有哪些明星项目?

Guangmi Li:我认为最头部的公司有两个:第一是 Pi,团队先前在 Google Robotics Team 。几位 Founder : Chealsea 、 Sergey 都是有绝对人才优势的一个团队。

第二是 The Bot Company ,是自动驾驶公司 Cruise 的创始人 Kyle 成立的新公司。这两家公司是机器人核心圈,包括机器人研究员们认为最头部的两家公司。

当然,声量比较大的还有由红杉美国投资的 Skild AI ,以及 Figure AI 。

Figure AI 的融资能力很强, CEO 讲故事的能力也很强,但 OpenAI 对它的投资额其实只有几百万美金左右,并没有很多。Figure AI CEO 的故事是 OpenAI 的机器人模型交给了 Figure AI 去做,但我认为合作形式可能是:Figure AI 给 OpenAI 一些机器人的数据, OpenAI 的团队帮助 Figure AI fine-tune 一个机器人的模型, Figure AI 再去解决端到端的工作。

Figure AI 的定位,从竞争层面看会有些尴尬:AI 能力不是最强的,而硬件能力又没有中国的公司强。只能说, Figure AI 在硅谷来看,它的硬件能力、端到端能力强过竞争对手,但硬件能力又没有 Tesla 那么强。这个公司感觉被高估了,人才密度也不见得有另外几家公司强。

张小珺:据你观察,国内的机器人相比硅谷的机器人项目会有哪些不同?

Guangmi Li:国内应该走 Tesla 的路线,从模型到硬件的端到端。 AI 在模型上的投入不用很大,等待开源即可。

国内需要先定义好硬件产品,或者场景,找到一个特定场景去做落地。比如 Tesla 就有出行的刚需场景,手机也是基于通话的刚需场景。只有确定场景,才能落地,并把轮子转起来。

目前的技术还并不能支持场景或动作上完全通用,因为做过动作 A 后,并不能泛化到动作 B 上,在设备 A 采集后也不能用于设备 B 上。硅谷现在想要投资的,也是机器人的大脑。类似于 IOS 和安卓。国内更像是做整机,与小米、华为类似,

其次,从终局角度看,机器人可能并不是唯一一个 AI 模型适配所有硬件。诚然, IOS 、安卓可以适配所有硬件,但机器人有可能就是需要端到端的优化,从模型,到硬件,再到数据。因此,需要找到一个大的场景,大规模收集数据,针对单一场景端到端优化。

Tesla 的逻辑其实是合理的,机器人和自动驾驶也是相通的。但硅谷除了 Tesla 以外,制造能力都不够优秀,因此还是需要中国的供应链才能真正落地。

目前我看不到硅谷有整机,全套的产品推出。通用、人形机器人的大爆发还需要 5-10 年,很可能目前公司没有真正做出来。而最近的这 5-10 年期间,大家依旧在实验室的阶段。因此,现阶段还是应该在最顶尖、最独特的科学家人才上下注。硅谷是容易做收购的,而中国并没有收购的习惯。通用机器人最核心的判断点还是技术成熟的时机,因此,在硅谷投资一个机器人大脑,而在国内投资整机,会是一个很好的风险对冲机会。

但也会有悖论观点是:可能并不存在一个机器人大脑,而机器人的大脑是 GPT ,或是通用的大模型。做一个机器人大脑,有可能不适配所有硬件。机器 A 的数据不能用在机器 B 上,还是需要端到端适配。

张小珺:今年具身智能赛道很火热。国内的机器人投资人认为,在大脑层面,国内有很多做类似方面研究的华人科学家,所以无需担心在 AI 能力上能够追平美国的可能性,差距会比大模型小。你怎么看这件事情?其次,中国公司有实验室文化吗?

Guangmi Li:国内的硬件能力是非常强的,而国外的 AI 能力是非常强的。如果有一个团队,可以结合这二类能力,那是最乐观的情况。从大模型,到多模态,再到具身智能,乃至未来的世界模型,这是 AI 发展的过程,每个环节也都有自己的价值。甚至 AI 人才是可以跨界的。比如,多模态的研究也可以促进机器人和世界模型的研究。这里面其实有很多华人科学家,也有不少人回国了。我认为这是有可能培养出比较好的 AI 研究文化的。但是,除了人才,经济基础最重要。经济基础、创新环境、信仰,这些比较虚,但是确实很重要。事实上,近两年愿意回国的研究者相比于 7-8 年前还是在减少的。

国内有国内的优势,比如各种硬件支持、供应链等,也不一定需要一等一模仿美国的逻辑和步骤。最现实的还是先要解决具体场景的具体问题,也不需要用最强的 AI 能力。今天,国内做通用机器人还是比较早。

张小珺:现在是投资机器人最好的时机吗?

Guangmi Li:这取决于以什么角度来看待机器人。如果,期待是投资一家很强、具有通用能力的机器人,或是在家庭、工厂做通用任务的机器人,目前并不是最好的时机,并且真正的时机距离现在还很远。但是,现在有越来越多人才、资源都进入这个领域,那最后也不至于做不出来任何成就。比如,美国的机器人大脑、机器人的 foundation model 还是会有进展的。这些优秀的团队、人才,还是有很大概率被收购。全球在机器人的投入越来越大,把硬件做到极致,卖给全球的实验室,这也是很大的市场。机器人的研究会带动很多周边研究,某些新东西也会先出来。

张小珺:这一波浪潮会对先前成立的机器人公司会有什么冲击和影响?这个赛道已经存在 10 年了。

Guangmi Li:之前的机器人公司商业化还没有做好,因此,今天是否有足够多的资源投入到通用、人形机器人的研发中是不确定的。其实做人形是很容易的,大家都会发一些产品,好像没有人形产品就会掉队一样。但是真正投入在技术上的公司是比较少的。

如果一直没有技术落地,这些公司大概率还是会走向特定领域,大家有理想,也有现实。所以就看谁可以先定义好的场景,或是好的产品,但今天做的还不多。

机器人不像编程一样目的简单。现在只有军用、消防场景有明确目的,因为人的生命更贵。但军用和消防都还是在特定领域做优化,产品还停留在设备角度。对是否是人形的关注度不用很高,甚至对 AI 能力要求也没有那么高。

04.

What’s Next?

张小珺:复盘来看,过去一年,硅谷哪些东西是超出你的预期的?

Guangmi Li:公司层面,超出预期的有两家,第一家是 Anthropic ,从落后于 OpenAI 18 个月到目前,已经模型层面追平,甚至有微弱的领先优势了。另一家是 Perplexity ,这也是我们上次讨论过的公司。这两家公司是超出我的预期的,其它超出预期的公司没有太多。OpenAI 我认为是符合预期,甚至由于领先优势没有放大,有些低于预期。

我最近恶补了强化学习后,感觉走向 AGI 的路径更清楚了。所以,强化学习的提前到来是超出我预期的。

张小珺:最近几个月,最让你兴奋的 ideas 有哪些?

Guangmi Li:最重要的还是要把模型能力变得更聪明。

张小珺:站在今天,用大语言模型重新对比移动互联网,它的主线叙述逻辑是什么?

Guangmi Li:移动互联网与今天的大语言模型作对比很有意思,可以画一个图,主线可以有一条明线、一条暗线。移动互联网的明线是全球新增了 40-50 亿移动用户,而暗线是获得了用户行为数据做推荐。过去十年,没有做推荐的公司都没有做得大。移动互联网有几个关键的特点:大屏幕、摄像头、 GGPS,每个特点都诞生了大公司。因为大屏幕摄像头,诞生了抖音、TikTok ,而因为 GPS,诞生出了 Uber 、滴滴。今天的 AI ,明线还是 scaling law ,虽然在发生范式的变化,但是背后的核心还是算力。大家对这条明线是有共识的。而暗线具体代表了什么?

在先前的新时代摩尔定律中,我们当时讨论的暗线是成本,但今天变成了 self-play 强化学习。大家低估了强化学习的重要性,甚至,目前没有做强化学习的公司,下一轮浪潮中无法继续跑下去。今天,大语言模型的关键能力,如果让我做重要性的排序,会是:1)编程,2)多模态,3) 数学,4) Agent 。甚至还有一些其它的领域,比如个性化、可靠性等。和我们先前的观点一致。无论观察主线暗线,还是观察关键能力,都还在渐进提升的阶段。而应用也是随着渐进式提升的过程中逐渐解锁的。

张小珺:你是什么时候意识到强化学习这么重要的?

Guangmi Li:最近 2-3 个月。

张小珺: AI 领域的最大体量数据来源于哪里?移动互联网最大的数据来源都是新产生的数据,而非旧的应用积累。

Guangmi Li:是做强化学习的过程中 AI 产生的数据,加上人类指导的数据。就像是一个教练员指导运动员反复训练的过程产生的数据。

张小珺:站在今天,你可以重新评价一下中国这些大模型公司吗?

Guangmi Li:技术辨识度依然没有完全拉开。其次,想要真正做 AGI 的公司不多,大家都更想做 killer app ,但是今天还没有看到 killer app 的影子。今天,形态主要还局限在 chat 、搜索、以及类似于 Character.ai 这几个产品形态。今天这些公司的估值还是由 AGI 故事撑着,但也没有什么办法,类似于月亮与六便士,是我,我也会这么做。

其次,去年大家花了 3-5 千万美金去训练了初代语言模型,大家从能力上做到了 GPT-3.5 的水平。但后面很少有公司再继续跟进几亿美金投入去训练一个新的模型了。甚至 70-80% 的公司会放弃预训练,大家会直接使用开源模型做 post-train 。大家做预训练可能还达不到开源的水平。目前,大家没有明确看到未来的收益,贸然做预训练,资源投入的风险太大了。

张小珺:今年年内你预计有几家能够达到 GPT-4 的水平?GPT-4 的水平还会是一个关键的门槛吗?

Guangmi Li:国内会至少有 2-3 家公司真正意义上达到 GPT-4 的水准。比如字节跳动、Deepseek,以及阶跃星辰。它们还是在认真的做 scale up。GPT-4 还是一个走向下一阶段的必要条件,如果走不到类似阶段,后面还是会面临着 A*B 的乘积关系,如果 A 不行,就会比较吃亏。

张小珺:但 GPT-4 和强化学习可能是需要同时进行的,对国内整体来讲,应该再加大投入大语言模型吗?

Guangmi Li:是的,现在的投入还是不够。移动运营商对于 4G 和 5G 的投入都是 7-8 千亿人民币的量级。公路、高铁投入也很大。所以对 AI 方向,再怎么投入都不为过,但这是一个基础研究层面的投入,和移动网络、高铁等还是不太一样。

张小珺:要支持好基础研究需要什么条件?

Guangmi Li:贝尔实验室的诞生来源于 AT&T 很赚钱。Deepmind 之所以存在、每年大量投入,也是因为 Google 的支持。如果没有一个强大的现金流支撑,就没办法支持这些科学家冒险。其次,愿景和文化也很重要,比如 AGI 就是一个很诱人的愿景,可以吸引到最优秀的人,而优秀的人加入前也不用担心商业压力。一个非常纯粹的研究型组织,文化愿景是很重要的。

张小珺: 你怎么总结 OpenAI 过去一年的商业?

Guangmi Li: OpenAI 有些浪费了技术领先的红利。GPT-4 去年年初刚刚发布时,是非常领先的。但是领先优势并没有转化成很明显的产品、或商业上的飞轮优势。今天 40 亿美金的 ARR ,有消息说年底能够达到 70-80 亿美金 ARR ,数字上很成功,但按理应该更好。背后很大的原因是 OpenAI 没有找到对的人,做出更好的天才产品。

比如 self-play 强化学习, ChatGPT 今天是没有很强的数据飞轮的,不像推荐、广告这么强。包括 OpenAI 除了 ChatGPT 外,其他产品目前看都不算太成功。今年发布的 Sora 、SearchGPT ,包括先前的 Plugin 、Dall·E 、 GPTs,感觉都是产品还没做好就发布了。OpenAI 自己没落到什么好处,反而还启发了行业的其他玩家,更像是给行业做公益。ChatGPT 的订阅商业模式比广告的商业模式要差,广告的商业模式还是今天最好的商业模式。

张小珺: OpenAI 的组织、人才在今年有很大的动荡,这对 OpenAI 的影响大吗?

Guangmi Li:不会带来基本层面的影响。

首先,目前最核心的人都没有离开 OpenAI ,其次, OpenAI 也不会因为缺少某个人就无法运转。OpenAI 的人才密度极其高,甚至可以说是过剩的,反而管理层不一定能够压得住这些高密度人才。

但一些核心创始人离开可能影响公司的内部信心和凝聚力。创始人离开,甚至加入竞争对手公司,会对人才的信心带来影响。

张小珺:Ilya、Greg Brockman、John Schulman 这些核心创始人的离开会带来很大影响吗?

Guangmi Li:技术上影响不大,也许历史使命已经完成了。

我不确定 Greg 是否会自己创业,他以前是一个比较喜欢从 0 到 1 的人。但 OpenAI 我不确定目前是否算完成了从 0 到 1 ,如果 Greg 依然要做 AGI ,那他应该留在 OpenAI 继续做 AGI ,或离开后去创业也会比较有意思。

John Schulman 已经宣布加入 Anthropic,他的离开影响也不大。他之前是 OpenAI post-training 和强化学习的负责人,按理说强化学习是今天核心总的核心。市场普遍评价说他平时不太喜欢管理,很多工作在去年时已经交给 Barret 了。Barret 是现在是 OpenAI post-training 的核心。

感觉 John 的风格偏向于独立做研究、做个人贡献。Anthropic 这种纯粹的研究导向风格可能反而更适合他。OpenAI 人才足够多,而核心的人并没有走。因此,这些人离开影响都不大。

张小珺:回头看 Ilya 的离开,原因会有哪些?有些人说他的离开与 Q* 有关。

Guangmi Li:一种概率是, Ilya 更早看到了实现超越 AGI 的超级智能更快路径,但去年并没有与 Sam 达成一致, Sam 更追求商业或 ChatGPT 的成功。另一种概率,管理层有一些不可调和的矛盾。

Ilya 的新公司叫 SSI ,中文名是超级人工智能。我感觉他很自信,似乎看到了实现超级智能的路径。不然也不会轻易开一家公司,甚至近期很激进地在招人。

Ilya 会下注的方向还是强化学习、 Q* 这个方向。Q* 最早是基于 Deepmind 的一篇论文,是 Ilya 最早提出来的观点。2018 年, Ilya 就开始提这个方向。强化学习是 OpenAI 很深入的传统,如果 Q* 是 Ilya 提出的,那他应该很早看到了纯语言模型预训练的不足。草莓更像是一个项目代号,强化学习是方法。而 Q* 是最早缘起的一篇论文。

张小珺: AI 是你觉得颠覆所有巨头的方向吗?

Guangmi Li: AI 的颠覆性还没有那么强,或是时机还没有到。我认为 AI 更多的是重构了很多巨头。

其实今天的 GPU 以及 AI 的人才都很贵。这有些像一个战斗机飞行编队,有的飞行员一共有 100 小时飞行经验,而另一些飞行员有上千,甚至上万飞行时长。这就是所谓的百卡人才、千卡人才、万卡人才。其实,如果没有开过战斗机、经历过大量的训练,那很难成为一个很出色的飞行员。而创业公司今天是缺卡的。

一个比较大的不同是,今天的 AI 只改变了生产环境,但分发、消费环节都在成熟的老公司里。

张小珺:怎么看红杉美国 David Cahn 的 AI’s 600 Billion Question 这篇文章?David 觉得 AI 的收入增长与基础设施投入之间的差距,每年需要填补的 AI 投资的收入缺口已经增加到了 6 千亿美金。

Guangmi Li:这个问题很难回答,文章的标题也会有些标题党。我认为整体缺口并没有达到 6 千亿美金,因为大头还是来源于大公司的云、广告 AI 产品。而真正用于模型上的其实还可能没到千亿美金。大模型的收入和用例是低于预期的,这个是共识。但我们只能寄期望于下一代模型,尤其是 GPT-5 ,或者 OpenAI “草莓”的进展。

David 描述的问题,更像是一个历史规律的问题。每一次科技变革都会先经历硬件投入,再做基础设施建设、最终应用爆发。历史上,也都是先有铁路建设,再有后来的经济活动。先有芯片、 PC 、 iPhone ,再有移动互联网。先有数据中心,再有企业上云。

2010 年时,亚马逊当时只有思科的三分之一市值。当时思科已经 1500 亿美金了,但是,现在思科的市值是 2000 亿美金,而亚马逊的市值已经达到了 2 万亿美金,是思科的十倍。因此,硬件投入、 infra 建设,还是需要时间的。应用与收入是后半程才能体现出效果是否更好的两个因素。

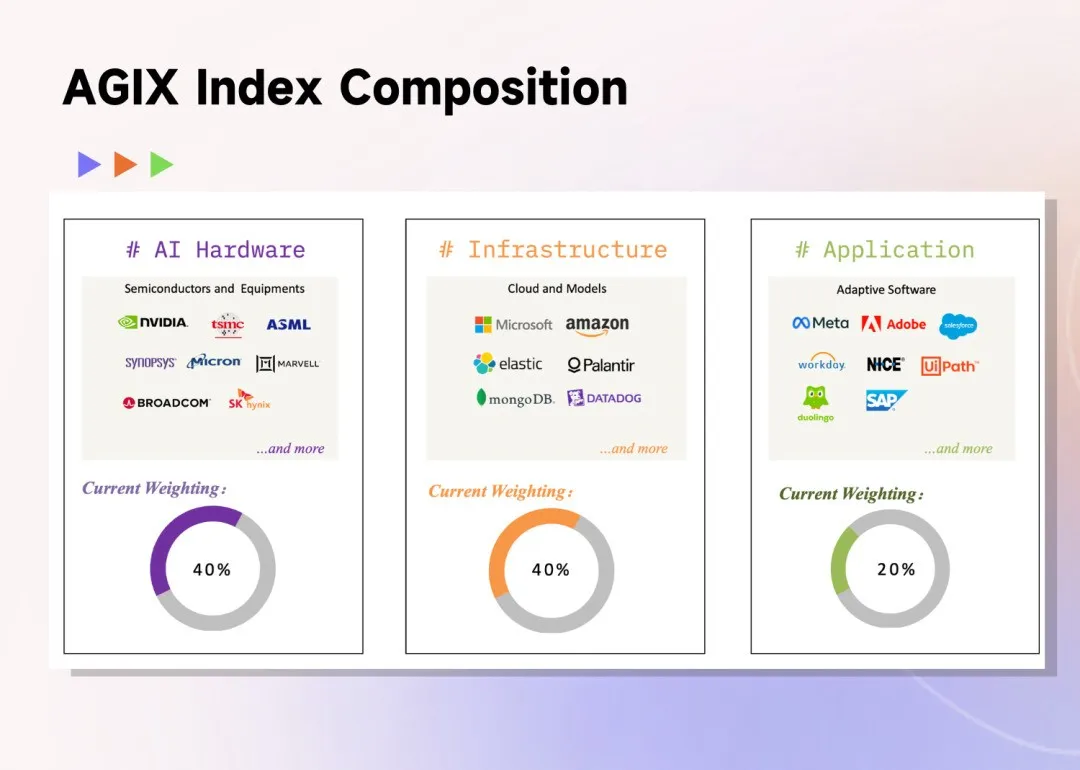

我们前段时间做了一个追踪 AGI 的指数,代号叫 AGIX ,这个指数反映了不同阶段公司的变化。这个指数内, 40% 的权重是硬件公司,尤其是半导体产业。另外 40% 是 infra 的公司,剩余 20% 是应用的公司。随着 AI 建设的发展,后面的权重比例会增加。比如, ServiceNow、Palantir 这些公司,在应用上的进步很快。

张小珺:2024 年第三季度, AI 领域还有哪些非共识叙事?

Guangmi Li:第一,可能开源模型、小模型,在很多特定高价值任务上表现并没有那么好。比如, Perplexity 的同一用户,使用不同模型问同一个问题,得到的答案差异很大。因为,产品探索时期,一个大的模型和小的模型对结果、用户体验的影响都是很大的。在很多复杂任务上,问题的解答率会比较低。最后用户还是会回到 GPT-4o 和 Claude-3.5 上。

第二,很多 AI 公司不是商业公司,本质上还是一个研究组织。在美国,这是一个常态。比如贝尔实验室就是 AT&T 支持的一个实验室,巨头以投资的形式支持实验室的发展,实验室的研究成果再给回到巨头做更好的商业化。这种模式很好,因为巨头内部的文化、人才都做不出来出色的研究,而实验室有自己好的研究文化。此外,巨头投资出去的钱不算亏损,如果实验室出现巨额的亏损,巨头也不用并表。可能这种模式是一个常态,公司保持实验室的模式就足够了,人们也不指望它能够有真正大规模的商业爆发。

第三,可解释性的研究上,如果真正突破,对后面如何设计新的模型是有很大帮助的。今天,模型参数很大,但真的每次 query ,激活的参数是很小的。如果把其它参数砍掉是没问题的。这就像是人类的脑科学研究,大脑也是分区的,最后真正研究清楚模型的可解释性机理也是很有意思的一件事。

最后,很多人预期多模态,但多模态是否能真正带来智能、有没有 scaling law ,这都是不好说的。代码是否有 scailing law 也不好说。我相信都是有的,包括刚刚提到,数学和代码是否可以泛化到很多领域上?后面的追赶者相比领先者的结局是怎么样的?历史上有很多追赶者,但是结局都是不太好的。虽然,头部公司可能会遇到一些路线、范式上的变化,但是,追赶者真的能够追上或反超,这是不好说的。

张小珺: Character.ai 之后,还有哪些 AI 公司还有被收购的可能?

Guangmi Li: 也许 Perplexity 可能会被收购,Amazon、 Meta 、Apple 都有收购它的可能。因为每一家科技巨头都有一个做搜索的梦想。

Perplexity 通过搜索产生的意图数据是有很大价值的,可以让平台公司更深入了解用户需求,提升广告、服务的匹配度。其次,搜索的整体技术栈是最前沿的,可以反向带动整个平台在技术栈上的升级。比如,微软有了必应后,才能在做 Azure 时具有优势。

Mistral 也可能会被收购。Mistral 并不是做不下去了,反倒做得不错。但是,它不一定有能力进入下一轮新赛场,所以,值得一个巨头去收购它。

张小珺: 2000 年互联网泡沫破裂后,只留下了 Amazon。如果未来 AI 的泡沫破灭了,谁会是下一个 Amazon?

Guangmi Li:硬件公司是很值得关注的,尤其是 Apple 和 Tesla。

iPhone 是值得继续好好研究的,虽然苹果的 AI 能力不是最强的,但未来的 killer app ,大概率还是长在手机上的,所以苹果还是一个无形的受益者。

Tesla 的意义在于它长期会从一家卖车的公司变成了一家真正的 AI 公司,整体交通行业变化很大。特斯拉也是一家机器人公司。但今天的自动驾驶,还是受限于端侧算力有限。

张小珺:在 AI 的大浪潮变化下,你对一级、二级市场有什么预测?

Guangmi Li:今天看, AI 并不是颠覆了老公司,很大程度上是重构了一批老公司。其实, AI 提升了生产力,但并没有改变生产关系。AI 改变了生产环节,但分发和消费环节都还留存在成熟的老公司内。由于掌握了生产关系、生产环境,因此老公司还是受益的。

我们内部经常举两个例子:

第一, Adobe 在上云之前,就是一家几十亿美金估值的传统软件公司。转云后, Adobe 的商业模式变好了,市场规模也变大了,成为了一家 2000-3000 亿美金的公司。

第二,中国的海康威视先前就是一家卖摄像头的硬件公司,但经历上一轮计算机视觉的变革后,商业模式变得更好,规模也变大了,增速、 PE multiple 都变好了。这一波 AI 也会有类似的故事,只是这个大幕还没有开始。AGI 的第一幕还是科技巨头受益,第二幕下,会有更多几百亿美金的公司,因为 AI 改变了商业模式、发生了规模上的变化。

也因为这样的观察,我们内部推出了一个二级市场追踪 AI 的指数:AGIX ,可以更好的追踪成熟公司,也可以更好理解它们。我们希望 AGIX 可以成为 AI 领域的 QQQ ,或是一个长期收益可以超过 QQQ 的指数,AGIX 也是一个 AI-native 的产品。

暂无评论内容