谷歌开源了一款名叫RB-Modulation的全新风格转换模型,这项技术在AI图像处理领域引起了广泛关注。从目前的演示效果来看,RB-Modulation不仅可以轻松实现图像风格的转换,还在多个技术层面实现了重要突破。无需训练即可自定义风格:这个模型不需要额外的训练,就能让用户自由控制图像的风格和内容。高保真度:生成的图像高度忠实于参考风格,不会丢失原有信息。强大的风格描述能力:通过风格描述符提取和编码图像中的关键属性,确保风格表达精准。高度适应性:模型能够处理各种输入提示,生成多种不同风格的图像,灵活应对不同需求。RB-Modulation的最大优势是它的”无需训练”特性。也就是说,用户不需要再进行额外的模型训练,就可以轻松定制出高质量的图像风格。这款模型还能够直接兼容SDXL和FLUX等主流的图像生成模型,进一步提升了其实用性和兼容性,使用起来更加方便。

01 技术原理—

现有的无需训练的技术通常会遇到以下几个难题:(a) 没有额外的文字描述时,难以从参考图片中准确提取风格;(b) 参考图片中的不必要内容可能会泄露到生成的图像中;(c) 风格和内容难以有效结合。

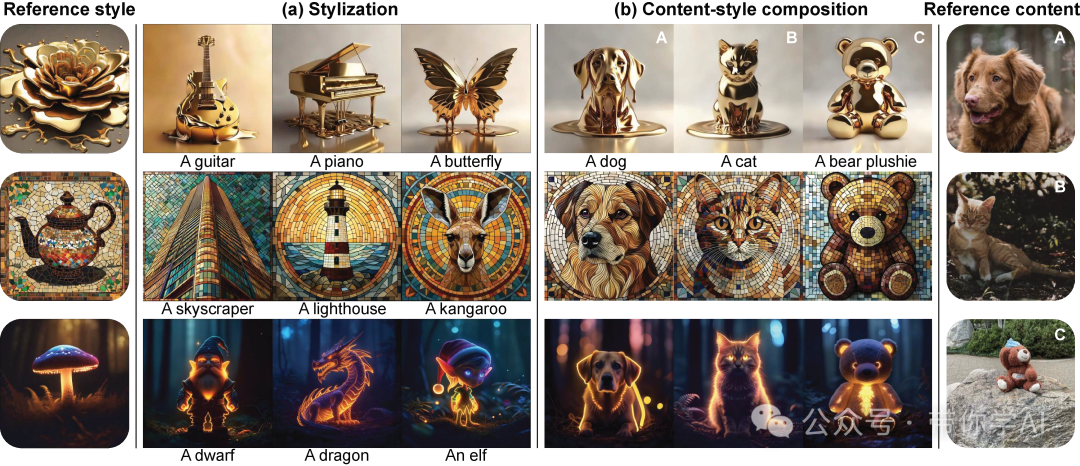

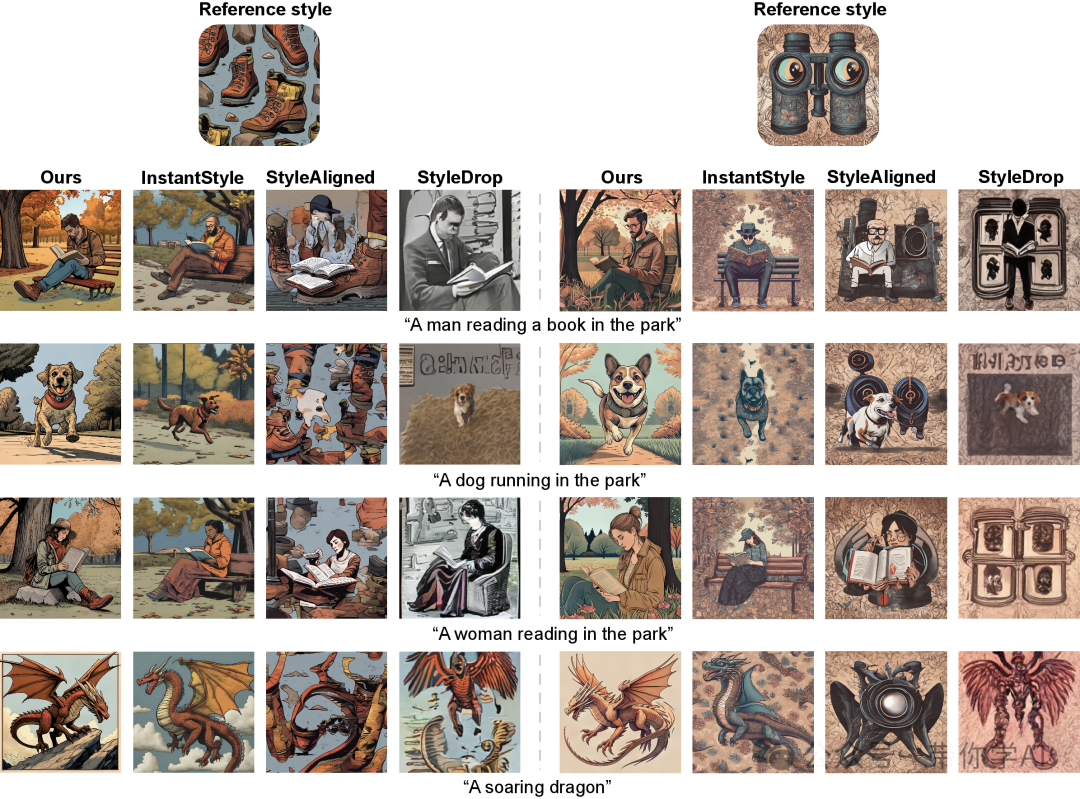

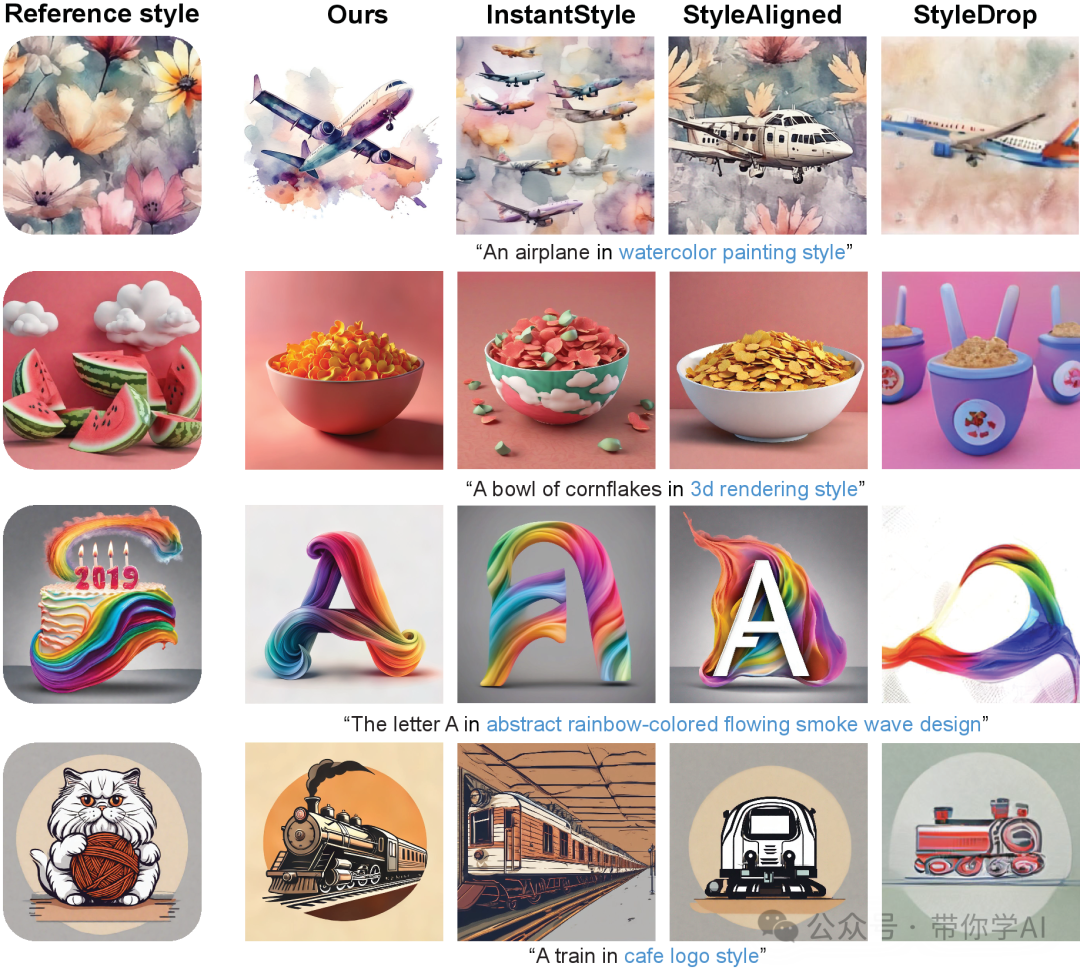

RB-Modulation基于一种创新的随机最优控制器,其中风格描述符通过终端成本来编码所需的图像属性。这个方法不仅解决了上述难题,还确保生成的图像高度还原参考风格,并准确匹配给定的文本提示。还引入了一种基于跨注意力的特征聚合方案,使得RB-Modulation能够从参考图片中分离出风格和内容。重点是可以摆脱了对外部适配器或ControlNets的依赖。02 实际效果在第一行中,StyleAligned 和 StyleDrop 会将风格参考图中的智能手机误生成类似的酒瓶和书。而在最后一行,StyleAligned 不仅泄露了参考图中的房屋和背景信息,InstantStyle 还出现了颜色泄露问题,导致生成的图像颜色与房屋相似。而RB-Modulation的方法则能够准确地按照提示,在所需风格下生成图像,没有这些问题。

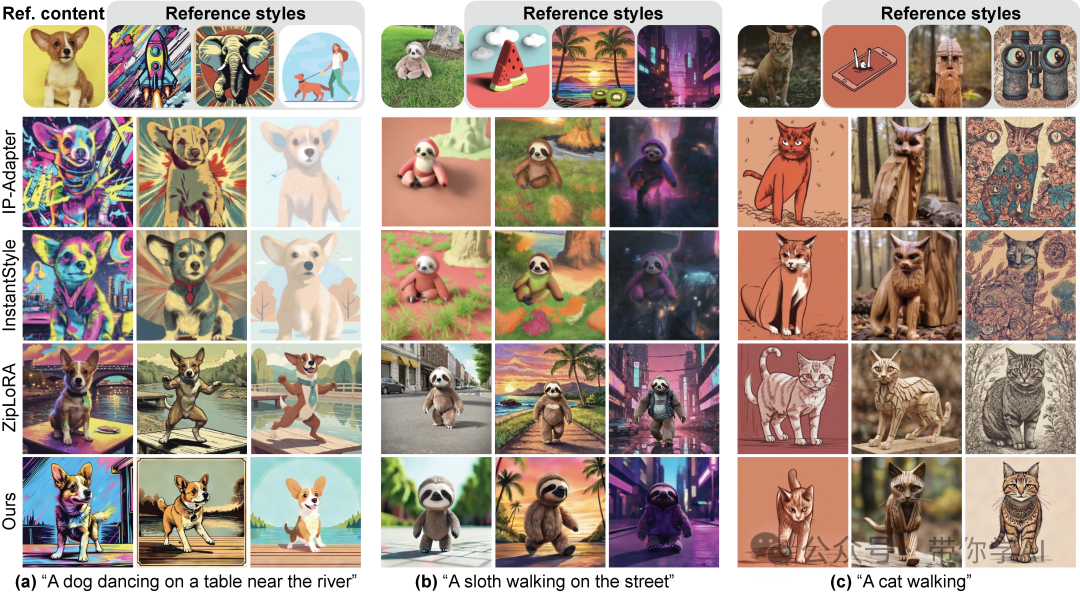

在无需训练的方法中,InstantStyle 和 IP-Adapter 依赖于 ControlNet ,这通常限制了它们在生成图像时准确跟随提示,比如在示例 (b) 中生成“跳舞”或在示例 (c) 中生成“行走”的姿势。相比之下,RB-Modulation方法不需要依赖 ControlNet 或其他适配器,能够有效捕捉参考图片中的独特风格和内容,同时准确按照提示生成多样化的图像。

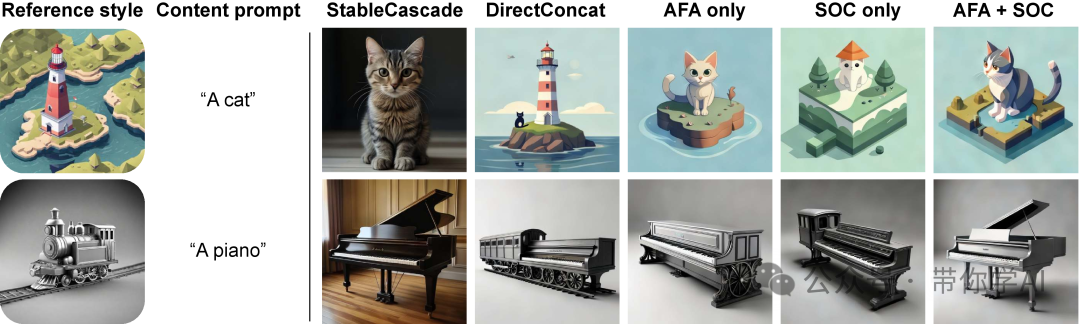

以 StableCascade作为基础模型,逐步加入各个模块,没有包含风格描述部分,展示它们的效果。DirectConcat 方式是将参考图像的嵌入与文本提示的嵌入进行拼接。

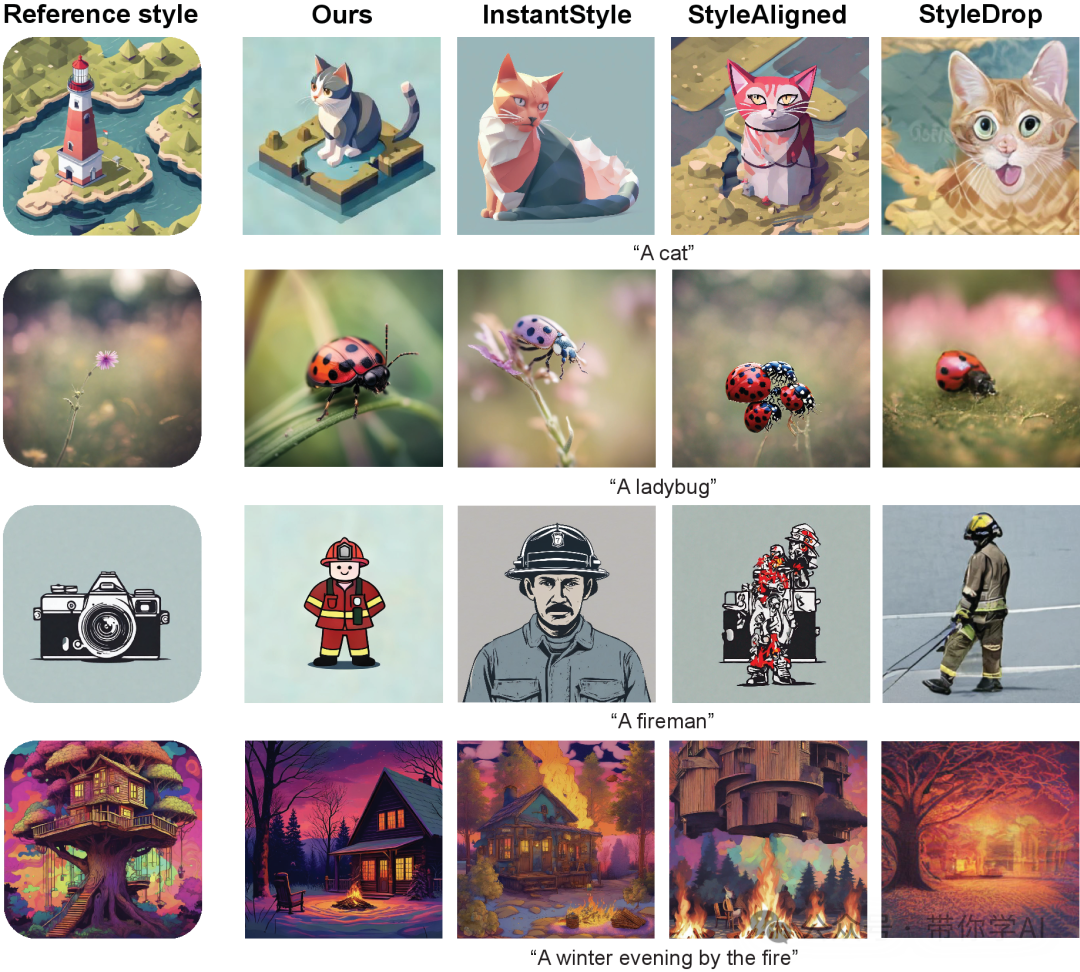

在没有风格描述的情况下,RB-Modulation方法仍能生成更加多样化的图像,同时准确遵循提示并很好地捕捉参考图像的风格。相比之下,InstantStyle 生成的画面较为单一,StyleAligned 则有严重的信息泄露问题。

其他方法在生成图像时会遇到一些问题,比如难以准确跟随提示(例如生成了多架飞机而不是一架),以及信息泄露(比如玉米片碗上出现了云朵,或者奶昔图像中出现了吉他)。相比之下,RB-Modulation方法在遵循提示和风格匹配方面表现出色。风格描述部分用蓝色标注。

在去除风格描述后,StyleAligned 和 StyleDrop 的表现大幅下降(比如生成了消防员和猫的图像效果变差)。InstantStyle 的结果则显示出更多的信息泄露问题(例如出现了粉色瓢虫和豹子),而RB-Modulation则没有明显的性能下降。

暂无评论内容