华盛顿大学和谷歌DeepMind 开发了一种新开源方法GI-KI(生成中间帧插值) ,可以在两张给定的关键画面之间生成流畅连续的视频。他们改进了一个预先训练过的AI模型,原本这个模型是用来从一张图片生成视频的。通过小范围的调整,让这个模型可以生成反向播放的视频。接着,同时用两个模型:一个负责向前生成视频,一个负责向后生成视频来进行双向处理,并把两者的结果合并在一起。GI-KI 方法通过调整预训练的图像转视频扩散模型,以一对关键帧为输入,生成一个动作连贯的中间过渡视频。当然该方法有一些局限,主要是因为稳定视频扩散模型(SVD)生成的运动质量有点问题。SVD模型通常根据输入的图像有很强的固定运动倾向,只会生成某些特定的运动,这样的话,它可能无法生成两个关键帧之间真正需要的运动,使得做出自然的过渡视频变得不太容易。

解决卡顿问题,生成视频新方法!将图像生成模型用于关键帧插值

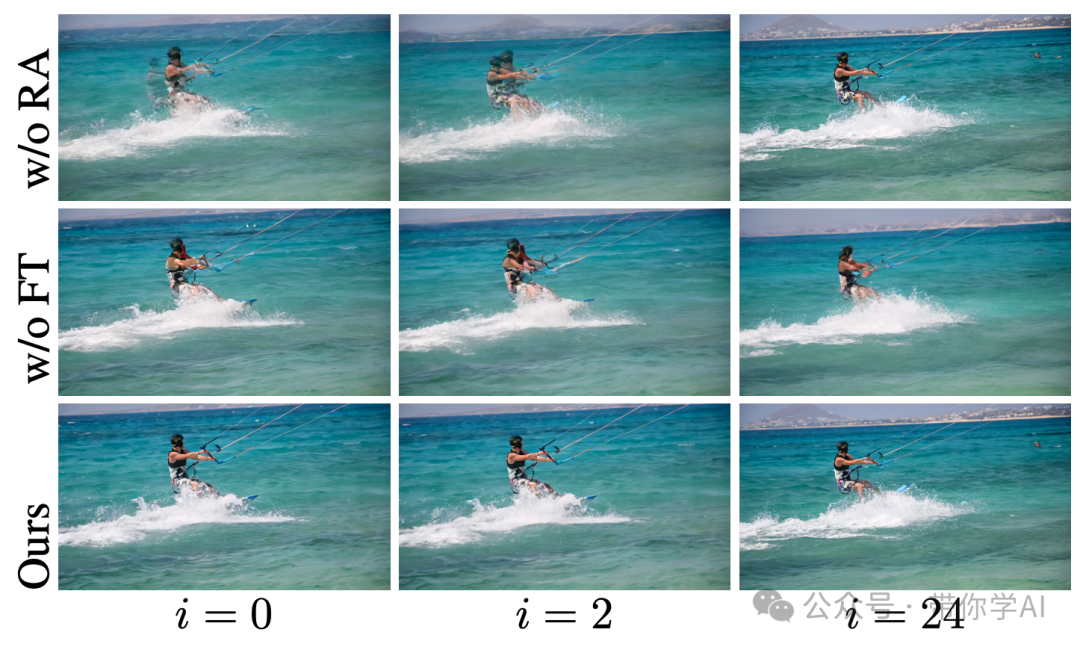

01 技术原理—1. 前向运动预测:首先,用第一个输入图像(或者视频的第一帧)加上噪声信息,输入预训练好的3D UNet模型,生成噪声预测和时间相关的注意力图。2. 反向运动预测:然后,把噪声数据在时间线上反转,用第二个输入图像(或者视频的最后一帧)作为条件,再加上旋转了180度的注意力图,通过3D UNet模型预测反向运动。3. 融合和更新:最后,把反向运动的噪声再次反转,跟前向运动的噪声融合,生成一个连贯的运动路径。需要注意的是,在时间相关的注意力图中,只有部分矩阵经过了微调。  同时进行消融研究,测试了生成过渡运动一致性的其他方法:

同时进行消融研究,测试了生成过渡运动一致性的其他方法:

- GI-KI 的方案(不使用RA):完整流程中,虽然微调了时间注意力层的所有参数,但没有使用旋转180度的时间自注意力图作为额外输入。

- GI-KI 的方案(不使用FT):完整流程中,没有对反向运动进行微调。

02 实际示例主要将GI-KI 的方法和当前顶尖的大动作帧插值技术FILM以及同样使用SVD技术的TRF进行对比。同时,还对比了最近的DynamiCrafter的结果,它是一个大型图像转视频模型,具有关键帧插值功能,专门训练以处理两个结束帧。GI-KI方法则侧重于如何用更少的训练视频和计算资源,轻量化地调整预训练的图像转视频模型。

02 实际示例主要将GI-KI 的方法和当前顶尖的大动作帧插值技术FILM以及同样使用SVD技术的TRF进行对比。同时,还对比了最近的DynamiCrafter的结果,它是一个大型图像转视频模型,具有关键帧插值功能,专门训练以处理两个结束帧。GI-KI方法则侧重于如何用更少的训练视频和计算资源,轻量化地调整预训练的图像转视频模型。

GI-KI 办法在生成关节运动的过渡效果上比FILM和TRF更好,但在创造自然运动方面仍有挑战,因为SVD本身在生成复杂运动时有限制。要注意的是,输入图像用于指导SVD,所以如果SVD不能很好地从这个输入图像生成合理的视频,生成的第一帧可能会与输入图像有些差异。

暂无评论内容