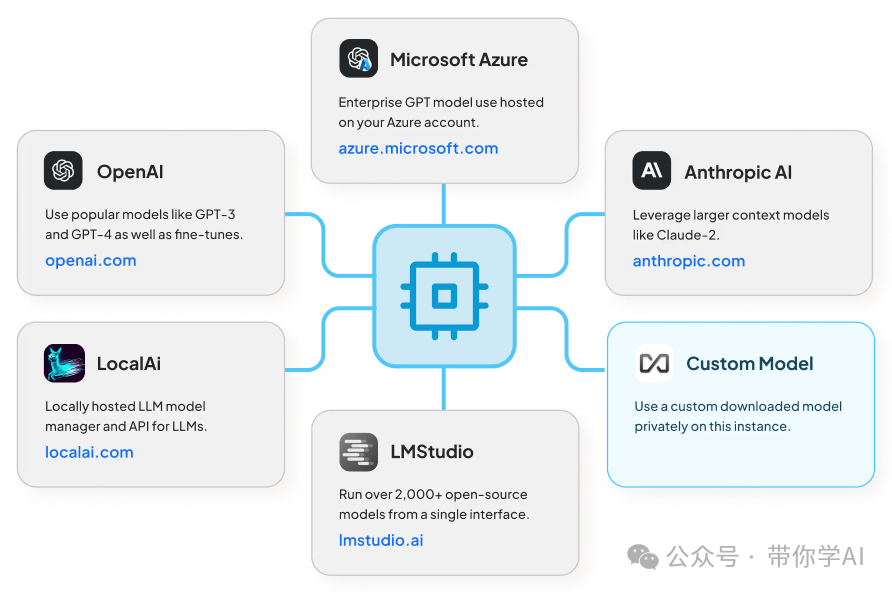

AnythingLLM 是一个全功能的 AI 应用程序,你可以使用商用大语言模型或流行的开源模型,结合向量数据库,打造属于自己的私人版 ChatGPT,不再依赖第三方。你可以选择在本地运行或远程托管,并且它可以与任何你提供的文档进行智能对话,你还可以进行套壳从而赚取费用。

它通过创建“工作区”来组织你的文档,类似于一个个独立的对话线程。每个工作区是一个独立的环境,文档可以在工作区内共享,但不同工作区之间不会相互干扰,这样每个工作区的上下文都能保持清晰。AnythingLLM支持几乎所有的主流大模型和多种文档类型,可定制化,而且安装和设置简单。目前适用于MacOS、Linux和Windows操作系统,也可以使用Docker安装,并且完全免费使用。

牛爆了!你的私人大模型全栈应用,开源神器 AnythingLLM迎来重大更新

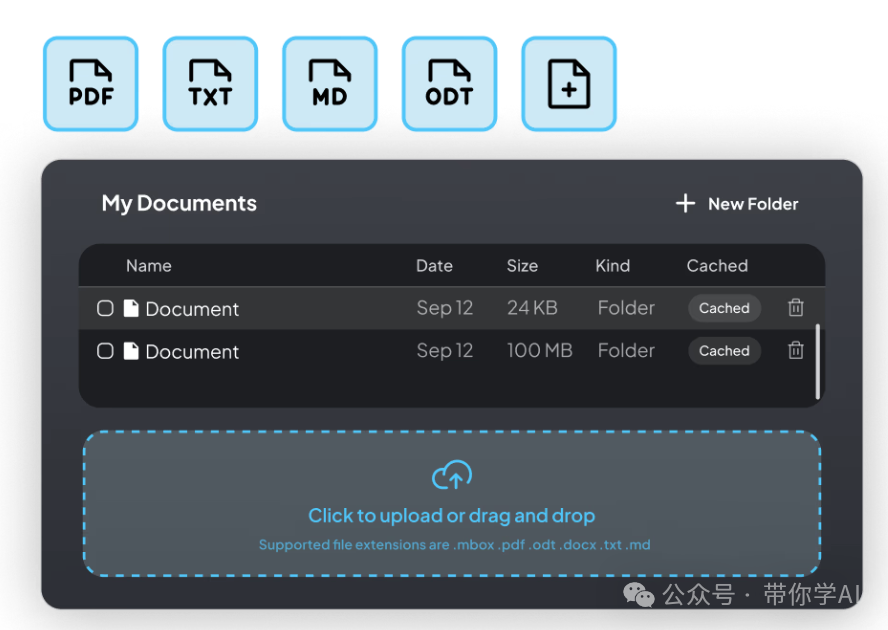

01 功能亮点—AnythingLLM 的亮点包括:支持多用户和权限管理;工作区内有智能代理,可以浏览网页、执行代码等任务;支持嵌入网站的定制聊天窗口;兼容多种文档格式(PDF、TXT、DOCX 等);通过简单的界面管理文档和向量数据库;提供聊天模式(保留对话记录)和查询模式(针对文档快速问答);  聊天中引用相应的文档内容,提供精准回答;完全支持云部署;支持本地部署LLM 模型;在处理大型文档时高效省资源,只需一次嵌入,成本比其他解决方案节省 90%;提供全套开发者 API,方便自定义集成。

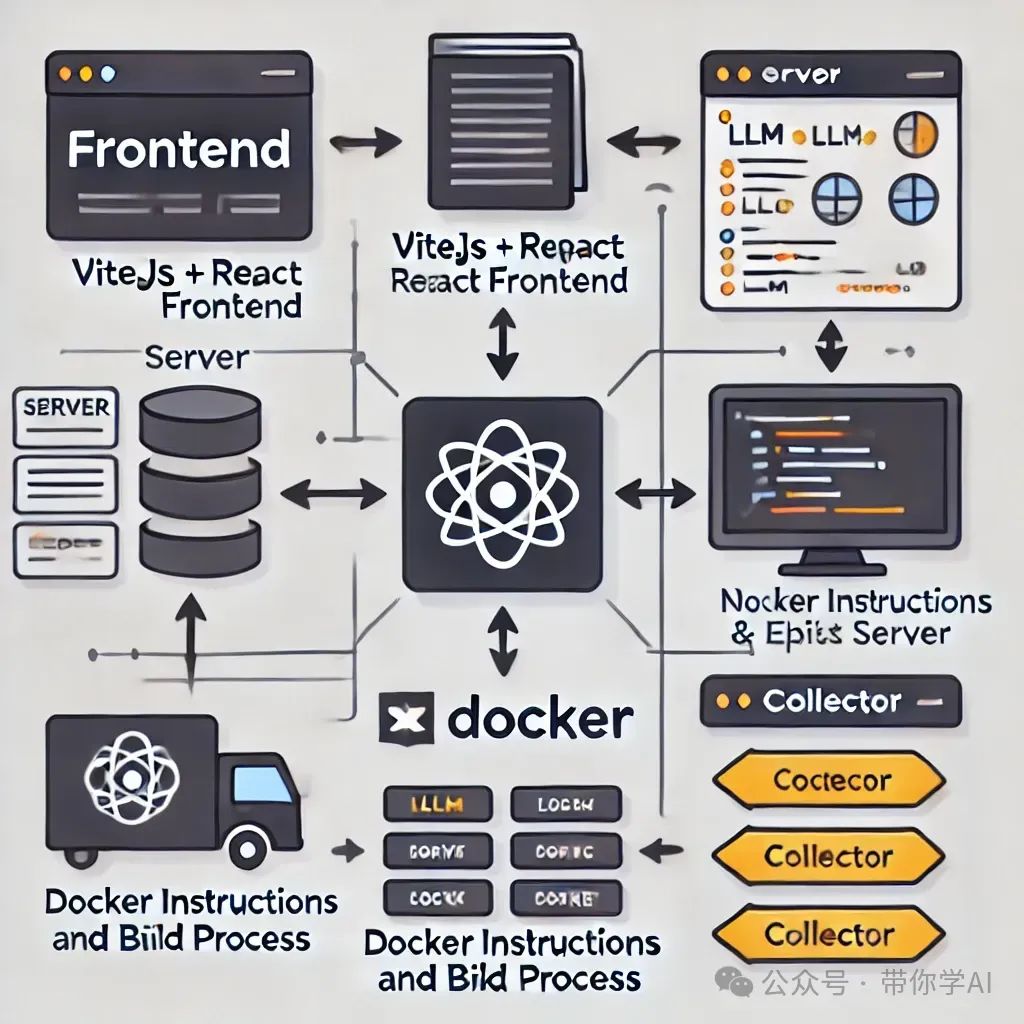

聊天中引用相应的文档内容,提供精准回答;完全支持云部署;支持本地部署LLM 模型;在处理大型文档时高效省资源,只需一次嵌入,成本比其他解决方案节省 90%;提供全套开发者 API,方便自定义集成。  02 技术原理前端(frontend):这是一个基于 ViteJS 和 React 的前端,帮助你轻松创建和管理 LLM 使用的所有内容。服务器(server):这是一个 NodeJS Express 服务器,负责处理各种交互,支持数据库管理以及与 LLM 的连接。Docker:提供 Docker 指令和构建步骤,帮助你从源代码进行构建。文档解析器(collector):这是一个 NodeJS Express 服务器,用于从界面接收和解析文档。

02 技术原理前端(frontend):这是一个基于 ViteJS 和 React 的前端,帮助你轻松创建和管理 LLM 使用的所有内容。服务器(server):这是一个 NodeJS Express 服务器,负责处理各种交互,支持数据库管理以及与 LLM 的连接。Docker:提供 Docker 指令和构建步骤,帮助你从源代码进行构建。文档解析器(collector):这是一个 NodeJS Express 服务器,用于从界面接收和解析文档。  AnythingLLM可以基于GitHub源码进行二创,支持本地Ollma部署模型。使用 Ollama 和 AnythingLLM 的主要优势是数据隐私和安全。Ollama 本地运行 LLM,确保敏感信息不离开用户设备,减少云端泄露的风险。03 部署使用

AnythingLLM可以基于GitHub源码进行二创,支持本地Ollma部署模型。使用 Ollama 和 AnythingLLM 的主要优势是数据隐私和安全。Ollama 本地运行 LLM,确保敏感信息不离开用户设备,减少云端泄露的风险。03 部署使用

- 访问AnythingLLM网站下载适合您的操作系统版本并按照提示完成安装。

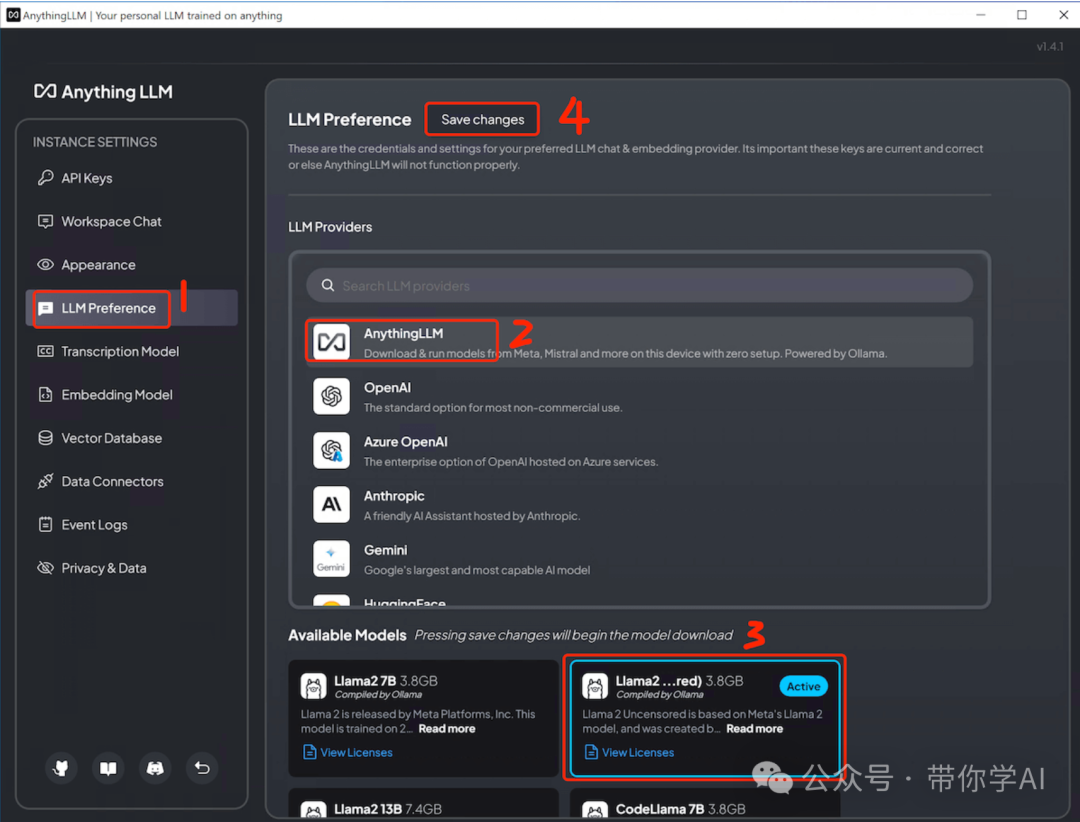

- 配置LLM,支持Ollama本地部署自己的模型。

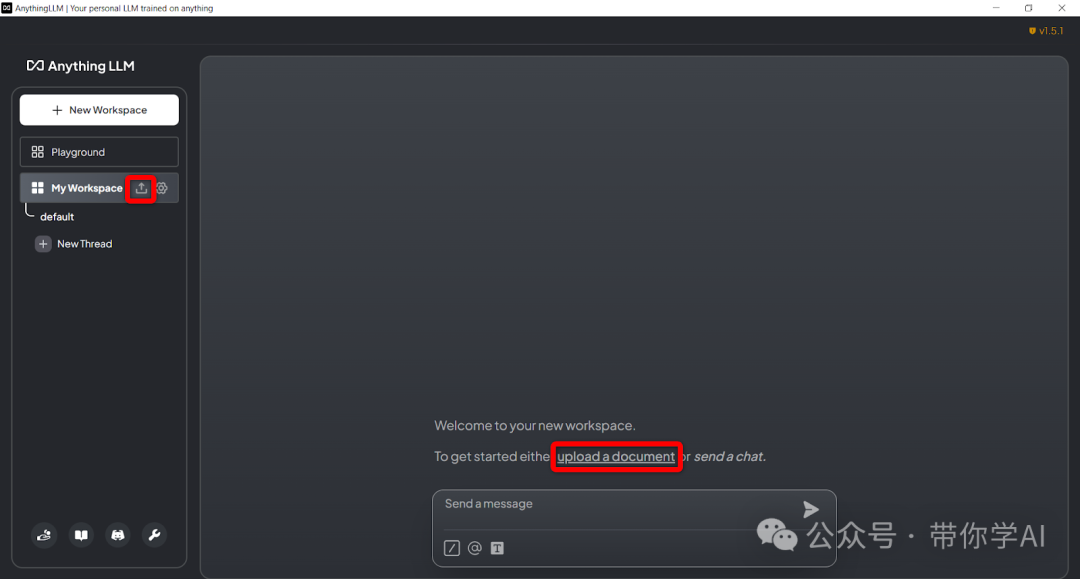

- 上传自己的知识库文档,可以进行开启对话问答。

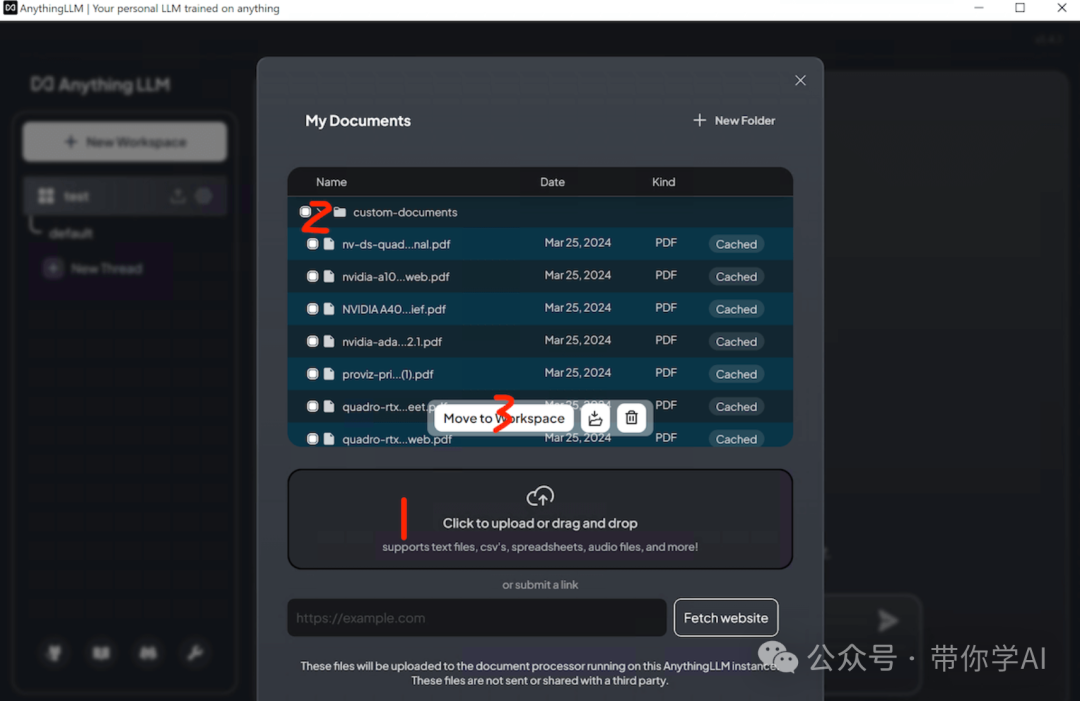

- 将文档拖放或从本地上传后,选择所需文件并点击“移至工作区”。

- 返回主界面,在底部输入消息即可开始与文档的聊天。

暂无评论内容