为了方便开发者迁移

国内的很多大模型

都做了 OpenAI SDK 兼容

但不幸的是…

目前,还没见到哪家把做对

包括不仅限于

百川/月之暗面/通义千问/智谱/…

很悲哀…

这篇文章不是挑刺

而是公开的问题反馈

毕竟,如果真的做 agent 开发

应该在第一天就遇到了这些问题

这里以如下请求为例

(老版本的 function 调用)

from google.colab import userdatafrom openai import OpenAI

def LLM(model_version=’gpt-3.5-turbo’, client = object): messages = [ {“role”: “system”, “content”: “我是一个天气预报机器人”}, {“role”: “assistant”, “content”: “我有什么可以帮你的?”}, {“role”: “function”, “name”: “local_temperature”, “content”: “当前室外温度 27 度”}, {“role”: “user”, “content”: “现在多少度了?”} ] api_params = { “model”: model_version, “messages”: messages, }

return client.chat.completions.create(**api_params)

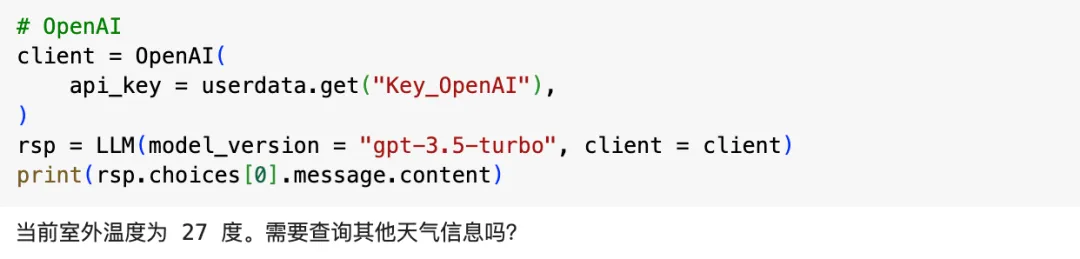

如果是 OpenAI API

可以正常返回

接下来是各厂测试

大致按模型首字母排序

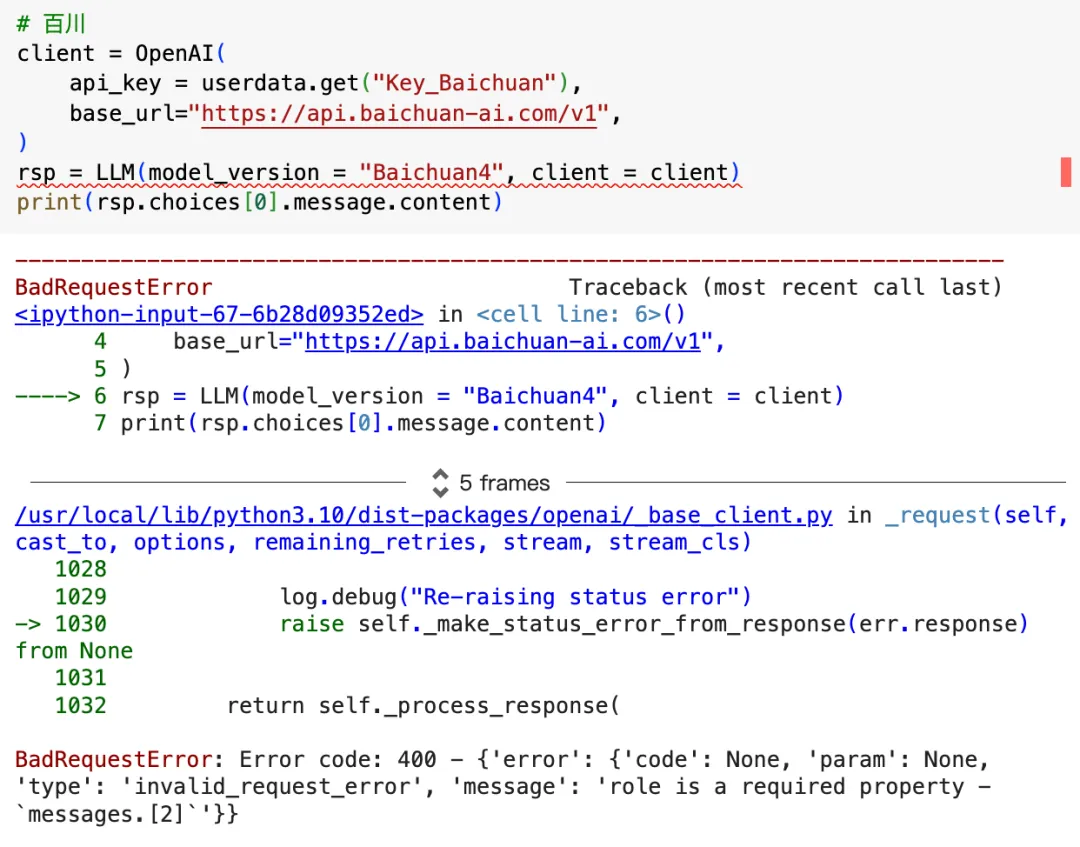

Baichuan4 / 百川

![]()

测试结果:报错

报错原因:不支持 Role 为 Function

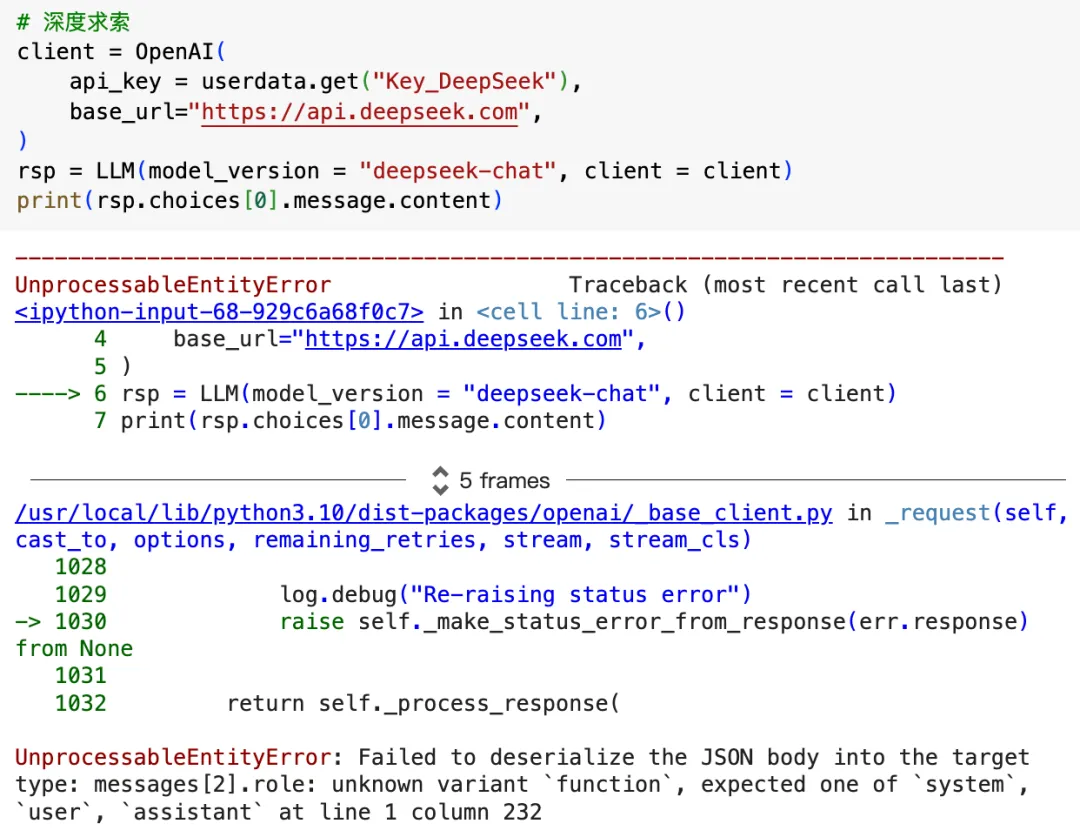

deepseek-chat / 深度求索

![]()

测试结果:报错

报错原因:不支持 Role 为 Function

glm-4-flash / 智谱

![]()

测试结果:报错

报错原因:不支持 Role 为 Function

moonshot-v1-8k / 月之暗面

![]()

测试结果:报错

报错原因:不支持 Role 为 Function

qwen-max / 通义千问

![]()

测试结果:报错

报错原因:不支持 Role 为 Function

ERNIE / 文心一言

![]()

测试结果:开不起服务

报错原因:穷

结论

![]()

其实 问题远不止这些

每家都一大堆问题

希望下次我测的时候可以更好吧

暂无评论内容