中西方共同意识到未对齐的超级智能所带来的威胁,可能是中美关系中最好的事情。

6月15日,在2024年北京智源大会上,麻省理工学院(MIT)教授,当代人工智能领域重要的思想家之一麦克斯·泰格马克(Max Tegmark),和加州大学伯克利分校教授斯图尔特·罗素(Stuart Russell),分别面向中国观众阐释了他们对AI安全的理解。

罗素最为人知的身份,是人工智能领域必读教科书《人工智能:现代方法》的作者。作为开场嘉宾之一,他也为AI安全议题提供了教科书般的拆解。穿着蓝色外套的他看起来足够冷静、严肃,对各种事例和比喻信手拈来。

而身着牛仔裤、皮夹克和自制图案T恤的泰格马克,看起来更像是一位老牌摇滚明星。

泰格马克是MIT的物理学教授,同时也涉足人工智能研究。他还是畅销书《生命3.0》的作者。上一次登上全球媒体头条时,泰格马克以未来生命研究所创始人的名义发表了著名的公开信,在2023年3月的时候呼吁暂停研发AI模型至少六个月,吸引来上千名AI行业专家共同签署。

尽管总是走在呼吁重视AI安全的路上,泰格马克却不完全是一位悲观主义者。最新的演讲里,泰格马克一方面强调AI进步之快远超所有专家的预期,一边又拿出几篇最新的论文,笑着安慰大家说,没事,没事,我们有的是办法。

如果说还有什么让他很苦恼,那就是他非常了解中国对AI安全研究的进展并不落后于绝大多数国家,然而中国在这方面的国际认知与合作却迟迟无法推进。他期待中国能打造一个权威的AI安全研究机构,方便在国际合作中“知道要找谁”。

以下为「甲子光年」从北京智源大会现场发回的演讲要点,经过独家编辑和整理。

1.人工智能必将成为航空和核能

![]()

罗素首先指出,人工智能系统不会一直保持现状,它们的能力会不断提高。最终会远远超过人类的能力。“这不是科幻小说中的遥远未来,这比很多人警告要发生的气候变化影响还要早。”

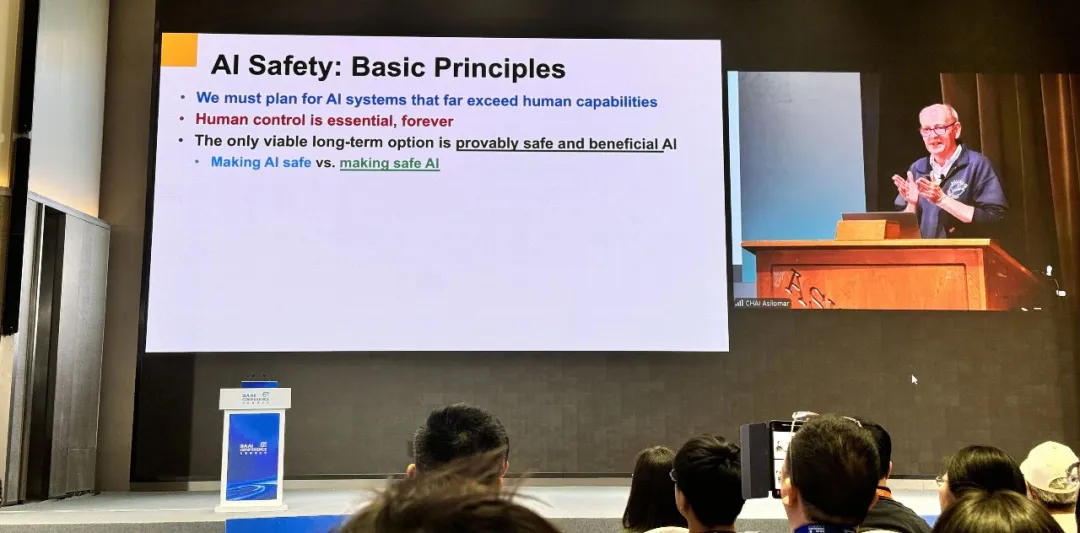

同时罗素澄清了一个观点:我们应该思考的不是如何让人工智能变得安全。他提到OpenAI首席执行官萨姆·奥尔特曼表示会研究如何创建AGI并保证它的安全,研究它的用途。这说反了——一旦制造出 AGI,就没有另一个十年的时间来研究如何让它变得安全。

甲子光年拍摄

“我们应该停止谈论让人工智能变得安全,因为这是在假设人工智能是从外太空降落的,它比我们优越,现在我们要弄清楚如何让它对人类是安全的。这不是一个可行的方向。不可避免地,人工智能将变得更像航空和核能。”

罗素引用自己在伯克利的核工程专业同事爱德华·莫尔斯(Edward Morse)的观察说,核电站的重量与认证安全所需文件的重量成线性关系——每 1 公斤核电站大约需要 7 公斤文件。如果不这样做,切尔诺贝利核事故就会再次发生。

大约十年前,罗素开始发现AI的研发方式存在问题。他提出:“我们应该考虑建立一种新的人类与机器之间的契约。机器的唯一责任是促进人类的利益,同时机器需要认识到它并不知道这些利益具体是什么。这个框架的优点在于,不管人类的实际利益是什么,如果机器解决了这个难题,我们就会对结果感到满意。”

另一个底层逻辑是,让人们相信人工智能系统在回答问题时,其答案包含在经过认证的事实的底层数据库中。这似乎很简单,但仍然没有真正的指引。罗素提到了中国国家网信办2023年4月发布的《生成式人工智能服务管理办法(征求意见稿)》,其中提到,利用生成式人工智能生成的内容应当真实准确,采取措施防止生成虚假信息。

“这听起来非常合理。但据我所知,业界在抱怨这对他们来说太难实现了,因为大语言模型的技术无法保证事实的准确性。我认为这还会持续,任何限制人工智能系统发展的合理法规都将受到强烈抵制。”所以罗素认为,人工智能安全需要一个国际组织。目前全球几十个机构都在研究AI安全,但它们之前没有足够的协调。

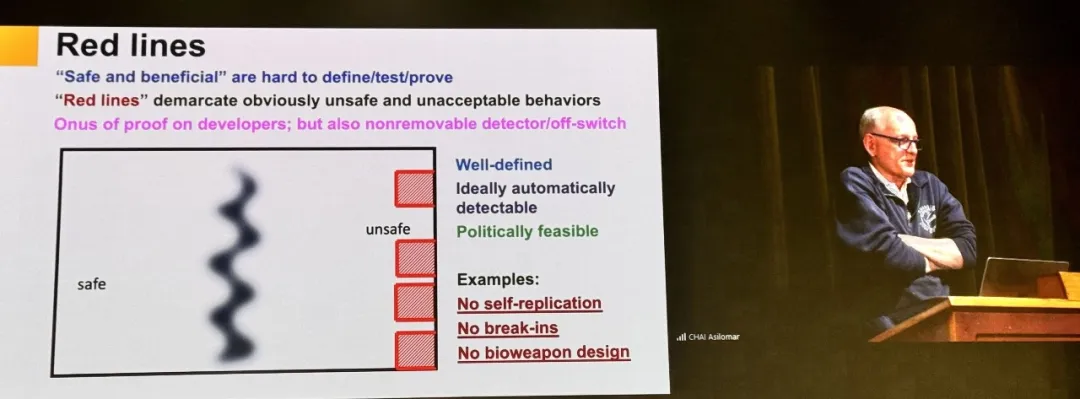

罗素还给出一个红线的概念:安全和不安全很难区分,不过可以划定明确的不安全行为和不可接受的行为,要求人工智能系统不要越过这些红线。比如人工智能系统不应该自我复制、不应该侵入其他计算机系统、它们也不应该帮助恐怖分子设计生物武器。

甲子光年拍摄

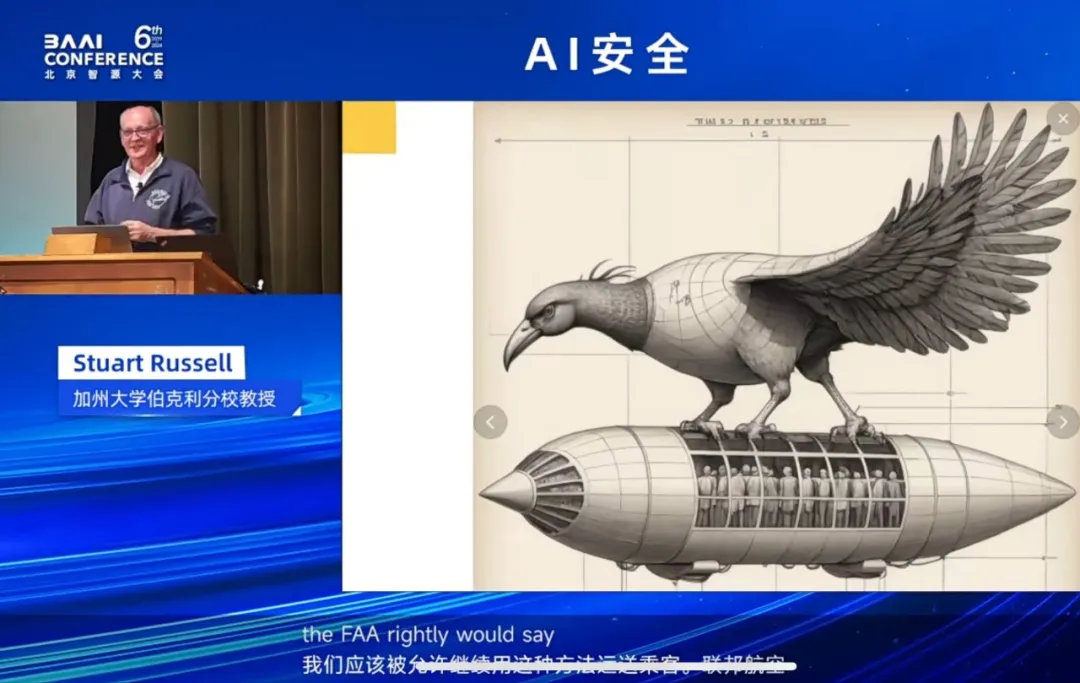

他又给出一个形象的比喻:这就好比1903年,航空业没有选择研发飞机,或者琢磨航空工程分析和机械系统分析。他们决定饲养越来越大的鸟类,因为有证据表明鸟类可以携带足够多的人类乘客。

然后他们把这份设计提交给联邦航空管理局要求获批。结果联邦航空管理局说,抱歉,这些鸟会在飞行途中吃掉乘客,随时把他们扔进海里,降落在任何它们想要降落的地方,所以我们不能认证。

但航空公司说:“我们花了这么多钱开发这些鸟,它们非常强大。我们应该被允许继续用这种方法运载乘客。” 结果联邦航空管理局还是说绝对不行。罗素表示:“我认为政府也应该对人工智能公司说同样的话。”

2.AGI并不遥远,但我们有办法

![]()

泰格马克首先抛出一个积极的判断:人工智能是一种帮助人类繁荣和过上更好生活的工具,而不是简单地使人类在经济上落后并最终取代我们的机器。所以如果我们能做到这一点,人工智能当然有巨大的潜力来改善我们的未来。

随后他介绍了机器人、AI画画,以及Deepfake等领域的飞速进展。“现在有些人认为大语言模型仍然比它们看起来要愚蠢得多,我认为这是错误的。这当然既为有趣的事情打开了机会,也为各种社会问题打开了机会。”

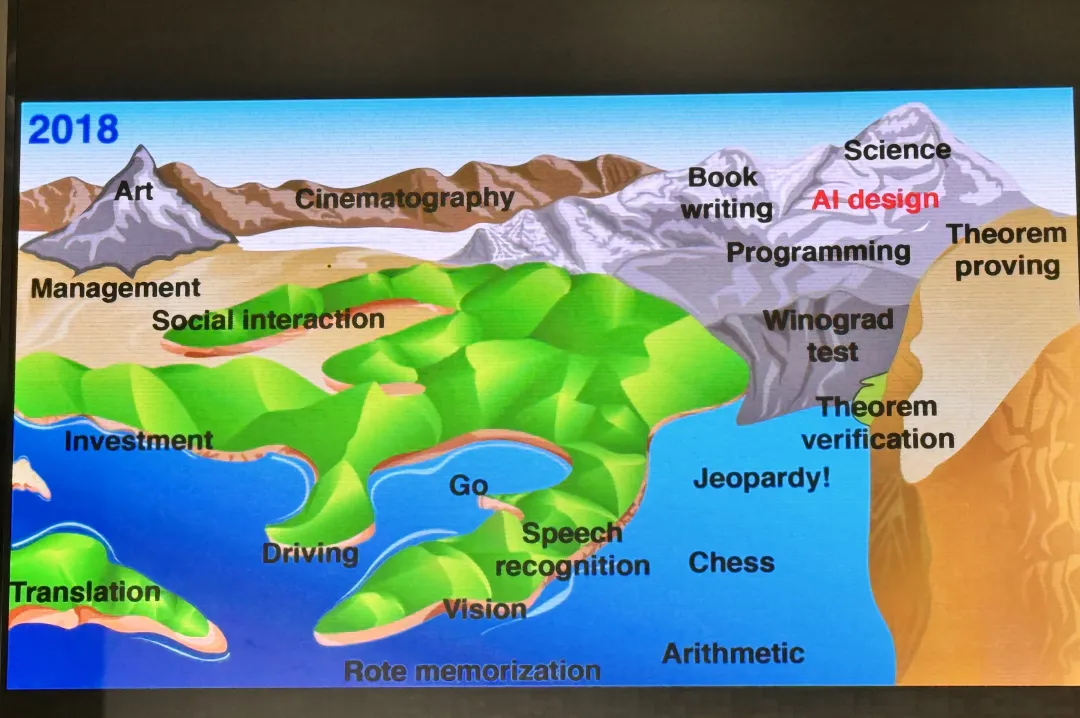

泰格马克的T恤上有一幅画,来自他六年前自己的创作。其中海拔代表机器在人类水平上完成每项任务的难度。随着人工智能的发展,水位上升,许多事物也被淹没,这件T 恤早已过时了。超级智能的出现意味着机器不再受到人类智慧的限制,而是受到物理定律的限制,就像人类超越蜗牛和蟑螂一样。

甲子光年拍摄

那么AGI什么时候会到来?泰格马克说,之前人们说还有几百年,5年前的时候AI同行说会在几十年内发生。但现在微软说这已经发生了。人们对何时能实现 AGI 的预测,已经从几十年后骤降到大约两年后。 Anthropic 的CEO达里奥·阿莫迪(Dario Amodei)甚至给出了具体数字称,我们距离它还有两三年的时间。

“所以我们必须保持谦逊,承认我们不知道需要多长时间。但我们显然必须停止将 AGI 作为一种长期的可能性来谈论。”

如果真正实现了AGI会发生什么?图灵说机器会迅速变得比我们聪明得多。这就是智能爆炸,默认的后果是机器控制一切。泰格马克指出,图灵这样说是因为他不认为人工智能只是另一种技术,就像电力或蒸汽机一样。他认为人工智能是一种新物种。

类似地,萨姆·奥尔特曼也说过,最糟糕的情况会让我们所有人都失望。达里奥·阿莫迪甚至给出了一个数字:“人类灭亡的可能性在 10% 到 25% 之间。”

甲子光年拍摄

但这绝对不是不可避免的,人类可以做得更好。泰格马克认为,最重要的是确保我们对人工智能的控制,使其成为人类为人类自己打造的东西。

对于Transformer架构,泰格马克的观点是:“它是能让我们做一些很新、很强大的东西的技术,但不会是最后一种。没有什么理由认为Transformer会是人工智能的最佳架构。新的架构还在不断出现,比如一些新型RNN架构等。”

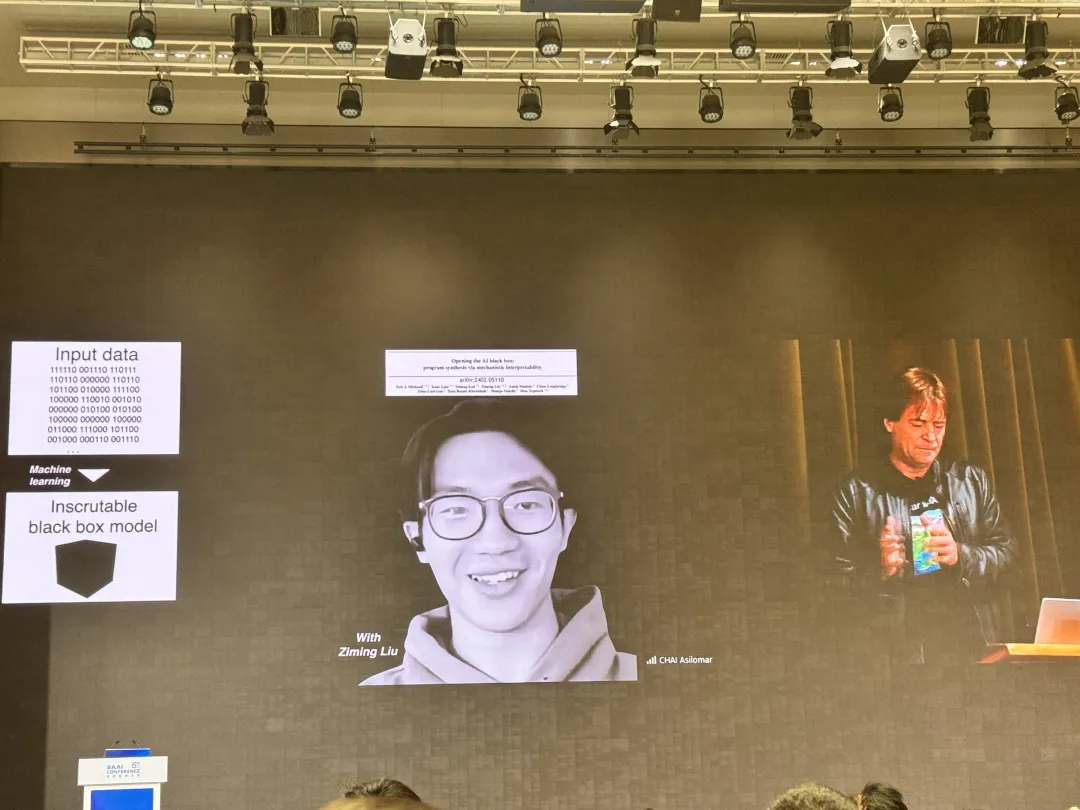

他提到了自己和中国博士生刘子铭共同发表的KAN(Kolmogorov-Arnold Networks)框架。这种架构颠覆了传统的多层感知机(MLP)架构,在参数量相同的情况下,在许多任务中获得了更高准确度。

泰格马克还表示:“我们还可以更好地理解我们今天所做的神经网络,而不是只是听天由命,说我们永远不会理解它们,它们的黑匣子什么的,忘掉这事吧。”

他的团队发表的另一篇论文证明,训练神经网络时,损失曲线会不断下降,并以一种非常平滑的方式变得越来越准确。所有不同的计算任务,由许多小部分组成,像马文·明斯基(Marvin Minsky)的《心智社会》中提到的那样。它们都能一个接一个地被学习,人类可以比想象中更容易地理解非常大的人工智能系统。

”业界让大语言模型更可信的主要方法是进行所谓的评估,努力让它做出一些坏事,然后尝试修复它,这就像编程时的调试一样。但调试只能证明问题的存在,而不能证明问题不存在。如果你面对的是可能造成巨大伤害的技术,你会想做得更好,你得让伤害不可能发生。这就是为什么我们要设置物理护栏,” 泰格马克说。

但如果面对的是超级智能或超级智能的对手,就需要更坚固的护栏。“我们需要一些在遵守物理定律的情况下不会造成伤害,绝对不会完成某些任务的东西,无论它有多智能。这就是斯图尔特(罗素)谈到的可证明的安全性。”

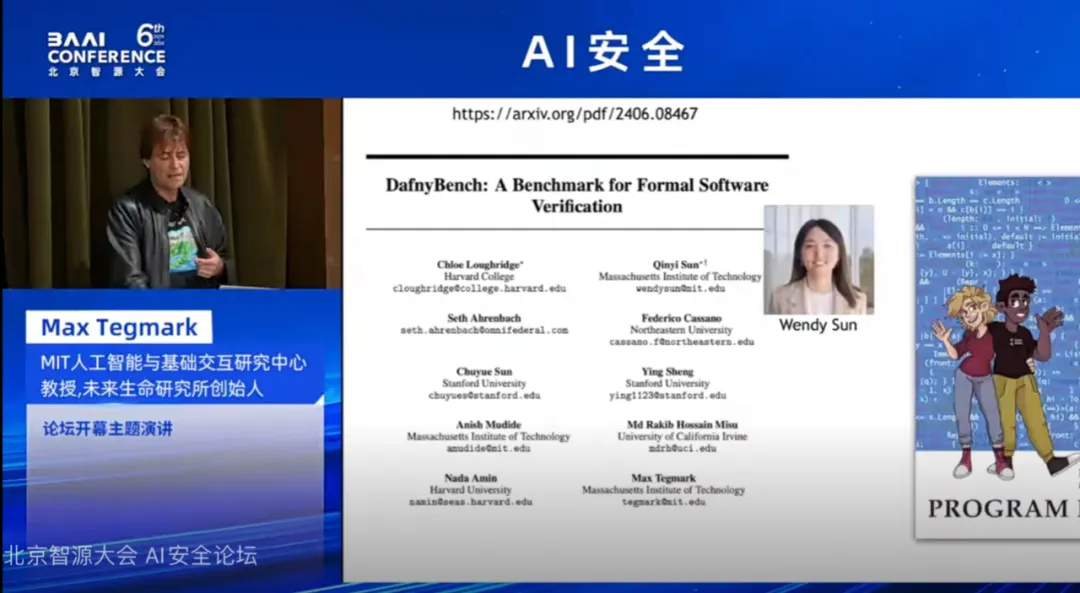

他又介绍了学生们完成了另一项成果:DafnyBeach。这是同类产品中最大的用于训练和评估用于正式软件验证的机器学习系统的基准。他们测试了GPT-4和Claude 3等模型自动生成足够提示的能力,使Dafny正式验证引擎能够成功验证750多个程序(约53000行代码)。最佳模型和提示方案展示出68%的成功率。

3.AI是否有主观体验不重要

![]()

在提问环节,北京智源人工智能研究院理事长黄铁军提问说,作为人类,我们有欲望,有意图和动机。如果一个系统是人工智能,那它就不是意识,但为什么人工智能系统试图控制人类呢?我们为什么会害怕这种人工神经网络呢?

泰格马克认为, 罗素教科书中的标准定义是将智能定义为实现目标的能力。而他将意识定义为主观体验。

“自动驾驶汽车会体验什么吗?自己开车有什么感觉吗?这就是意识的问题。智能和意识并不是一回事。我们可以有意识而不做任何智能的事情。如果我们只是坐在窗边欣赏美丽的景色,我们什么也没做,但我们在体验。我们也可以在没有意识的情况下变得聪明。”

当然,即使AI是完全无意识的,也可能杀死我们。“你不会说我一点都不担心那枚追着我的导弹,因为它什么都没有经历。我只关心它正朝我飞来。机器可以打败我们,可以在说服我们的过程中打败我们。现在很多青少年都被社交媒体和AI女朋友这些东西所击溃。”

泰格马克表示,人工智能是否有任何主观体验并不重要。重要的是它是否足够聪明来完成任务,控制我们或伤害我们。”进一步研究什么是意识,什么不是意识非常有趣,但这是一个科学问题。我们需要确保我们能够控制人工智能,无论它是否有意识。”

对于现场观众提出的类比奥本海默的问题,泰格马克表示,我们正处于人工智能的奥本海默时刻,类似于1942年物理学家们对费米制造出反应堆的担忧。“费米的反应堆不仅非常强大,而且他们意识到这是制造核武器所需要解决的最后一个技术障碍。物理学家们当时正确地预测出,只需要几年时间就能制造出第一颗核弹,果然仅仅到1945年就实现了。”

现在人工智能领域中,最好的系统已经能够欺骗42%的人认为它是人类,而最好的人类则能欺骗62%的人。泰格马克强调,掌握自主学习和知识的能力是实现超级智能的最大障碍,正如自持链式核反应堆是制造核武器的最大障碍一样。

泰格马克希望人类能够吸取核武器竞赛的教训,现在就认真听取警告,确保从一开始就构建安全的技术。

黄铁军进一步询问了去年发出公开信的后续影响。他本人也签署了这封信。过去一年来,虽然OpenAI没有发表GPT-5,但却发布了GPT-4o等模型,这是否象征着暂停先进AI研发的掩耳盗铃?

泰格马克表示,这封信的发布使得表达对人工智能发展的担忧在社会上变得公开化,许多人感到可以安全地加入对话并表达自己的担忧。这封信引发了政策制定者、政府和世界各地人民的关注,这是一件好事。技术作为一种工具,其本身既不善也不恶,而是取决于我们如何使用它。历史上,我们经常通过从错误中学习来引导技术的发展,但随着技术变得日益强大,这种策略变得不再适用。我们必须从被动应对转变为主动预防,以避免灾难性的错误。

他引用温斯顿·丘吉尔的话说:“我们从历史中学到的唯一东西就是我们从不吸取教训,但我持更乐观的态度。我认为我们可以从历史中学到重要的教训,尤其是在低估指数级增长技术的巨大危险这方面。”

面向中国观众,泰格马克还提到了在清朝末期(19世纪末),中国低估了工业革命的力量,殖民势力随即侵入。这是一个不应忘记的教训。同样地,全球正在低估人工智能革命的潜力和威胁。必须为此做好准备。

”此外,许多人认为最大的威胁来自其他国家,但真正的威胁是技术本身。如果我们以不安全的方式构建技术,那么最终所有人类都将失败,而机器将成为唯一的赢家,” 泰格马克说。

4.中国在AI安全上的机会

![]()

在本次演讲里,泰格马克展示了自己对中国的了解与重视。他在PPT上加入了自己中国学生的合照,引入许多中文翻译说明,还展示了自己可以说的几句流利、标准的普通话。

他指出:“你们是地球上现存最古老的文明之一,在长期规划方面有着更强的传统。西方也有这样的传统。这正是我们所需要的态度,在这个未来中,人类、机器和机器可以和谐共存。”

但让他有些捶胸顿足的是,目前国际上正在建立一个全新的AI安全俱乐部,目前已有11个国家参与,预计将在10月于美国加州举行第一次国际会议。但他非常难过地发现名单上没有中国,但名单上的许多国家在AI安全研究方面的努力比中国少得多,所以他期待更快速地协调。

不过也有些人说,这种保证安全的人工智能永远不会及时准备就绪。但泰格马克认为这过于悲观。

“首先,这样问问题是一个巨大的错误。这意味着我们只是让每个人扩大规模,做他们想做的任何事情。这不是中国、美国或任何其他理性国家在处理强大技术时的做法。”

在监管方面,泰格马克提到美国有食品药品管理局、联邦航空管理局;中国有国家药品监督管理局、中国民航局等。中国国家药品监督管理局会告诉公司说,等你们进行临床试验后再谈,也就是把责任放在公司身上,要求他们达到标准。

第二个乐观的理由是,人们有时会提出,如果我们想要在某些地方之间方便地移动,或许应该建造桥梁,以确保人们能够安全地穿越,避免溺水等危险。然而有人可能会认为,由于我们尚未掌握建造真正长且安全的桥梁的技术,这项任务是没有希望的。这种消极的态度是不可取的。

相反,人们应该采取积极的态度,即使目前还不清楚如何建造非常长的桥梁,但可以从建造小型桥梁开始,尤其是在那些已经存在明显需求的地方。通过建造这些小型桥梁,我们将积累宝贵的桥梁建设经验。然后,我们可以利用这些经验,逐步发展和完善我们的技术,最终实现建造更长、更安全的桥梁。

历史上,许多地缘政治冲突在双方都意识到他们共同面临外部威胁时得到解决。泰格马克认为:“中国、西方和世界各地的顶尖思想家和科学家开始意识到未对齐的超级智能所带来的威胁,这可能是中美关系最好的事情。面对这一共同威胁,我们要么共同成功,利用这项技术造福全人类,要么会共同走向失败。”

总而言之,人工智可以做到很多了不起的事情,泰格马克说道。”我想引用 2000 年前西方神话中伊卡洛斯的故事。这个家伙长出了翅膀。所以他现在有了这项令人惊叹的技术,他可以用它做最鼓舞人心的事情。但他没有飞来飞去,享受生活,而是非常贪婪地说我想马上飞向太阳,然后他就死了。”

“人工智能赋予了人类智慧的翅膀,有了它,我们也能做最令人惊奇、最鼓舞人心的事情。所以,让我们弄清楚如何安全地做到这一点,创造一个富足的时代,让生命在地球上甚至更远的地方蓬勃发展。在我们得到所有其他好处之前,不要贪婪地获取最后的 1%,也不要冒险浪费一切,就试图建立超级智能,” 泰格马克表示。

暂无评论内容